THUDM представляет GLM 4: Модель с 32 миллиардами параметров, конкурирующая с GPT-4o и DeepSeek-V3

В быстро развивающемся мире больших языковых моделей (LLMs) исследователи и организации сталкиваются с серьезными вызовами. К ним относятся улучшение способностей к рассуждению, обеспечение надежной многоязычной поддержки и эффективное управление сложными, открытыми задачами. Хотя меньшие модели часто более доступны и экономичны, они, как правило, уступают в производительности своим более крупным аналогам. Поэтому растет интерес к разработке моделей среднего размера, которые эффективно сочетают вычислительную эффективность с сильными способностями к рассуждению и выполнению инструкций.

Преимущества GLM 4

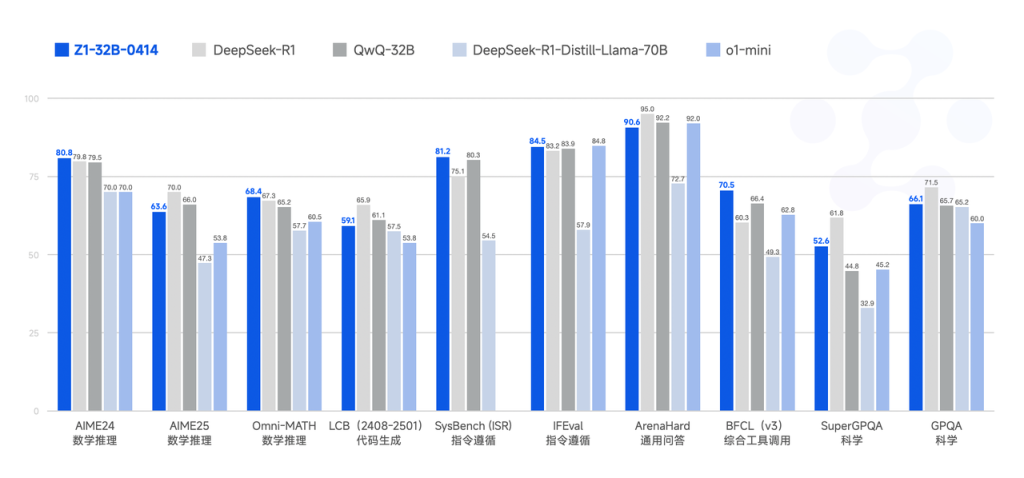

Недавний релиз GLM 4 от Университета Цинхуа, особенно вариант GLM-Z1-32B-0414, эффективно решает эти проблемы. Обученная на обширном наборе данных из 15 триллионов токенов, GLM 4 предлагает надежные многоязычные возможности и включает инновационные стратегии рассуждения, известные как “режим”. Этот релиз ставит GLM 4 наравне с другими заметными моделями, такими как DeepSeek Distill, QwQ и O1-mini, и распространяется под уважаемой лицензией MIT. Несмотря на относительно умеренный размер параметров в 32 миллиарда, GLM 4 демонстрирует производительность, сопоставимую с гораздо более крупными моделями, такими как GPT-4o и DeepSeek-V3, которые содержат до 671 миллиарда параметров, особенно в тестах на основе рассуждений.

Технические особенности

С технической точки зрения, GLM-Z1-32B-0414 использует обширные высококачественные обучающие данные, включая синтетически сгенерированные задачи на рассуждение, для укрепления аналитических способностей. Модель интегрирует сложные техники, такие как отбор с отбраковкой и обучение с подкреплением (RL), чтобы улучшить производительность в задачах, связанных с агентами, программированием, вызовом функций и вопросно-ответными задачами, основанными на поиске. Кроме того, ее вариант “Модель Рассуждения” дополнительно уточняет это, применяя методы холодного старта в сочетании с расширенным обучением RL, специально нацеливаясь на сложные математические, логические и программные задачи. Механизмы обратной связи по парному ранжированию используются во время обучения для повышения общей эффективности рассуждений модели.

Новые подходы и практическое применение

Расширенный вариант, GLM-Z1-Rumination-32B-0414, вводит новый подход, позволяющий длительное рефлексивное рассуждение для решения открытых, сложных запросов, таких как сравнительный анализ городов на основе ИИ. Этот вариант интегрирует продвинутые инструменты поиска с многоцелевым обучением с подкреплением, значительно увеличивая его полезность в исследовательских задачах и сложных сценариях поиска. В дополнение к этим более крупным моделям, версия GLM-Z1-9B-0414 с 9 миллиардами параметров демонстрирует сильные математические и общие способности к рассуждению, подчеркивая практичность моделей меньшего масштаба.

Результаты и выводы

Данные о производительности из оценок на бенчмарках подчеркивают сильные стороны серии GLM 4. В частности, GLM-4-32B-0414 показывает надежные результаты по сравнению с GPT-4o, DeepSeek-V3 и Qwen2.5-Max по нескольким бенчмаркам. На бенчмарке IFEval, оценивающем выполнение инструкций, GLM 4 набирает впечатляющие 87.6. В бенчмарках автоматизации задач, таких как TAU-Bench, GLM 4 достигает высоких результатов в таких сценариях, как розничная торговля (68.7) и авиаперевозки (51.2). Для задач вопросно-ответного поиска, оцененных по SimpleQA, модель фиксирует высокий балл 88.1. Кроме того, GLM 4 близок к производительности GPT-4o в задачах вызова функций, оцененных по бенчмарку BFCL-v3, получая общий балл 69.6. В практических сценариях ремонта кода, протестированных через SWE-bench с использованием фреймворка Moatless, GLM 4 достигает коэффициента успеха 33.8%, подчеркивая его практическую ценность.

Заключение

В заключение, GLM 4 представляет собой эффективную семью языковых моделей, успешно преодолевающую разрыв в производительности между меньшими, более доступными моделями и традиционно превосходящими крупными аналогами. Серия GLM-Z1, особенно вариант 32B, иллюстрирует этот сбалансированный подход, предоставляя мощные возможности рассуждения при сохранении вычислительной доступности. С дополнительным преимуществом своей разрешительной лицензии MIT, GLM 4 позиционируется как надежный инструмент для исследований и корпоративных приложений, требующих высокопроизводительных ИИ-решений без значительных вычислительных затрат, традиционно связанных с более крупными моделями.

Практические рекомендации

Изучите, как технологии искусственного интеллекта могут преобразовать ваш подход к работе. Найдите процессы, которые можно автоматизировать, и моменты в взаимодействии с клиентами, где ИИ может добавить наибольшую ценность. Определите важные KPI, чтобы убедиться, что ваши инвестиции в ИИ действительно оказывают положительное влияние на бизнес. Выберите инструменты, которые соответствуют вашим потребностям и позволяют настраивать их в соответствии с вашими целями. Начните с небольшого проекта, соберите данные о его эффективности и постепенно расширяйте использование ИИ в вашей работе.

Контакты

Если вам нужна помощь в управлении ИИ в бизнесе, свяжитесь с нами по адресу hello@itinai.ru. Чтобы быть в курсе последних новостей ИИ, подписывайтесь на наш Telegram.

Пример решения на основе ИИ

Посмотрите на практический пример решения на основе ИИ: бот для продаж от itinai.ru/aisales, предназначенный для автоматизации взаимодействия с клиентами круглосуточно и управления взаимодействиями на всех этапах клиентского пути.