WaveletGPT: Использование теории вейвлетов для ускоренного обучения LLM в различных модальностях

Основные моменты:

Большие языковые модели (LLM) революционизировали искусственный интеллект, влияя на различные научные и инженерные дисциплины. Архитектура Transformer, изначально разработанная для машинного перевода, стала основой для моделей GPT, значительно продвигая область. Однако существующие LLM сталкиваются с вызовами в подходе к обучению, что приводит к проблемам масштабирования и эффективности.

Практические решения и ценность:

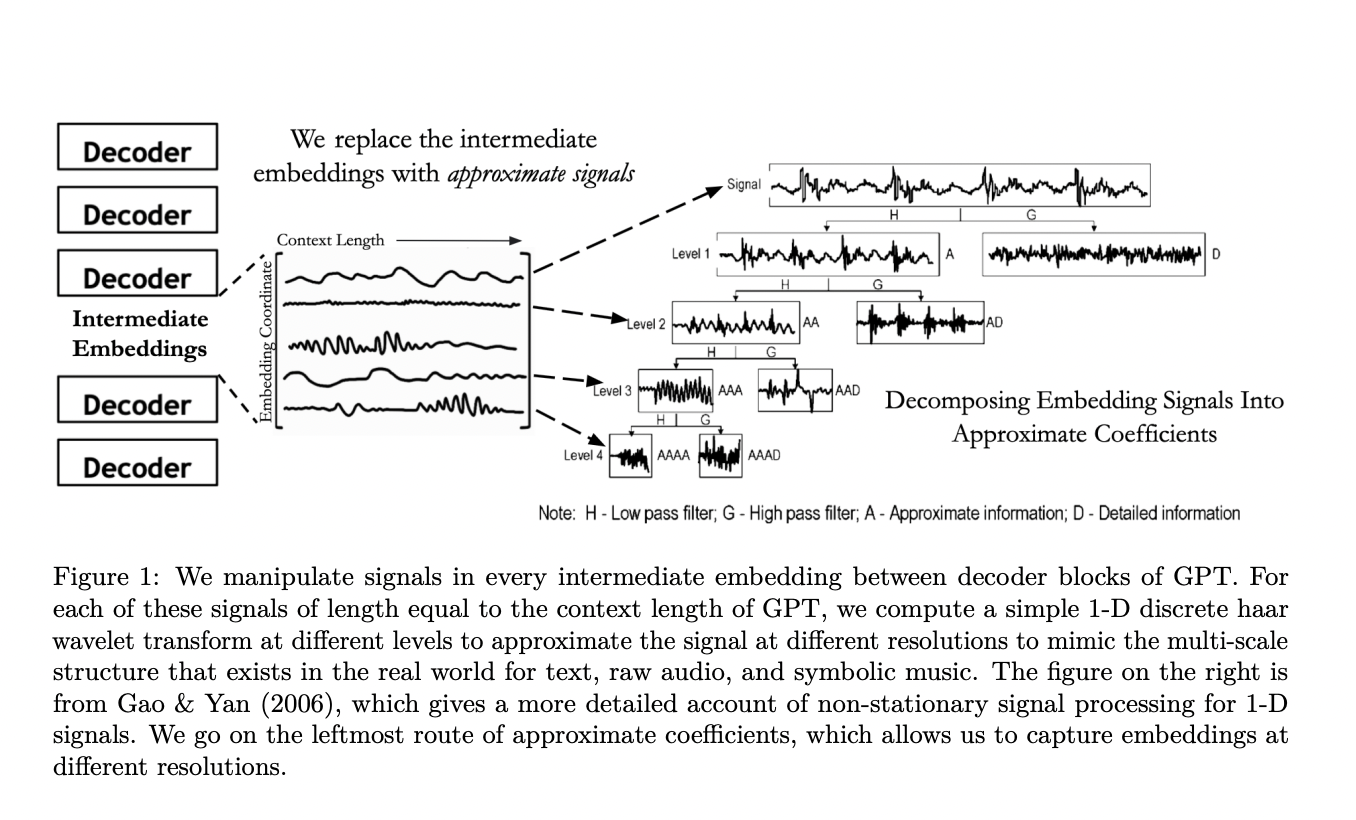

Исследователи предложили метод WaveletGPT, который улучшает LLM, добавляя вейвлеты в их архитектуру. Этот метод ускоряет предварительное обучение моделей на основе трансформера на 40-60% без добавления дополнительных параметров, что значительное преимущество. Техника также демонстрирует значительное улучшение производительности при том же количестве шагов обучения, сравнимое с добавлением нескольких слоев или параметров. WaveletGPT показывает улучшение производительности в трех различных модальностях: язык, аудио и музыка, что подчеркивает его универсальность для структурированных наборов данных.

Будущие направления:

Потенциальные будущие направления включают в себя интеграцию продвинутых концепций из области вейвлетов и многоразрешенной обработки сигналов для оптимизации больших языковых моделей.

за 6 месяцев.

А что бы вы сделали с этими деньгами?

за 6 месяцев.

А что бы вы сделали с этими деньгами? за 3 месяца. Какие процессы в вашем бизнесе скинуть роботу?

за 3 месяца. Какие процессы в вашем бизнесе скинуть роботу?  . Как это работает?

. Как это работает?  . Расскажите подробнее!

. Расскажите подробнее!