«`html

Применение искусственного интеллекта для улучшения бизнеса

Исследования в области искусственного интеллекта (ИИ) сосредотачиваются на тонкой настройке больших языковых моделей (LLM) для выравнивания их результатов с предпочтениями человека. Эта настройка гарантирует, что системы ИИ генерируют полезные, актуальные и соответствующие ожиданиям пользователя ответы. Текущая парадигма в области ИИ подчеркивает обучение на основе данных о предпочтениях человека для улучшения этих моделей, решая сложность ручной спецификации функций вознаграждения для различных задач. Два основных метода в этой области — это онлайн обучение с подкреплением (RL) и оффлайн контрастные методы, каждый из которых предлагает уникальные преимущества и вызовы.

Преимущества и вызовы методов тонкой настройки предпочтений в LLM

Центральной проблемой в тонкой настройке LLM для отражения предпочтений человека является ограниченное покрытие статических наборов данных. Эти наборы данных должны адекватно представлять разнообразный и динамический спектр человеческих предпочтений в реальных приложениях. Проблема покрытия набора данных становится особенно заметной, когда модели обучаются исключительно на заранее собранных данных, что потенциально приводит к субоптимальной производительности. Это подчеркивает необходимость методов эффективного использования статических наборов данных и данных в реальном времени для улучшения соответствия модели предпочтениям человека.

Новый метод HyPO для улучшения производительности модели

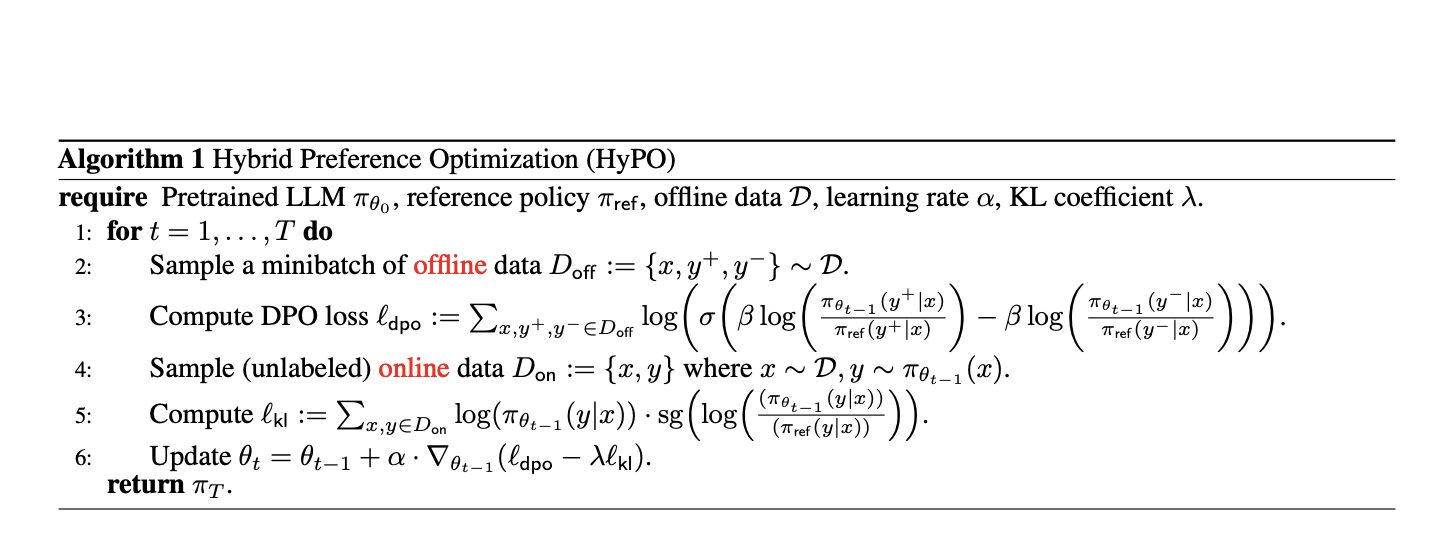

Исследователи из Университета Карнеги-Меллон, компании Aurora Innovation и Университета Корнелла представили новый метод под названием Hybrid Preference Optimization (HyPO). Этот гибридный подход объединяет возможности онлайн и оффлайн техник с целью улучшения производительности модели при сохранении вычислительной эффективности. HyPO использует оффлайн данные для начальной оптимизации предпочтений и онлайн неразмеченные данные для регуляризации Kullback-Leibler (KL), обеспечивая близость модели к эталонной политике и лучшую обобщаемость за пределами обучающих данных.

Эмпирические результаты и выводы

Производительность HyPO была оценена на нескольких бенчмарках, включая задачу TL;DR суммирования и общие бенчмарки чата, такие как AlpacaEval 2.0 и MT-Bench. Результаты были впечатляющими, с HyPO достигающим победного процента 46,44% на задаче TL;DR с использованием модели Pythia 1.4B, по сравнению с 42,17% для метода DPO. Для модели Pythia 2.8B HyPO достиг победного процента 50,50%, значительно превосходя 44,39% у DPO. Кроме того, HyPO продемонстрировал превосходное управление обратным KL-расхождением, со значениями 0,37 и 2,51 для моделей Pythia 1.4B и 2.8B соответственно, по сравнению с 0,16 и 2,43 для DPO.

В общих бенчмарках чата HyPO также показал заметные улучшения. Например, в оценке MT-Bench, модели, настроенные с помощью HyPO, достигли оценок 8,43 и 8,09 в среднем за первый и второй ходы, превзойдя оценки моделей, настроенных с помощью DPO, в 8,31 и 7,89. Аналогично, в AlpacaEval 2.0 HyPO достиг победных процентов 30,7% и 32,2% для 1-го и 2-го ходов, по сравнению с 28,4% и 30,9% у DPO.

Эмпирические результаты подчеркивают способность HyPO смягчать проблемы переобучения, часто наблюдаемые в оффлайн контрастных методах. Например, при обучении на наборе данных TL;DR HyPO поддерживал средний показатель KL-расхождения валидации значительно ниже, чем у DPO, что указывает на лучшее соответствие эталонной политике и снижение переобучения. Эта способность использовать онлайн данные для регуляризации помогает HyPO достигать более надежной производительности в различных задачах.

Заключение

Введение гибридной оптимизации предпочтений (HyPO), которая эффективно объединяет оффлайн и онлайн данные, решает ограничения существующих методов и улучшает соответствие больших языковых моделей предпочтениям человека. Улучшения производительности, продемонстрированные в эмпирических оценках, подчеркивают потенциал HyPO для создания более точных и надежных систем искусственного интеллекта.

Подробнее о статье можно узнать здесь. Вся заслуга за это исследование принадлежит его авторам. Также не забудьте подписаться на наш Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit с более чем 47 тысячами участников.

Найдите предстоящие вебинары по ИИ здесь.

Оригинал статьи опубликован на сайте MarkTechPost.

«`