Мультимодельные модели в искусственном интеллекте

Практические решения и ценность

Мультимодельные модели представляют собой значительный прогресс в области искусственного интеллекта, позволяя системам обрабатывать и понимать данные из различных источников, таких как текст и изображения. Эти модели необходимы для приложений, таких как подписывание изображений, ответы на визуальные вопросы и помощь в робототехнике, где понимание визуальных и языковых входов критично.

Сегодня многие высокопроизводительные мультимодельные модели создаются с использованием закрытых данных, что ограничивает доступ к ним для широкого научного сообщества и тормозит инновации в открытом исследовании в области ИИ.

Проблема развития открытых мультимодельных моделей заключается в зависимости от данных, созданных закрытыми системами. Закрытые системы, такие как GPT-4V и Claude 3.5, создают высококачественные синтетические данные, которые помогают моделям достигать впечатляющих результатов, но эти данные недоступны всем. Исследователи сталкиваются с препятствиями при попытках воспроизвести или улучшить эти модели, и научному сообществу необходима основа для создания таких моделей с нуля, используя полностью открытые наборы данных.

Методы обучения мультимодельных моделей часто полагаются на дистилляцию из закрытых систем. Многие модели видео-языка, например, используют данные, такие как ShareGPT4V, созданные GPT-4V, для обучения своих систем. Открытые модели были разработаны, но часто значительно уступают своим закрытым аналогам. Также эти модели ограничены доступом к высококачественным наборам данных, что затрудняет сокращение разрыва в производительности по сравнению с закрытыми системами.

Исследователи из Allen Institute for AI и Университета Вашингтона представили семейство моделей видео-языка Molmo. Это новое семейство моделей представляет собой прорыв в области, предоставляя полностью открытое решение без весов и данных. Molmo не зависит от синтетических данных закрытых систем, что делает его полностью доступным инструментом для научного сообщества по исследованиям в области ИИ.

Первый выпуск включает несколько ключевых компонентов:

- MolmoE-1B: Построен с использованием полностью открытой модели большой языковой модели OLMoE-1B-7B.

- Molmo-7B-O: Использует полностью открытую модель OLMo-7B-1024, запланированную к предварительному выпуску в октябре 2024 года, с полным публичным выпуском позже.

- Molmo-7B-D: Демонстрационная модель, использующая открытую модель Qwen2 7B.

- Molmo-72B: Самая производительная модель в семействе, использующая открытую модель Qwen2 72B.

Модели Molmo обучаются с использованием простой, но мощной конвейерной системы, объединяющей предварительно обученный визионный кодер с языковой моделью. Визионный кодер основан на модели CLIP ViT-L/14 от OpenAI, обеспечивающей надежную токенизацию изображений. Набор данных PixMo от Molmo, содержащий более 712 000 изображений и приблизительно 1,3 миллиона подписей, является основой для обучения моделей для генерации плотных, подробных описаний изображений.

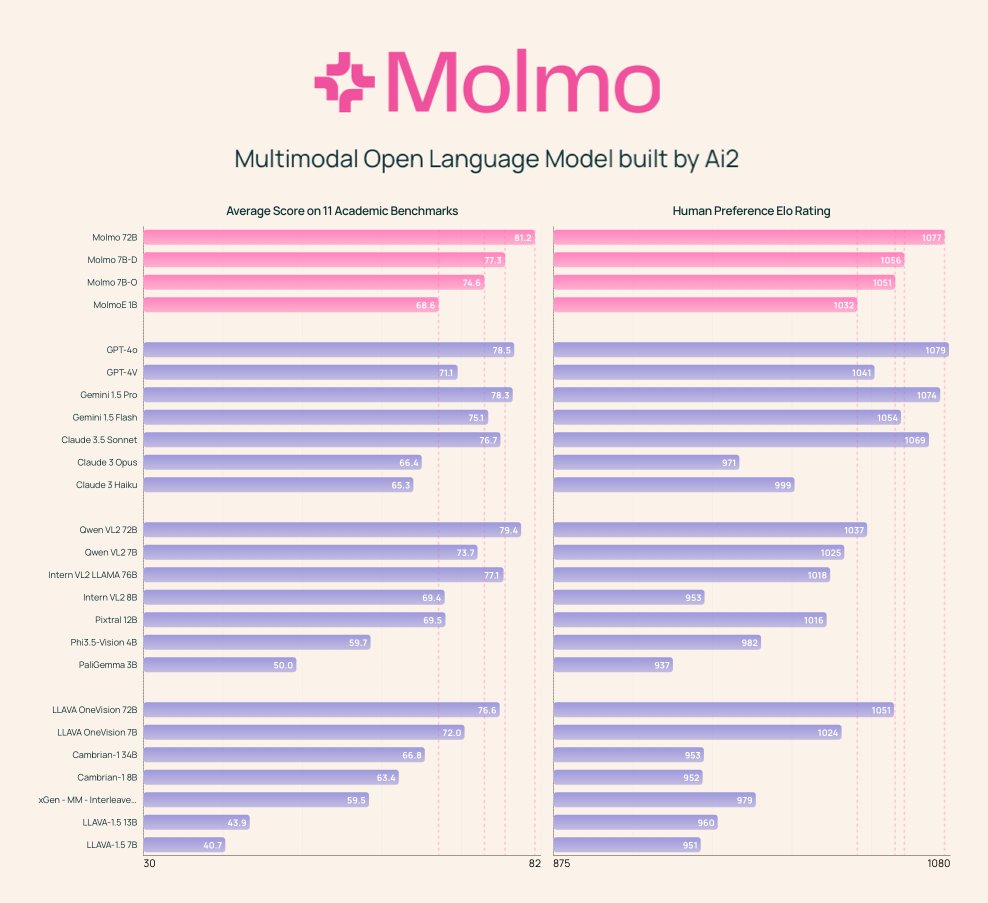

Модель Molmo-72B, самая передовая в семействе, превзошла многие ведущие закрытые системы, включая Gemini 1.5 и Claude 3.5 Sonnet, на 11 академических бенчмарках. Она также заняла второе место в человеческой оценке с 15 000 пар изображений и текста, немного уступив GPT-4o. Модель показала лучшие результаты в бенчмарке AndroidControl, достигнув точности 88,7% для задач низкого уровня и 69,0% для задач высокого уровня.

В заключение, разработка семейства Molmo предоставляет научному сообществу мощную альтернативу закрытым системам, предлагая полностью открытые веса, наборы данных и исходный код. Выпуск этих моделей, вместе с соответствующими наборами данных PixMo, открывает путь для будущих инноваций и сотрудничества в развитии моделей видео-языка, обеспечивая научному сообществу необходимые инструменты для продолжения расширения границ ИИ.

Проверьте модели на странице HF, демонстрации и деталях. Вся заслуга за это исследование принадлежит ученым этого проекта.

Не забудьте присоединиться к нашему Telegram-каналу и следить за новостями о ИИ!