«`html

Технологии искусственного интеллекта (ИИ) в сети нейронных сетей

Применение линейной алгебры для оптимизации матричных операций

Большинство топологий нейронных сетей тесно связаны с операциями матричного умножения (MatMul), поскольку они необходимы для множества базовых процессов. Векторно-матричное умножение (VMM) часто используется в плотных слоях нейронных сетей, а матрично-матричное умножение (MMM) применяется в механизмах самовнимания. Тяжелая зависимость от MatMul во многом обусловлена оптимизацией для графических процессоров (GPU) при выполнении данных задач. Использование библиотек линейной алгебры, таких как cuBLAS и технологии CUDA, позволяет эффективно параллельно выполнять операции MatMul, что заметно повышает производительность.

Исследование эффективности больших языковых моделей (LLMs)

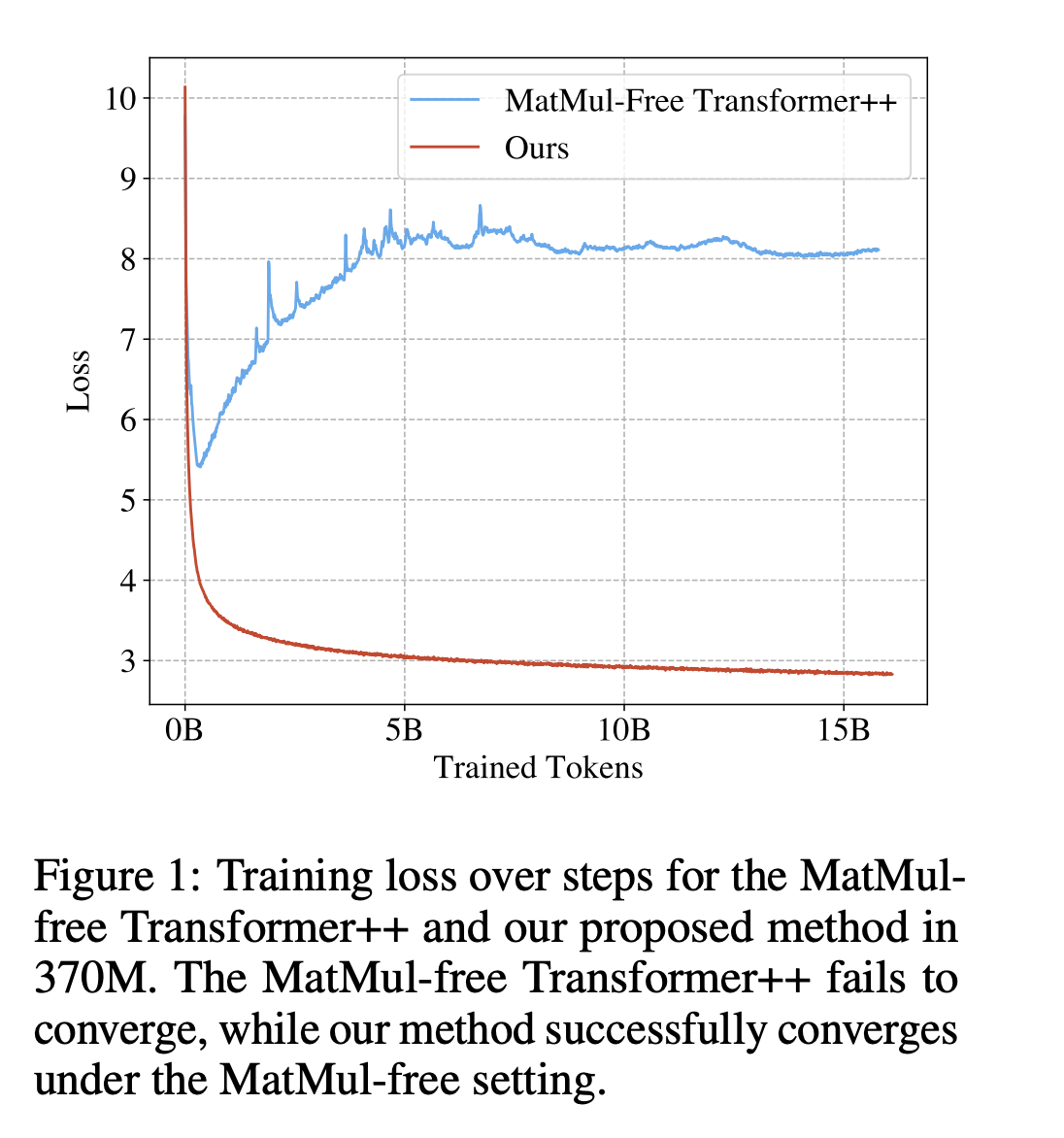

Большие языковые модели (LLMs) часто требуют основную вычислительную работу выполнения матричного умножения. По мере увеличения размеров вложенных пространств и длины контекста эта нагрузка только увеличивается. Даже на масштабах с миллиардами параметров возможно полностью устранить процессы MatMul из LLMs без ущерба для надежной производительности.

Результаты исследования

Недавнее исследование команды из Университета Калифорнии в Санта-Круз, Сучжоуского университета, Университета Калифорнии в Дэвисе и LuxiTech показало, что для моделей размером до 2,7 миллиарда параметров MatMul-свободные модели могут достичь производительности, близкой к уровню современных трансформеров, требующих намного больше памяти для вывода. Команда выяснила, что разница в производительности между MatMul-свободными моделями и обычными трансформерами с полной точностью сокращается по мере увеличения размера модели. Это говорит о том, что большие модели не обязательно должны полагаться на операции MatMul для успешной и эффективной работы.

Практические применения

Команда разработала эффективную версию для GPU, снижающую использование памяти на 61% по сравнению с неоптимизированным базовым вариантом во время тренировки. Они использовали оптимизированное ядро для вывода, которое сокращает потребление памяти в десять раз по сравнению с неоптимизированными моделями. Таким образом, эти модели стали более доступными для различных приложений и более эффективными благодаря значительному снижению потребления памяти.

Команда также разработала уникальное аппаратное решение на программируемом пользовательском вентиле (FPGA), чтобы полностью использовать легковесную природу этих моделей. Эта технология обрабатывает модели масштаба с миллиардами параметров при потреблении 13 ватт, используя легковесные операции, выходящие за рамки возможностей текущих GPU. Это эффективность приближает LLM к энергоэффективности, приближаясь к энергопотреблению человеческого мозга.

Исследование показало, что значительное упрощение сложности LLM возможно без ущерба для их эффективной работы. Оно также показывает, на какие операции следует сосредоточиться следующему поколению аппаратных ускорителей, чтобы обрабатывать легковесные LLM. Благодаря этому развитию стали возможны реализации больших языковых моделей, более эффективных, масштабируемых и полезных.

Подробнее ознакомьтесь с исследованием и репозиторием на GitHub. Вся заслуга за это исследование принадлежит ученым этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам интересно наше исследование, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему сообществу в SubReddit и ознакомиться с нашей платформой по событиям по ИИ.

Этот пост опубликован на портале MarkTechPost.

Практическое применение технологий ИИ в вашем бизнесе

Получите консультацию по внедрению ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте This AI Research Discusses Achieving Efficient Large Language Models (LLMs) by Eliminating Matrix Multiplication for Scalable Performance.

Использование ИИ для автоматизации и улучшения бизнес-процессов

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Выберите оптимальное решение на основе ИИ

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ. Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI. На полученных данных и опыте расширяйте автоматизацию.

Следите за новостями о ИИ и получайте консультации

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter Twitter.

AI Sales Bot для автоматизации отдела продаж

Попробуйте AI Sales Bot – это ИИ ассистент в продажах, помогающий отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

ИИ-решения для изменения бизнес-процессов

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru – будущее уже здесь!

«`