Исследование контекстного обучения с подкреплением в LLM с помощью разреженных автокодировщиков

Практические решения и ценность

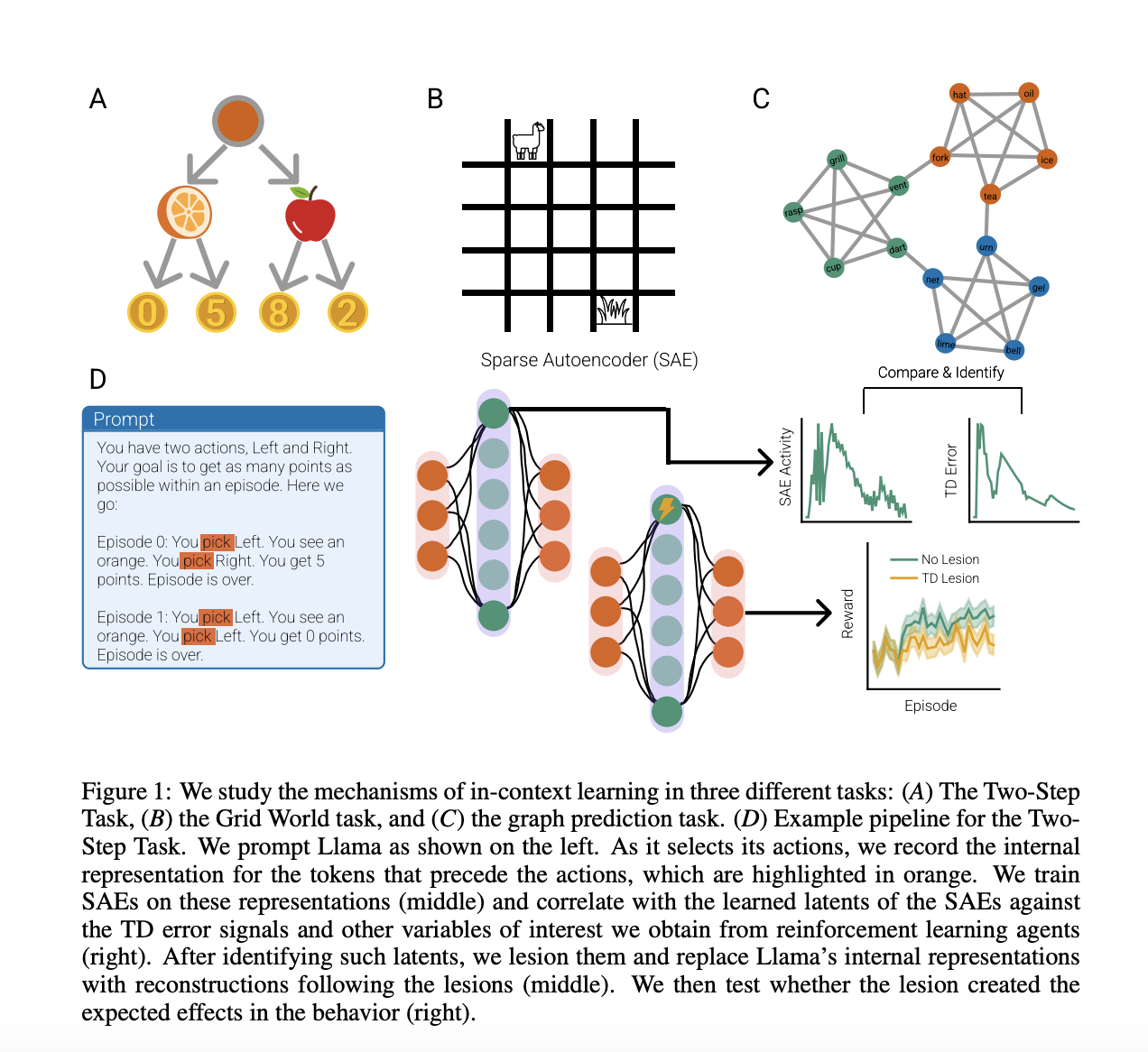

Большие языковые модели (LLM) показали удивительные способности к контекстному обучению в различных областях, включая перевод, функциональное обучение и обучение с подкреплением. Ранее исследователи изучали механизмы контекстного обучения с механистической точки зрения, демонстрируя, что трансформеры могут обнаруживать существующие алгоритмы без явного руководства. Использование разреженных автокодировщиков позволяет анализировать представления, поддерживающие контекстное обучение, и раскрывать внутренние механизмы моделей.

Исследователи изучили способность LLM к обучению графовых структур без вознаграждения, используя концепцию Successor Representation (SR). Результаты показали, что Llama быстро научился предсказывать следующее состояние с высокой точностью и разработал представления, аналогичные SR, захватывая глобальную геометрию графа.

Это исследование демонстрирует, что LLM реализует обучение по временной разнице (TD) для решения проблем обучения с подкреплением в контексте. Использование разреженных автокодировщиков позволяет идентифицировать и управлять ключевыми характеристиками для контекстного обучения, демонстрируя их влияние на поведение и представления LLM.