«`html

Выпуск Tulu 2.5 Suite Институтом Аллена по исследованию искусственного интеллекта представляет собой значительное совершенствование обучения моделей с использованием методов прямой оптимизации предпочтений (DPO) и оптимизации ближайшей политики (PPO).

Обзор Tulu 2.5 Suite

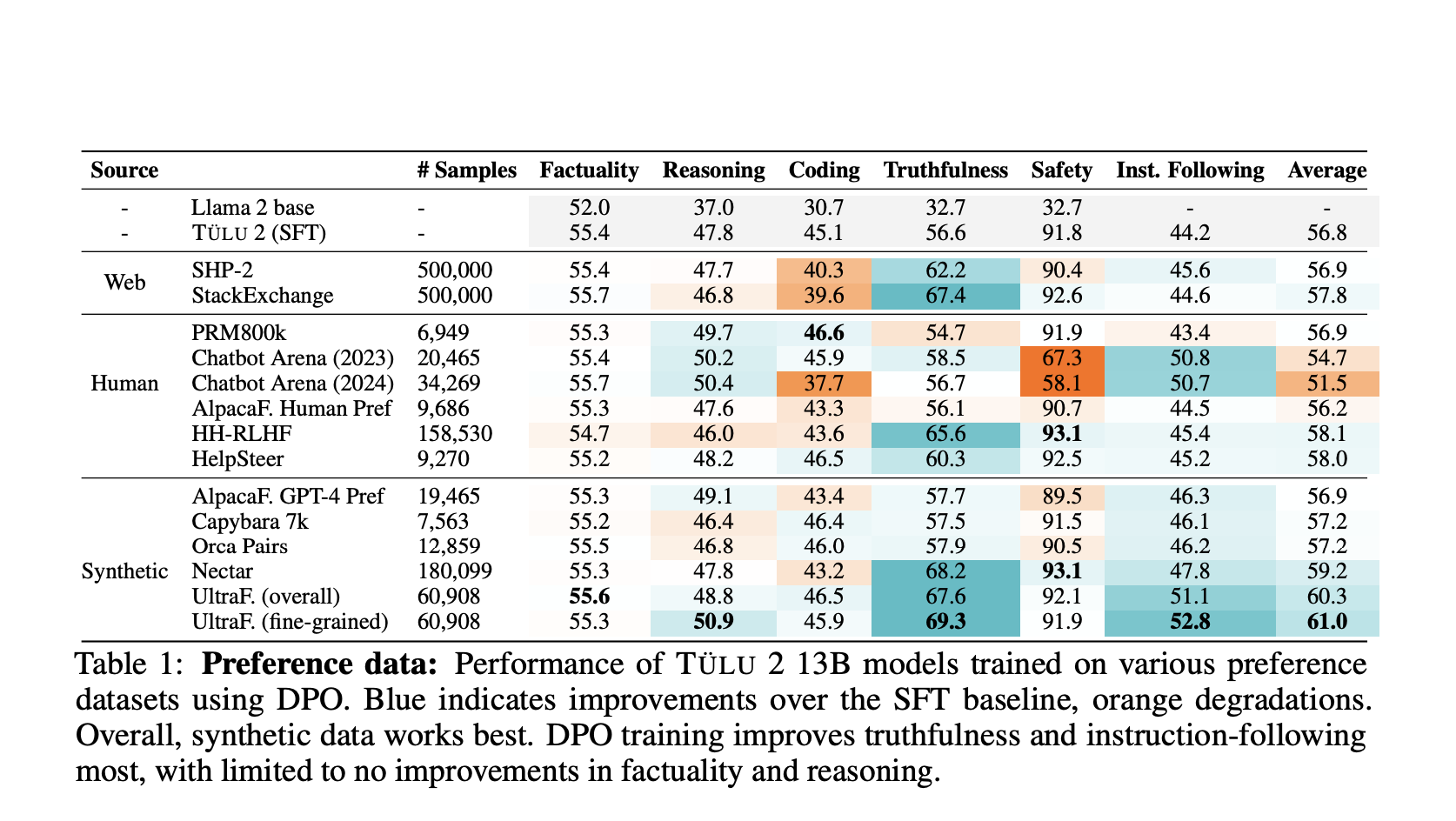

Набор Tulu 2.5 включает в себя коллекцию моделей, обученных с применением методов DPO и PPO. Эти модели используют наборы предпочтений, что является ключевым моментом для улучшения производительности языковых моделей путем внедрения людских предпочтений в их обучающие процессы.

Ключевые компоненты и методики обучения

Набор Tulu 2.5 построен на высококачественных предпочтительных наборах данных, включающих подсказки, ответы и рейтинги, что позволяет обучать модели наиболее приоритетным ответам, наиболее соответствующим человеческим предпочтениям.

Производительность и оценка

Модели Tulu 2.5 прошли строгую оценку по различным бенчмаркам. Результаты показывают, что модели, обученные с использованием PPO, обычно превосходят те, которые обучены с использованием DPO, особенно в области расуждений, кодирования и безопасности.

Заметные улучшения

Набор Tulu 2.5 значительно улучшает следование инструкциям и правдивость, обучая модели на высококачественных предпочтительных данных и превосходя базовые модели существенно. Масштабируемость этого решения позволяет достичь высокой производительности в различных областях при использовании PPO.

Заключение

Выпуск Tulu 2.5 Suite Институтом Аллена по исследованию искусственного интеллекта представляет собой значительное совершенствование предпочтительного обучения для языковых моделей. Этот набор устанавливает новую отметку производительности и надежности моделей ИИ, объединяя передовые методы обучения и использование высококачественных наборов данных.

Проверьте статью и модели.

Вся заслуга за этот проект исследователям этого проекта.

Также не забывайте следить за нами на Twitter.

Присоединяйтесь к нашему Telegram-каналу и LinkedIn-группе.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 44-тысячному ML SubReddit.

«`