«`html

Руководство по GuideLLM от Neural Magic: мощный инструмент для оценки и оптимизации развертывания больших языковых моделей (LLM)

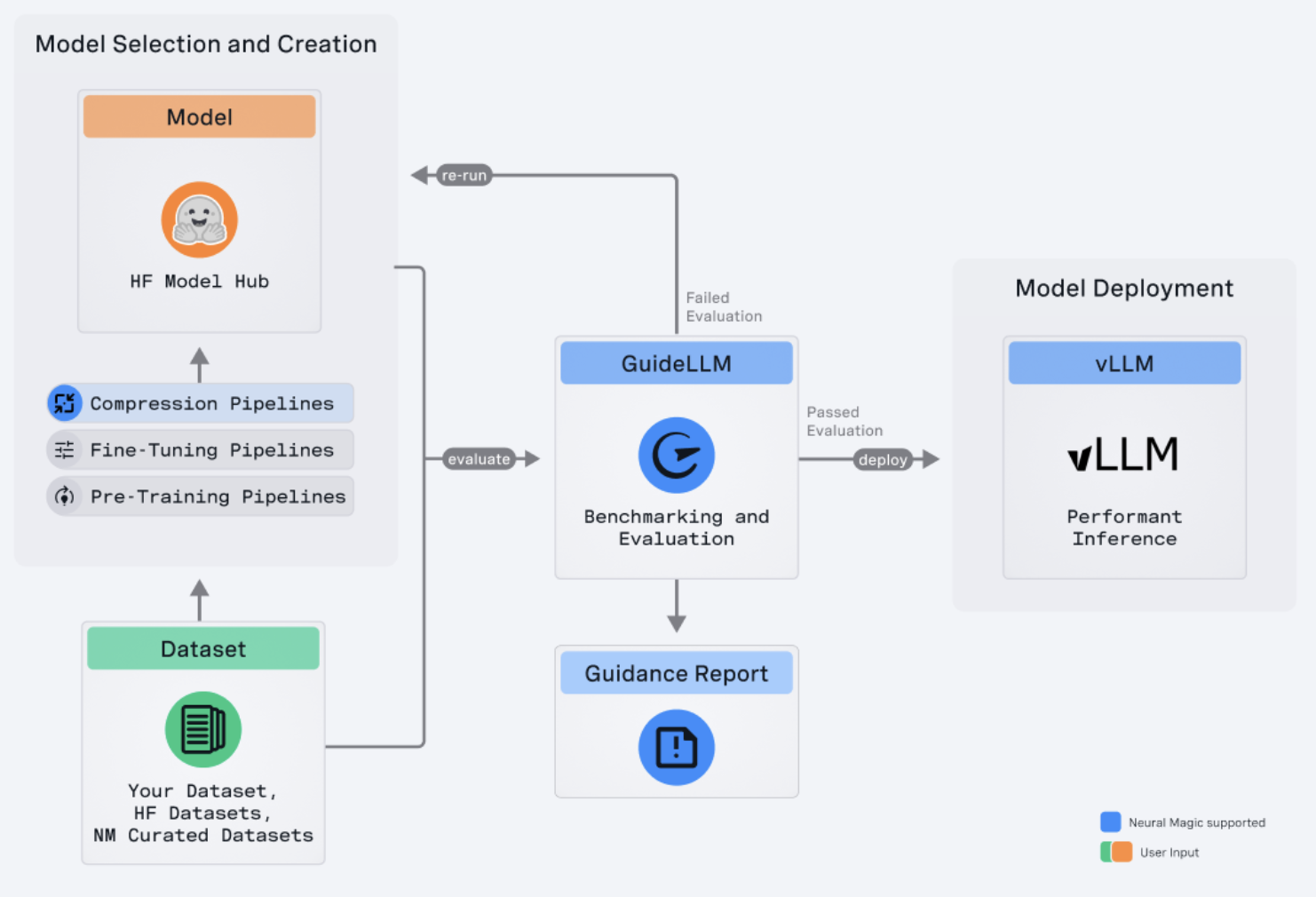

Развертывание и оптимизация больших языковых моделей (LLM) стали критическими для различных приложений. Neural Magic представила GuideLLM, чтобы удовлетворить растущую потребность в эффективном, масштабируемом и экономичном развертывании LLM. Этот мощный инструмент с открытым исходным кодом разработан для оценки и оптимизации развертывания LLM, обеспечивая их соответствие требованиям реального мира по производительности и минимальному потреблению ресурсов.

Обзор GuideLLM

GuideLLM — это комплексное решение, которое помогает пользователям оценить производительность, потребности в ресурсах и финансовые последствия развертывания больших языковых моделей на различных аппаратных конфигурациях. Путем моделирования рабочих нагрузок реального мира GuideLLM позволяет пользователям убедиться, что их развертывания LLM являются эффективными и масштабируемыми, не жертвуя качеством обслуживания. Этот инструмент особенно ценен для организаций, стремящихся развернуть LLM в производственных средах, где производительность и стоимость являются критическими факторами.

Основные функции GuideLLM

GuideLLM предлагает несколько ключевых функций, которые делают его незаменимым инструментом для оптимизации развертывания LLM:

- Оценка производительности: GuideLLM позволяет пользователям анализировать производительность своих LLM в различных сценариях нагрузки, гарантируя, что развернутые модели соответствуют желаемым целям уровня обслуживания (SLO), даже при высоком спросе.

- Оптимизация ресурсов: Путем оценки различных аппаратных конфигураций GuideLLM помогает пользователям определить наиболее подходящую настройку для эффективного запуска их моделей. Это приводит к оптимизации использования ресурсов и потенциально значительным экономиям.

- Оценка стоимости: Понимание финансового влияния различных стратегий развертывания критично для принятия обоснованных решений. GuideLLM предоставляет пользователям понимание финансовых последствий различных конфигураций, позволяя им минимизировать расходы, сохраняя при этом высокую производительность.

- Тестирование масштабируемости: GuideLLM может моделировать сценарии масштабирования для обработки большого числа одновременных пользователей. Эта функция важна для обеспечения масштабируемости развертывания без ухудшения производительности, что критично для приложений, испытывающих переменную нагрузку.

Начало работы с GuideLLM

Для начала использования GuideLLM пользователям необходимо иметь совместимую среду. Инструмент поддерживает операционные системы Linux и MacOS и требует версий Python от 3.8 до 3.12. Установка проста через PyPI, индекс пакетов Python, с использованием команды pip. После установки пользователи могут оценить свои развертывания LLM, запустив совместимый сервер, такой как vLLM, который рекомендуется для проведения оценок.

Проведение оценок

GuideLLM предоставляет интерфейс командной строки (CLI), который пользователи могут использовать для оценки своих развертываний LLM. GuideLLM может моделировать различные сценарии нагрузки и выводить подробные показатели производительности, указав имя модели и детали сервера. Эти метрики включают задержку запроса, время до первого токена (TTFT) и межтокенную задержку (ITL), которые критичны для понимания эффективности и отзывчивости развертывания.

Например, если развернуто чувствительное к задержке приложение чата, пользователи могут оптимизировать для низкой TTFT и ITL, чтобы обеспечить плавное и быстрое взаимодействие. С другой стороны, для приложений, чувствительных к пропускной способности, таких как текстовая суммаризация, GuideLLM может помочь определить максимальное количество запросов, которое сервер может обработать в секунду, указывая пользователям необходимые корректировки для удовлетворения спроса.

Настройка оценок

GuideLLM настраиваем, позволяя пользователям адаптировать оценки под свои потребности. Пользователи могут настраивать длительность запусков тестов, количество одновременных запросов и скорость запросов, чтобы соответствовать своим сценариям развертывания. Инструмент также поддерживает различные типы данных для тестирования, включая эмулированные данные, файлы и трансформеры, обеспечивая гибкость в тестировании различных аспектов развертывания.

Анализ и использование результатов

После завершения оценки GuideLLM предоставляет подробное резюме результатов. Эти результаты бесценны для выявления узких мест в производительности, оптимизации скорости запросов и выбора наиболее экономичных аппаратных конфигураций. Используя эти исследования, пользователи могут принимать решения на основе данных для улучшения своих развертываний LLM и достижения требований по производительности и стоимости.

Сообщество и участие

Neural Magic призывает к участию сообщества в развитии и улучшении GuideLLM. Пользователи приглашаются к внесению вклада в кодовую базу, сообщению о найденных ошибках, предложению новых функций и участию в обсуждениях для помощи развитию инструмента. Проект является открытым и распространяется под лицензией Apache License 2.0, поощряя сотрудничество и инновации в сообществе искусственного интеллекта.

В заключение, GuideLLM предоставляет инструменты для оценки производительности, оптимизации ресурсов, оценки стоимости и тестирования масштабируемости. Он дает пользователям возможность развертывать LLM эффективно и эффективно в реальных средах. Будь то для исследований или производства, GuideLLM предлагает необходимые инсайты для обеспечения того, что развертывания LLM являются высокопроизводительными и экономичными.

Проверьте ссылку на GitHub. Вся заслуга за этот исследовательский проект принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашей группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу 50k+ ML SubReddit.

Вот рекомендуемый вебинар от нашего спонсора: ‘Построение производительных приложений ИИ с использованием NVIDIA NIMs и Haystack’.

Статья опубликована на портале MarkTechPost.