Преимущества модели bge-en-icl в генерации текстовых вложений

Описание проблемы

В создании качественных текстовых вложений для различных задач стоит перед нами серьезное вызов в области обработки естественного языка (NLP). Существующие модели вложений, несмотря на прогресс, часто не могут эффективно справляться с незнакомыми задачами и сложными операциями поиска. Эти ограничения препятствуют им динамической адаптации к различным контекстам, что является критическим требованием для реальных приложений.

Решение

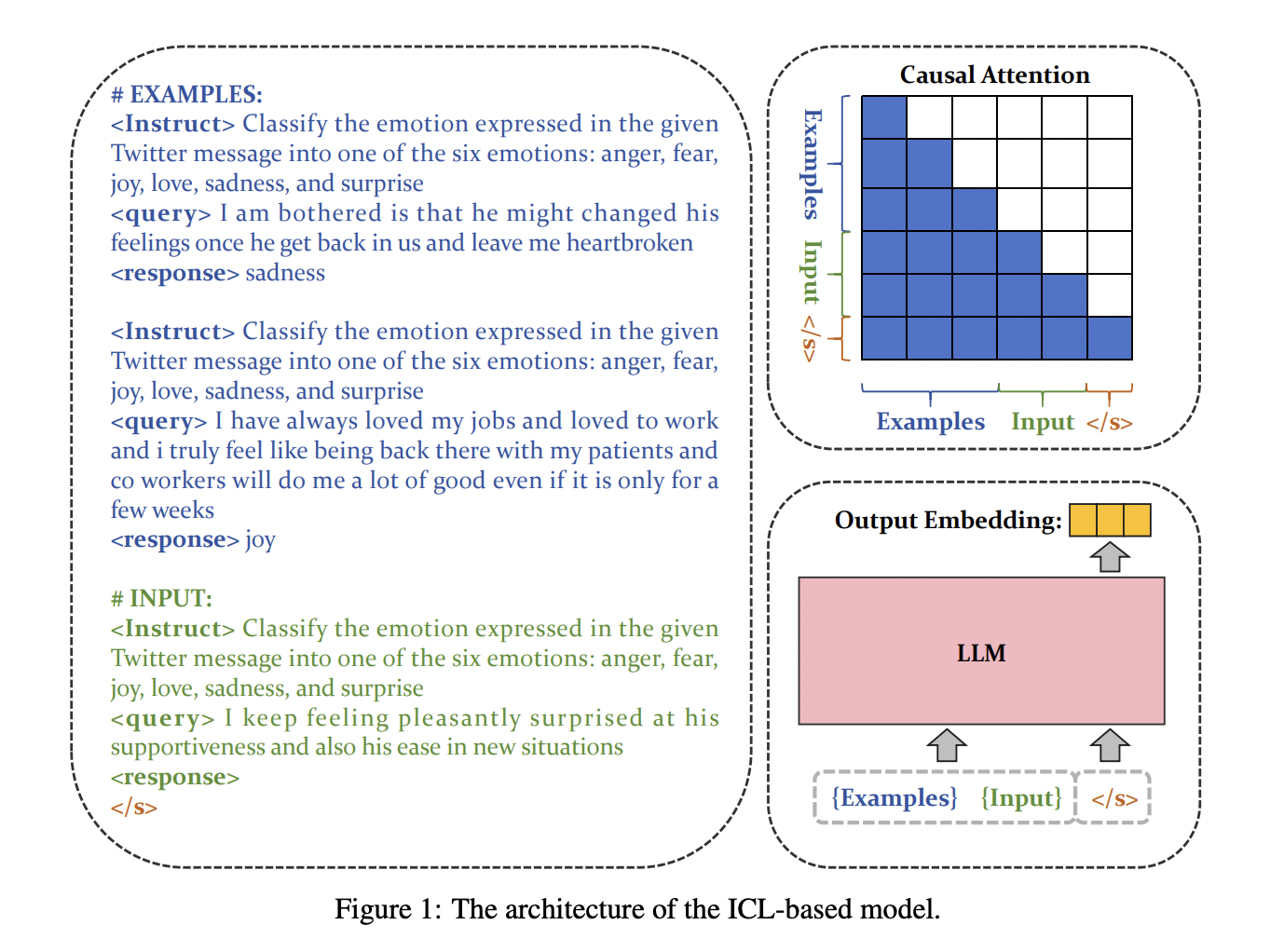

Для преодоления этого вызова и развития AI необходимо внедрение новой модели bge-en-icl, которая использует возможности контекстного обучения LLM для улучшения генерации текстовых вложений. Этот подход позволяет интегрировать примеры, специфичные для задачи, непосредственно в запрос, что позволяет модели генерировать вложения, более релевантные и обобщаемые для различных задач.

Практическое применение

Модель bge-en-icl основана на основе Mistral-7B, известной своей эффективностью в задачах NLP. Она использует контекстное обучение во время тренировки, что позволяет модели изучать вложения, специфичные для задачи и обобщаемые. Модель настраивается с использованием функции потерь контрастности, что обеспечивает максимальную схожесть между соответствующими парами запрос-проход, минимизируя ее для несоответствующих. Тестирование модели показало превосходство в сравнении с другими моделями, особенно в сценариях обучения на небольшом объеме данных.