«`html

Технологии ИИ: применение ChatQA 2 для обработки больших текстовых объемов

Понимание длинного контекста и расширенная генерация с поиском (RAG) в больших языковых моделях (LLM) быстро развивается, обеспечивая точные и эффективные ответы на обширные текстовые запросы.

Преимущества модели ChatQA 2:

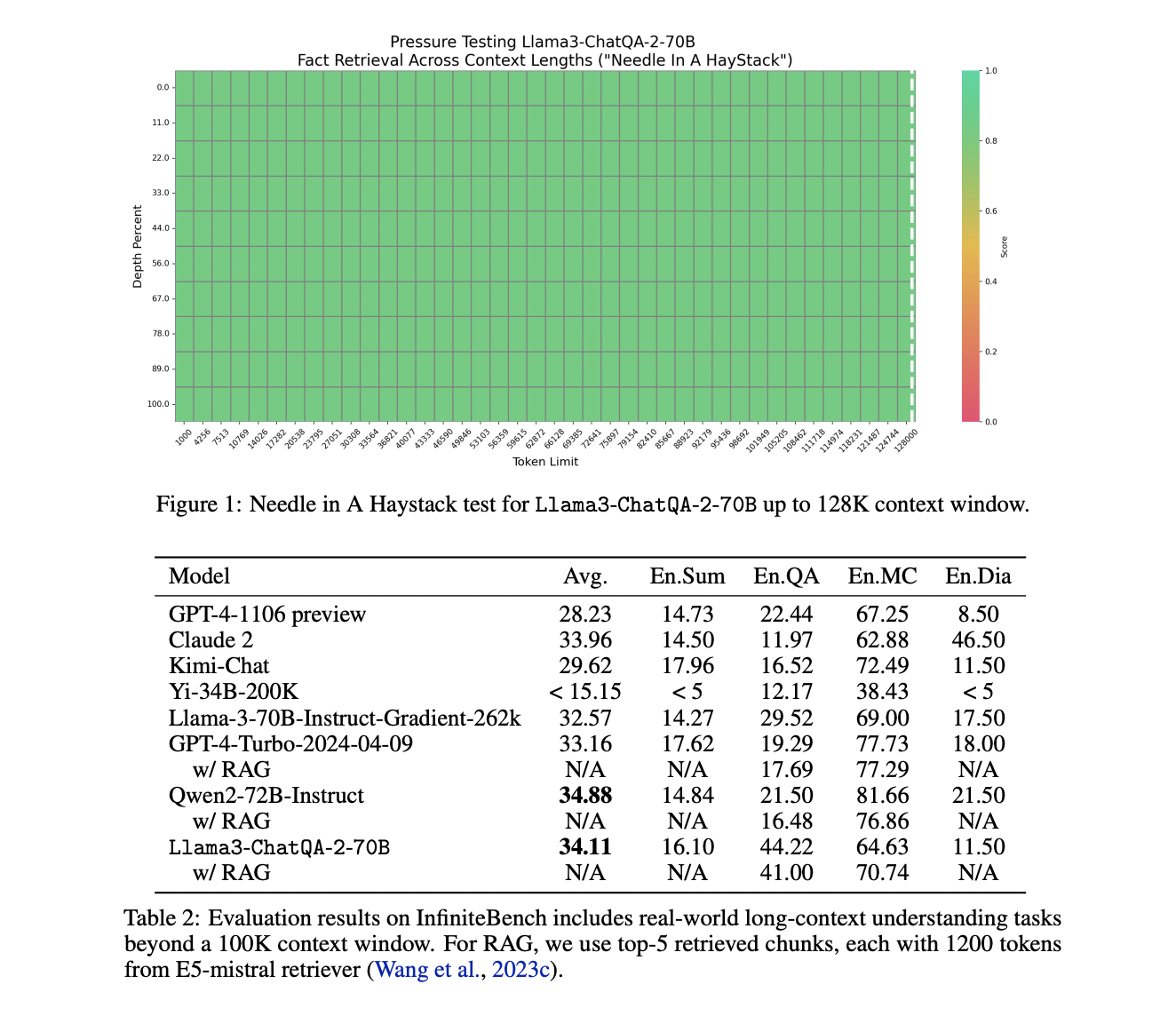

- Расширение окна контекста до 128K токенов

- Усовершенствование производительности RAG и понимания длинного контекста

- Аккуратность и эффективность в обработке текстов различной длины и функций

Конкретные применения модели ChatQA 2:

- Сжатие документов

- Ответы на вопросы в разговорном формате

- Поиск информации

Данная модель можно применять для решения задач обработки текстов различной длины, обеспечивая точность и эффективность при выполнении сложных задач.

Использование технологии ChatQA 2:

- Непрерывный этап предварительного обучения на разнообразных наборах данных

- Трехэтапный процесс настройки инструкций для улучшения производительности

- Сравнение показателей с моделями, разработанными другими компаниями

Поддержка ИИ-сообщества:

- Следите за нашими обновлениями в Twitter

- Присоединяйтесь к нашему Telegram-каналу

- Присоединяйтесь к нашей группе в LinkedIn

Если вас интересует будущее использования искусственного интеллекта, ознакомьтесь с информацией о нашей модели ChatQA 2. Присоединяйтесь к обсуждениям и делитесь своим мнением в нашем Telegram-канале.

«`