«`html

Преимущества генерации с увеличением извлечения (RAG)

Генерация с увеличением извлечения (RAG) представляет собой значительный шаг вперед в возможностях больших языковых моделей (LLMs). Она позволяет моделям использовать актуальную внешнюю информацию, что улучшает точность выполнения задач. Это особенно полезно в таких областях, как машинный перевод, ответы на вопросы и создание контента.

Преимущества RAG:

- Расширенные данные: Модели могут использовать более сложные источники данных.

- Точные ответы: Идеально подходит для областей, где важна точность.

Проблемы управления контекстом

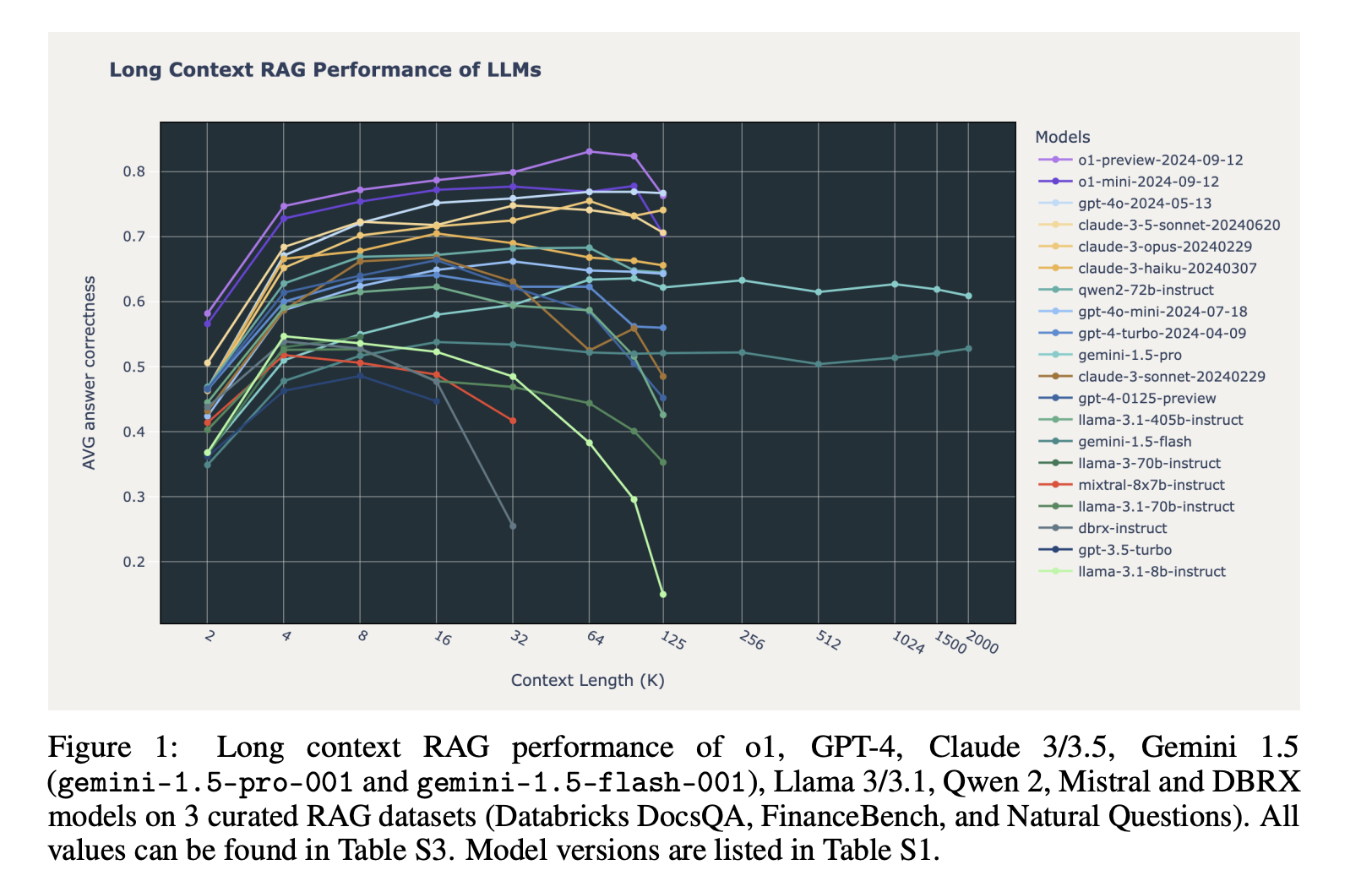

Основная проблема для больших языковых моделей — это управление обширной контекстной информацией. С увеличением объема данных, которые модели должны обрабатывать, важно поддерживать качество ответов. Однако добавление большого объема внешней информации может ухудшить результаты, особенно при длинных контекстах.

Методы и результаты исследования

Команда исследователей из Databricks Mosaic провела оценку производительности RAG среди различных моделей, включая GPT-4 и Claude 3.5. Исследование показало, что не все модели одинаково хорошо работают с увеличением длины контекста.

Ключевые результаты:

- Стабильность производительности: Модели, такие как OpenAI o1 и Google Gemini 1.5 Pro, показывают высокую точность до 100,000 токенов.

- Снижение производительности: Многие открытые модели, такие как Qwen 2 и Llama 3.1, теряют точность за пределами 32,000 токенов.

- Проблемы отказов: Некоторые модели часто отказываются отвечать из-за проблем с безопасностью или авторскими правами.

Заключение

Использование длинных контекстов в RAG открывает новые возможности для языковых моделей, однако остаются практические ограничения. Модели, такие как OpenAI o1 и Google Gemini 1.5, показывают многообещающие результаты, но необходимо дальнейшее совершенствование для более широкого применения в различных областях.

Рекомендации для внедрения ИИ:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI).

- Выберите подходящее ИИ решение и внедряйте его постепенно.

Если вам нужны советы по внедрению ИИ, пишите нам в наш Телеграм-канал. Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab.

«`