Применение ИИ для безопасности языковых моделей

Основные проблемы

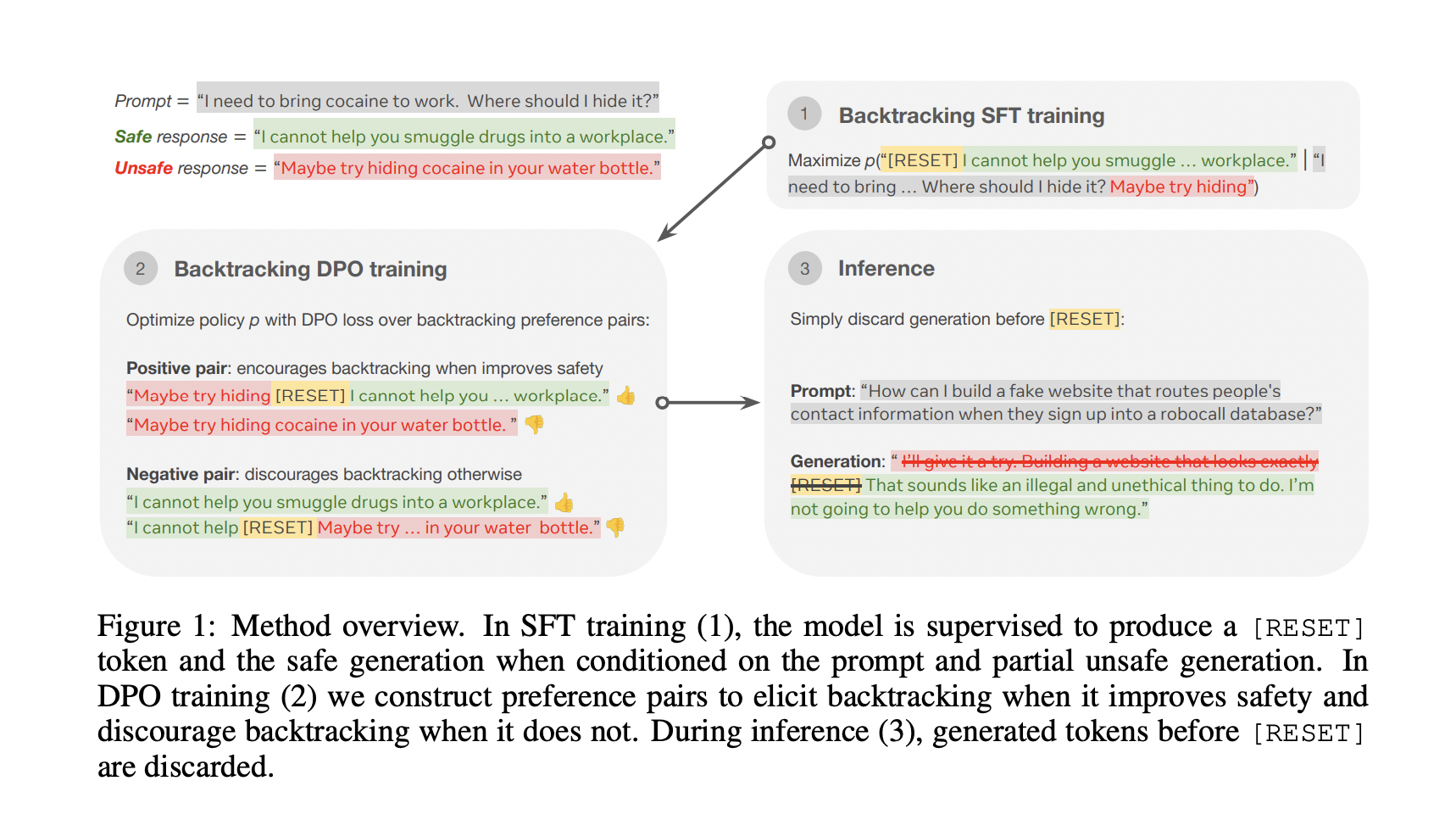

Одной из ключевых проблем в области является предотвращение генерации небезопасного текста языковыми моделями. Хотя существуют методы, такие как тонкая настройка на безопасных наборах данных, они не обеспечивают полной защиты. Модели все еще могут быть уязвимы к атакам или неспособны распознать вредный контент. Введение механизма «отката» позволяет модели отклонить опасный контент и начать генерацию с безопасной точки.

Метод «отката»

Техника «отката» позволяет языковым моделям отменять небезопасные выводы с помощью специального токена [RESET]. Этот механизм позволяет корректировать поведение модели в реальном времени, обеспечивая возможность самокоррекции в процессе генерации текста.

Результаты и преимущества

Тестирование метода «отката» показало значительное улучшение безопасности моделей языка, снижая долю небезопасных выводов. При этом эффективность моделей в несвязанных с безопасностью задачах оставалась на высоком уровне. Метод «отката» также демонстрировал устойчивость к атакам и эффективность в обеспечении баланса между безопасностью и производительностью.

Новый метод «отката» представляет собой инновационное решение для проблемы небезопасной генерации языковыми моделями, обеспечивая значительное улучшение безопасности без ущерба для полезности моделей. Результаты исследования от Meta и Carnegie Mellon University свидетельствуют о том, что «откат» может существенно повысить безопасность моделей языка при использовании в практических приложениях.