«`html

Новая активационная функция TeLU для глубокого обучения

Исследователи из Университета Южной Флориды разработали новую активационную функцию TeLU(x) = x · tanh(ex), которая улучшает обучение нейронных сетей. Эта функция сочетает в себе эффективность ReLU и стабильность гладких функций.

Проблемы существующих функций активации

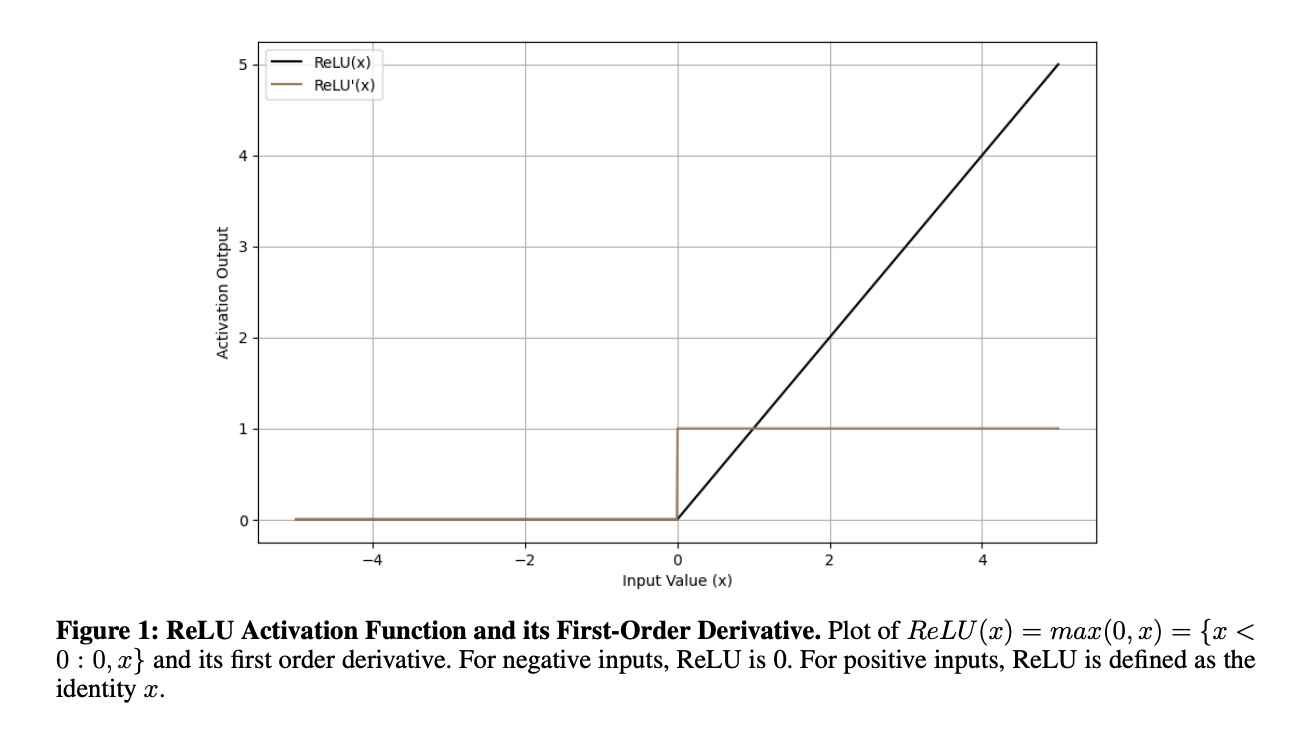

Многие активационные функции, такие как ReLU, tanh, и другие, сталкиваются с проблемами:

- Исчезновение градиентов, что замедляет обучение в глубоких сетях.

- «Мертвые нейроны», когда определенные участки сети перестают обучаться.

- Низкая эффективность и нестабильная производительность современных альтернатив.

Преимущества TeLU

TeLU предлагает:

- Постепенные переходы в выходных данных.

- Устойчивую динамику градиентов.

- Улучшенную сходимость и стабильность в различных задачах.

Проверка эффективности TeLU

Тестирование показало, что TeLU:

- Предотвращает проблему исчезновения градиентов.

- Заметно ускоряет сходимость и улучшает точность по сравнению с традиционными функциями.

- Эффективно работает с конфигурациями на основе ReLU.

Как использовать ИИ для вашей компании

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Анализируйте влияние ИИ: определите, где можно внедрить автоматизацию.

- Установите KPI: выберите ключевые показатели, которые хотите улучшить.

- Выберите подходящее решение: много вариантов ИИ на рынке.

- Постепенное внедрение: начните с небольшого проекта, анализируйте результаты.

Получите консультацию по внедрению ИИ

Если вам нужны советы, пишите нам!

Следите за новостями о ИИ в нашем Телеграм-канале и Twitter.

Проверьте AI Sales Bot

Узнайте, как AI может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

«`