«`html

Проблемы больших языковых моделей (LLMs)

Большие языковые модели требуют много вычислительных и памятьных ресурсов для обработки длинных последовательностей, что приводит к медленной работе и высоким затратам на оборудование. Механизм внимания, ключевой компонент, усугубляет эти проблемы из-за своей квадратичной сложности. Также использование кэша ключ-значение (KV) создает высокие затраты на память, что ограничивает масштабируемость.

Основные ограничения LLMs

- Невозможность обрабатывать последовательности длиннее обученного контекстного окна.

- Снижение производительности при работе с длинными входами из-за неэффективного управления памятью.

- Существующие решения требуют тонкой настройки и качественных наборов данных для длинного контекста.

Решение InfiniteHiP

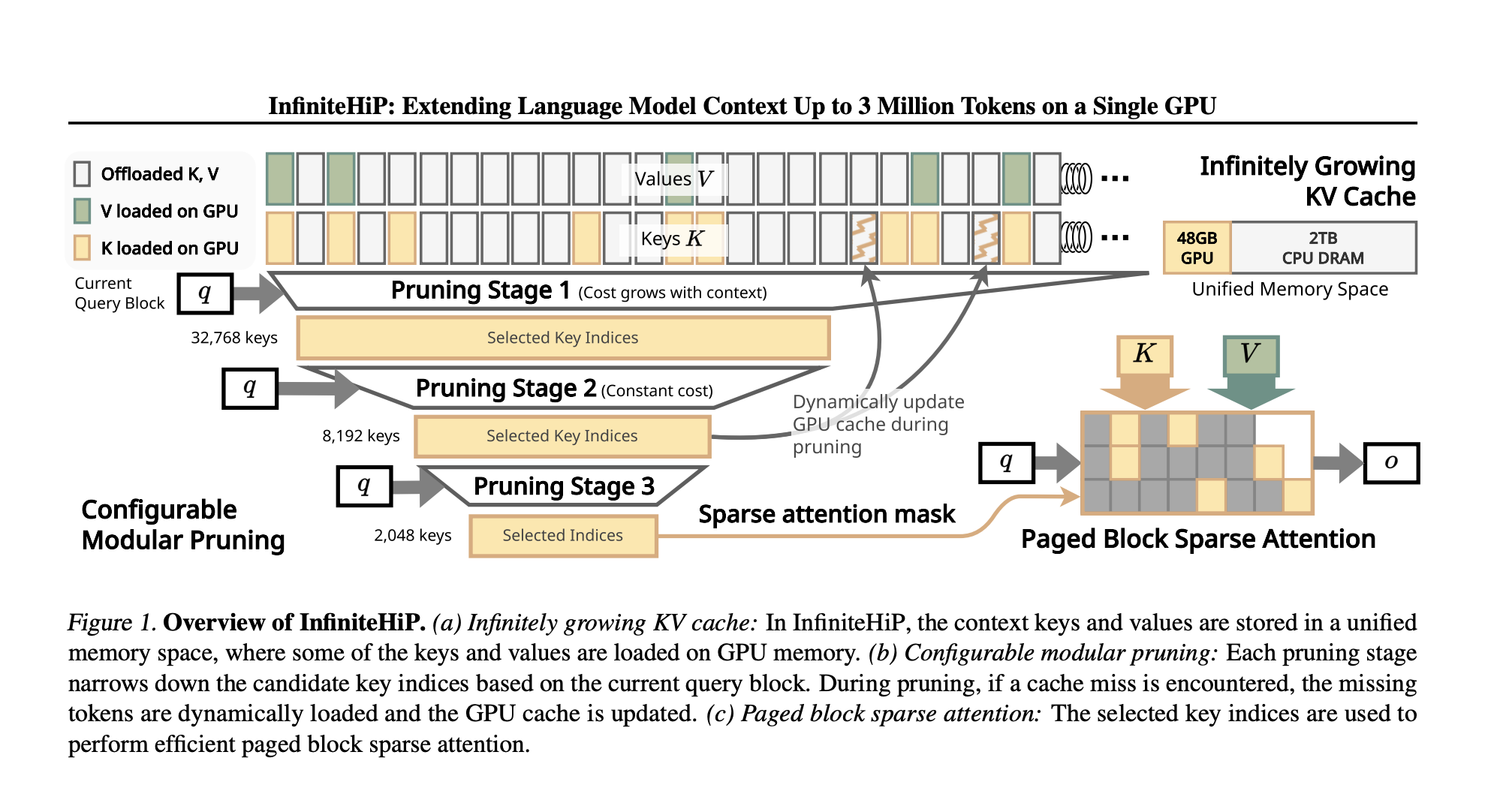

Исследователи из KAIST и DeepAuto.ai представили InfiniteHiP — продвинутую платформу, которая обеспечивает эффективную работу с длинным контекстом и снижает проблемы с памятью.

Как работает InfiniteHiP?

- Использует алгоритм динамической обрезки токенов, который удаляет менее релевантные токены.

- Поддерживает адаптивные изменения RoPE (Позиционные Встраивания), что позволяет моделям обрабатывать более длинные последовательности без дополнительного обучения.

- Применяет новый механизм выгрузки кэша KV, перемещая редко используемые токены в основную память, сохраняя при этом эффективный доступ к ним.

Преимущества InfiniteHiP

- Модель обрабатывает до 3 миллионов токенов на GPU с 48 ГБ памяти.

- Увеличение скорости обработки внимания в 18.95 раз для контекста в один миллион токенов.

- Снижение потребления памяти GPU до 96%, что делает решение практичным для крупных приложений.

Заключение

InfiniteHiP решает основные проблемы длинного контекста, улучшая возможности LLM. Эта платформа позволяет моделям обрабатывать длинные последовательности без потери контекста или увеличения вычислительных затрат. Решение масштабируемое и эффективно использует оборудование, что делает его применимым для различных AI-приложений.

Как внедрить ИИ в вашу компанию?

- Анализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые вы хотите улучшить.

- Выберите подходящее решение из множества доступных ИИ.

- Внедряйте ИИ постепенно: начните с малого проекта и анализируйте результаты.

Если вам нужны советы по внедрению ИИ, пишите нам в Telegram. Следите за новостями о ИИ в нашем Telegram-канале или в Twitter.

Попробуйте AI Sales Bot, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж. Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab.

«`