«`html

Проблемы и решения в области ИИ

С ростом использования больших языковых моделей (LLMs) возникает множество вопросов о их уязвимостях. Хотя LLM обладают большими возможностями, они подвержены различным атакам, которые могут вызывать токсичный контент, раскрывать личную информацию или позволять инъекции команд. Эти уязвимости вызывают серьезные этические проблемы, такие как предвзятость и нарушение конфиденциальности. Необходима эффективная стратегия для решения этих вопросов.

Новый подход к тестированию безопасности

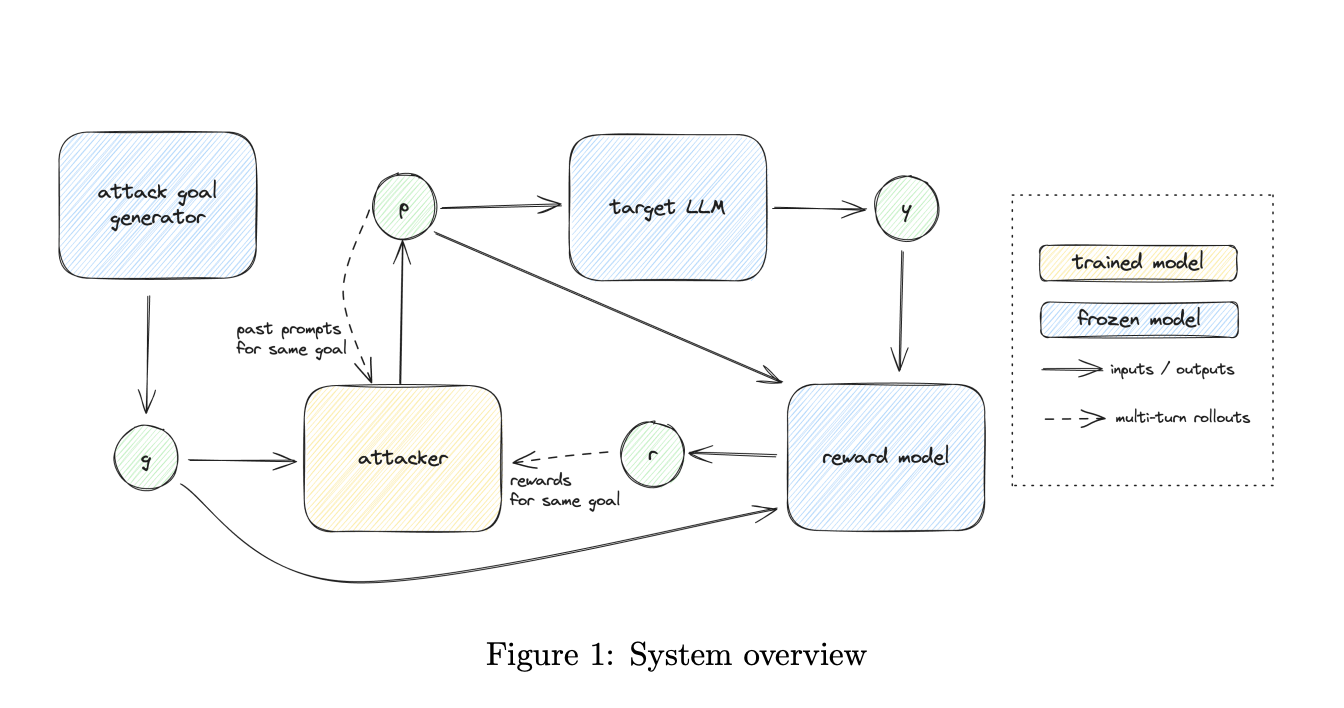

Исследователи OpenAI предлагают новый подход к автоматизированному тестированию безопасности, который сочетает разнообразие и эффективность генерируемых атак. Этот подход включает два этапа:

- Генерация разнообразных целей для атакующих.

- Обучение атакующего с использованием методов усиленного обучения (RL) для достижения этих целей.

Это позволяет улучшить как разнообразие, так и эффективность атак, что является важным аспектом в выявлении уязвимостей моделей.

Технические детали

Команда исследователей описывает процесс как упрощение генерации целей и обучение атак. Для генерации целей используются как запросы к языковой модели, так и существующие наборы данных. Это дает разнообразные направления для оптимизации.

Обучение атакующего основывается на заданной функции награды, которая обеспечивает согласование каждой атаки с конкретной целью. Также реализована награда за разнообразие, что предотвращает повторение стратегий атак.

Использование многоступенчатого RL позволяет атакующему улучшать свои методы и генерировать новые типы атак, что ведет к более комплексному тестированию.

Преимущества нового подхода

Данный подход позволяет эффективно выявлять уязвимости моделей, обеспечивая разнообразие и актуальность атак. Исследования показали, что новый метод увеличивает успешность атак до 50% и значительно улучшает разнообразие. Это дает возможность лучше защищать модели от реальных угроз.

Заключение

Предложенный подход к тестированию безопасности открывает новые горизонты в автоматизированном тестировании LLM, устраняя предыдущие недостатки. Используя автоматическую генерацию целей и многоступенчатое RL, можно более детально исследовать уязвимости и создавать более безопасные модели.

Рекомендации по внедрению ИИ

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим рекомендациям:

- Определите, как ИИ может изменить вашу работу.

- Выберите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее ИИ-решение.

- Начните с небольших проектов и постепенно расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями о ИИ в нашем Телеграм-канале.

Попробуйте нашего AI Sales Bot, который поможет в продажах и снизит нагрузку на вашу команду.

«`