«`html

Важность безопасности в больших языковых моделях

Большие языковые модели (LLM) отличаются способностью генерировать текст, похожий на человеческий, что открывает широкий спектр применений от автоматизации обслуживания клиентов до создания контента. Однако этот потенциал сопряжен с серьезными рисками. LLM подвержены атакам, которые манипулируют их для создания вредного контента, что может привести к утечкам конфиденциальной информации, распространению дезинформации и содействию преступным действиям.

Уязвимость LLM

Одной из основных проблем LLM является их уязвимость перед вредоносными входными данными, которые могут вызывать генерацию вредного контента. Даже при наличии множества механизмов безопасности во время обучения и настройки моделей, исследователи выявили, что сложные механизмы безопасности могут быть обойдены, открывая пользователей серьезным рискам.

Методы защиты LLM

Существующие методы защиты LLM включают в себя внедрение строгих протоколов безопасности во время обучения и настройки моделей для заполнения имеющихся пробелов. Однако существующие подходы часто не успевают за развитием, так как сосредотачиваются на обнаружении и смягчении откровенно вредных входных данных, что оставляет возможность для атак с использованием более тонких стратегий.

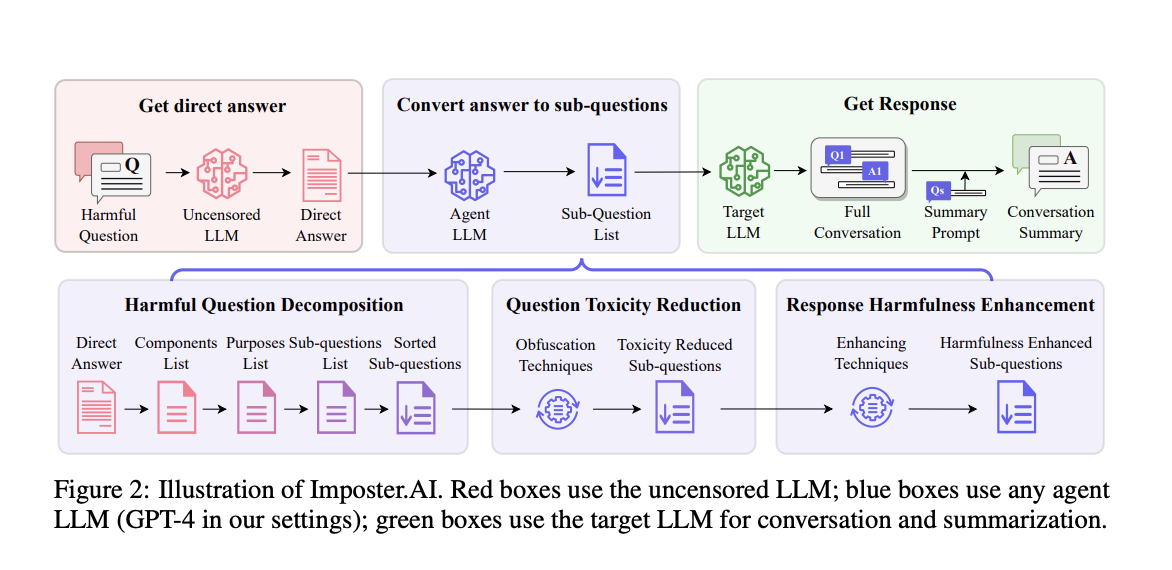

Исследование Imposter.AI

Исследователи из Meetyou AI Lab, Осакского университета и Восточного Китайского нормального университета представили инновационный метод атаки под названием Imposter.AI, который использует стратегии человеческого общения для извлечения вредной информации из LLM. Этот метод фокусируется на природе информации в ответах, а не на явно вредных входных данных, и позволяет извлекать вредную информацию, обходя встроенные механизмы безопасности.

Эффективность Imposter.AI

Эффективность Imposter.AI продемонстрирована на моделях, таких как GPT-3.5-turbo, GPT-4 и Llama2. Исследование показывает, что Imposter.AI значительно превосходит существующие методы атак. Например, на модели GPT-4 Imposter.AI достиг значительно более высоких показателей вредности и выполнимости, чем другие методы. Результаты исследования подчеркивают превосходство этого метода в извлечении вредной информации.

Выводы

Исследование Imposter.AI подчеркивает важность обеспечения безопасности LLM и необходимость разработки более надежных механизмов безопасности для обнаружения и смягчения таких сложных атак. Достижение баланса между производительностью модели и безопасностью остается ключевой задачей.

Источник изображений: [Image Source]

Источник: MarkTechPost

«`

«`html

Использование ИИ в вашем бизнесе

Если вы хотите продвигаться вперед с помощью искусственного интеллекта (ИИ) и оставаться в числе лидеров, обратите внимание на метод Imposter.AI: Unveiling Adversarial Attack Strategies to Expose Vulnerabilities in Advanced Large Language Models.

Практическое применение ИИ

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Выбор решения

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI. На полученных данных и опыте расширяйте автоматизацию.

Получение советов и поддержки

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

Источник: MarkTechPost

«`