Исследование: Динамические механизмы памяти в языковых моделях на основе трансформеров

Практические решения и ценность

Языковые модели на основе трансформеров обладают удивительными языковыми способностями, вызывая вопросы о механизмах памяти. В отличие от людей, использующих память для повседневных задач, «память» LLM основана на входных данных, а не хранится внешне. Исследования направлены на улучшение способности LLM к сохранению информации путем расширения контекста и внедрения внешних систем памяти. Однако эти методы не полностью разъясняют, как работает память в этих моделях. Время от времени LLM предоставляет устаревшую информацию, что указывает на форму памяти, хотя ее точная природа неясна. Понимание различий между памятью LLM и памятью человека необходимо для развития исследований в области ИИ и его применений.

Исследователи Гонконгского политехнического университета используют Универсальную Теорему Приближения (UAT) для объяснения памяти в LLM. Они предполагают, что память LLM, названная «памятью Шрёдингера», наблюдается только при запросе, поскольку ее наличие остается неопределенным в противном случае. Используя UAT, они утверждают, что LLM динамически приближает прошлую информацию на основе входных сигналов, напоминая память. Их исследование представляет новый метод оценки способностей памяти LLM и сравнивает память и рассуждения LLM с человеческими, выделяя как сходства, так и различия. Исследование также предоставляет теоретические и экспериментальные доказательства, подтверждающие способности памяти LLM.

UAT является основой глубокого обучения и объясняет память в LLM на основе трансформеров. UAT показывает, что нейронные сети могут приближать любую непрерывную функцию. В моделях трансформеров этот принцип применяется динамически на основе входных данных. Слои трансформера настраивают свои параметры при обработке информации, позволяя модели подгонять функции в ответ на разные входы. В частности, механизм внимания с несколькими головами модифицирует параметры для эффективной обработки и сохранения информации. Это динамическое настройка позволяет LLM проявлять способности, сходные с памятью, позволяя им вызывать в памяти и использовать прошлые детали при ответе на запросы.

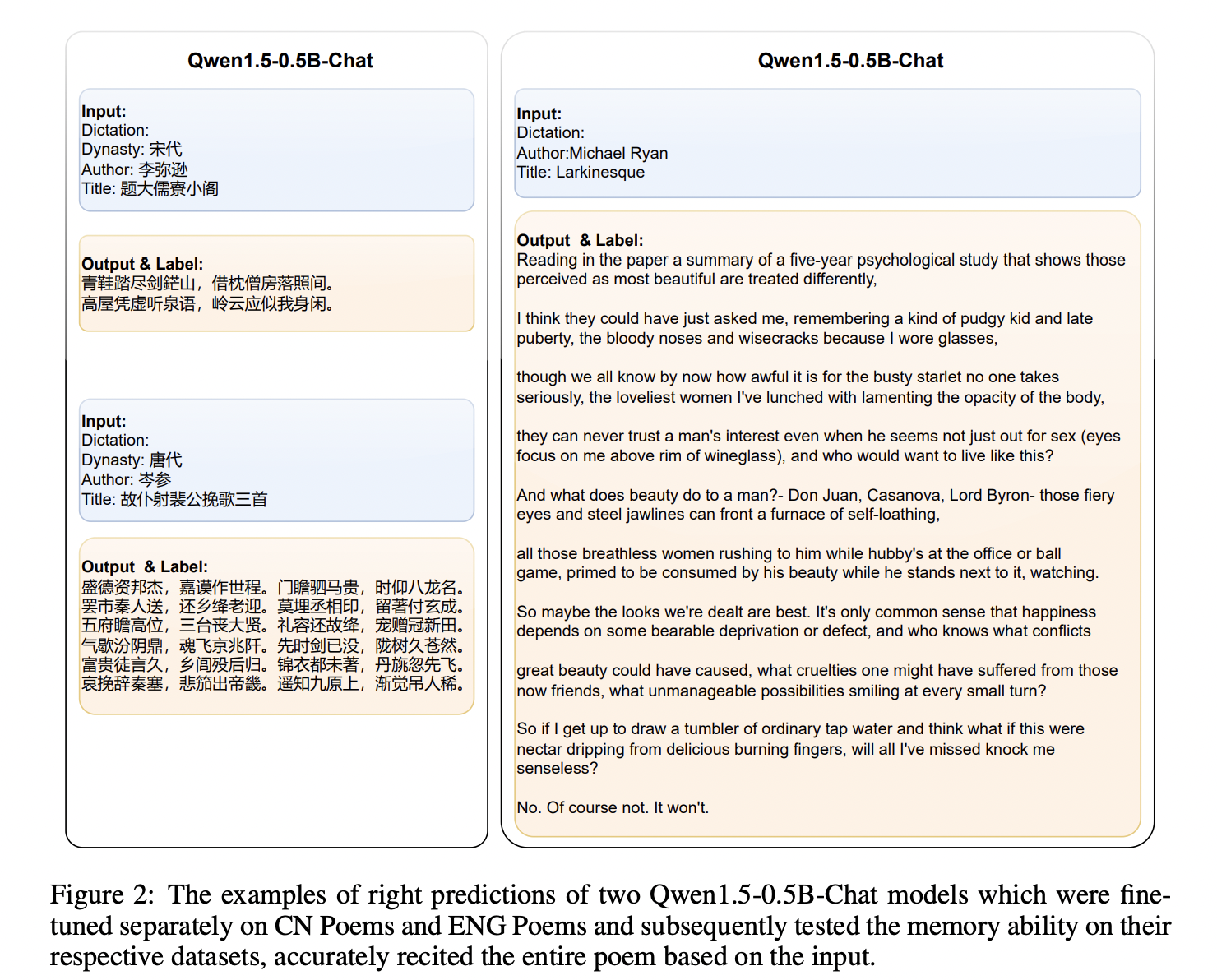

Исследование исследует способности памяти LLM. Во-первых, оно определяет память как требующую как входа, так и выхода: память вызывается входом, а выход может быть правильным, неправильным или забытым. LLM проявляет память, подгоняя вход к соответствующему выходу, подобно воспоминаниям человека. Эксперименты с использованием наборов данных китайских и английских стихов проверяли способность моделей рецитировать стихи на основе минимального входа. Результаты показали, что более крупные модели с лучшим пониманием языка проявили значительно лучшие результаты. Кроме того, более длинный входной текст снижал точность памяти, указывая на корреляцию между длиной входа и производительностью памяти.

Исследование утверждает, что LLM обладают способностями к памяти и рассуждениям, сходными с когнитивными способностями человека. Как и люди, LLM динамически генерируют выходы на основе изученных знаний, а не хранят фиксированную информацию. Исследователи предполагают, что мозг человека и LLM функционируют как динамические модели, которые приспосабливаются к входам, способствуя креативности и адаптивности. Ограничения в рассуждениях LLM связаны с размером модели, качеством данных и архитектурой. Динамический механизм подгонки мозга, проиллюстрированный случаями, например, Генри Молейзона, позволяет непрерывному обучению, креативности и инновациям, параллельно с потенциалом LLM для сложного рассуждения.

В заключение, исследование демонстрирует, что LLM, поддерживаемые своей архитектурой на основе трансформеров, обладают способностями памяти, сходными с когнитивными способностями человека. Память LLM, названная «памятью Шрёдингера», раскрывается только при определенных входах, отражая UAT в своей динамической адаптивности. Исследование подтверждает память LLM через эксперименты и сравнивает ее с функционированием мозга человека, находя параллели в их динамических механизмах ответа. Исследование предполагает, что память LLM работает, как память человека, проявляясь только через конкретные запросы, и исследует сходства и различия между когнитивными процессами человека и LLM.

Применение ИИ в вашем бизнесе

Как использовать ИИ для развития вашей компании

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Unveiling Schrödinger’s Memory: Dynamic Memory Mechanisms in Transformer-Based Language Models.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!