«`html

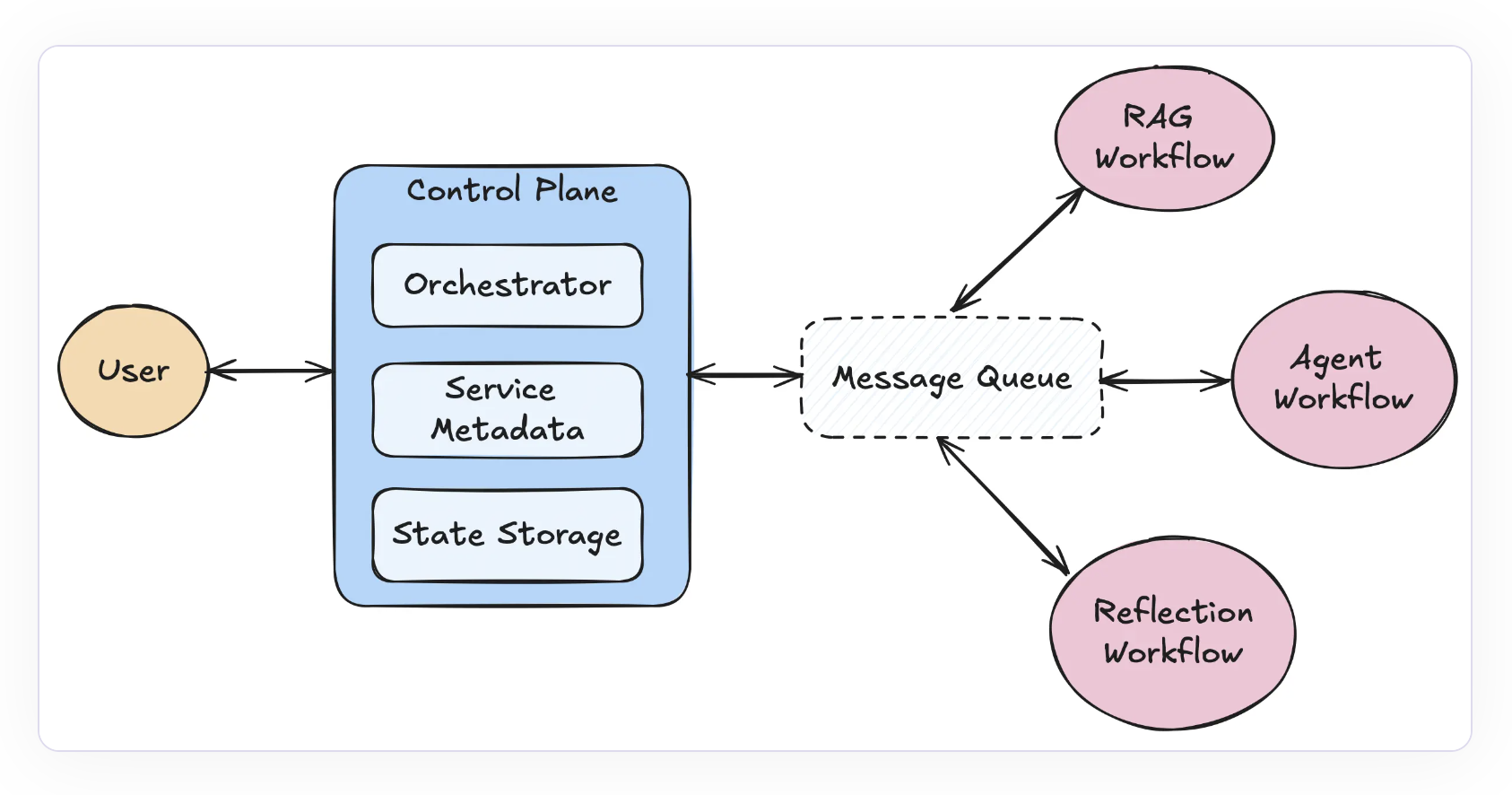

Архитектура

Сообщения

Ключевой компонент, позволяющий системе контролировать обработку задач, назначать задачи различным службам и публиковать методы в именованные очереди.

Контрольная плоскость

Является мозгом системы llama-deploy. Отслеживает службы и задачи, управляет сеансами и состояниями, назначает задачи с помощью оркестратора. Отвечает за регистрацию служб, облегчая масштабируемость и управление многослужбовыми системами.

Оркестратор

Управляет потоком результатов и определяет, какая служба должна выполнить данную задачу. Позволяет обрабатывать ошибки и повторы, предполагая, что входящие задачи имеют указанное место назначения по умолчанию.

Службы рабочего процесса

Основные компоненты, где действительно выполняется работа. Каждая служба обрабатывает входящую работу и выдает результаты. При развертывании рабочего процесса он становится службой, выполняющей задачи непрерывно.

Основные особенности llama-deploy

Простое развертывание

Возможность развертывания рабочих процессов с минимальными или без изменений кода — одно из его главных преимуществ. Разработчики могут легче переходить от создания агентов в локальных средах к развертыванию их в масштабируемой инфраструктуре.

Масштабируемость

Микросервисная архитектура llama-deploy упрощает масштабирование отдельных компонентов в ответ на спрос. Это обеспечивает гибкую масштабируемость, независимо от того, нужно ли добавлять новые службы или улучшать возможности обработки сообщений.

Устойчивость к сбоям

Llama-deploy разработан для обеспечения надежности в производственных средах с интегрированными методами обработки ошибок и повторов. Благодаря этим свойствам система надежна для важных приложений и остается устойчивой даже в случае сбоев.

Гибкость

Разработчики могут добавлять новые службы или изменять компоненты системы, такие как очереди сообщений, без вызова системных нарушений с помощью архитектуры «центр и спица». Эта гибкость упрощает настройку в соответствии с конкретными требованиями приложения.

Асинхронность

Llama-deploy оптимизирован для высококонкурентных ситуаций и позволяет выполнять асинхронные операции, что делает его идеальным для приложений с высокой пропускной способностью и реального времени.

Начать работу с llama-deploy очень просто. Его можно установить с помощью Pip, и он легко взаимодействует с уже существующей производственной инфраструктурой. Llama-deploy можно использовать как с RabbitMQ, так и с Kubernetes (k8s). Благодаря активному сообществу и открытому проекту, llama-deploy хорошо позиционирован для установления стандарта инструмента развертывания агентных рабочих процессов.

В заключение, llama-deploy объединяет пользовательские интерфейсы агентных рабочих процессов и упрощает процесс развертывания, обеспечивая плавный переход для всех, кто следил за развитием llama-agents. Разработчики могут создавать рабочие процессы в LlamaIndex и плавно масштабировать их в производственных средах с помощью llama-deploy.

Подробности можно узнать у исследователей этого проекта. Также не забудьте подписаться на наш Twitter и LinkedIn. Присоединяйтесь к нашему Telegram-каналу.

Если вам понравилась наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему SubReddit.

Статья Llama-Deploy: A Fully Open-Source Way to Deploy Your Agents as Production Microservices была опубликована на MarkTechPost.

«`