«`html

Quantized Eigenvector Matrices for 4-bit Second-Order Optimization of Deep Neural Networks

Глубокие нейронные сети (DNN) достигли значительных успехов в различных областях, включая компьютерное зрение, обработку естественного языка и распознавание речи. Однако эффективное обучение крупномасштабных моделей сталкивается с проблемами. В этом помогают вторичные оптимизаторы, такие как K-FAC, Shampoo, AdaBK и Sophia, которые демонстрируют превосходство в сходимости, но часто вызывают значительные вычислительные и памятные затраты.

Практические решения и ценность:

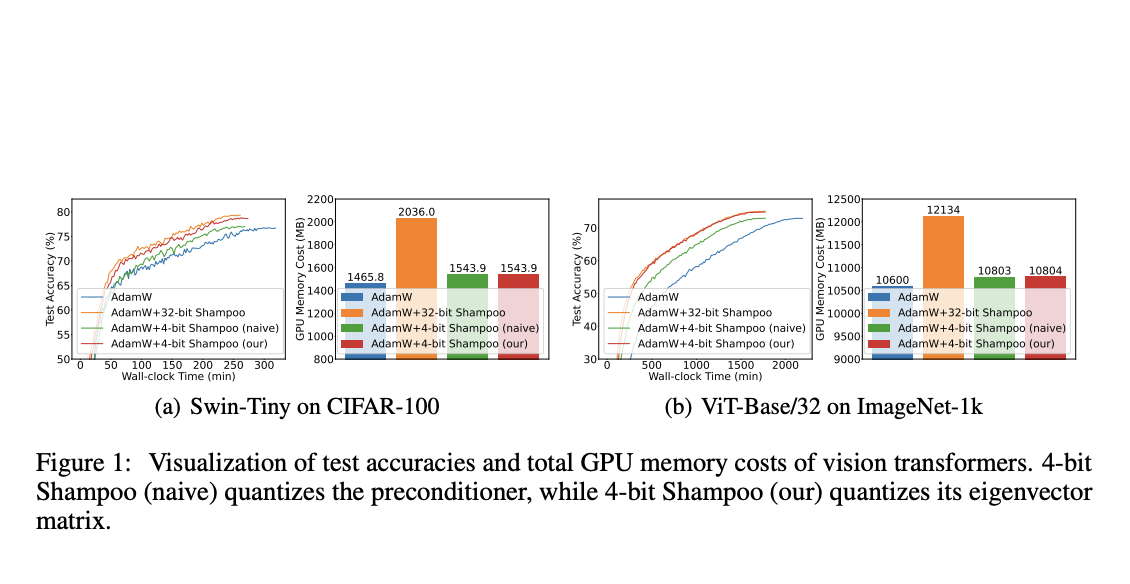

Для снижения потребления памяти состояний оптимизатора применяются факторизация и квантование. Факторизация использует низкоранговую аппроксимацию для представления состояний оптимизатора, а квантование использует низкобитовые представления для сжатия 32-битных состояний оптимизатора. Эти техники позволяют обеспечить сопоставимую производительность 4-битного Shampoo по сравнению с его 32-битным аналогом, при этом достигая значительной экономии памяти.

Результаты исследования показывают превосходство 4-битного Shampoo над оптимизаторами первого порядка, такими как AdamW. При этом 4-битный Shampoo достигает сопоставимой точности тестирования с 32-битным Shampoo и предоставляет существенную экономию памяти. Работа открывает новые возможности для широкого использования эффективных оптимизаторов в обучении крупномасштабных DNN.

Больше информации о доступных решениях ИИ и новостях в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

«`

Please note that the HTML output may not be displayed correctly in this environment, but you can copy and paste it into an HTML file to see the formatting.