«`html

Оптимизация и ускорение техник для крупных языковых моделей (LLM)

Проблемы и решения в области обучения и использования LLM

Крупные языковые модели (LLM) сталкиваются с огромными вызовами в области вычислительных ресурсов и использования памяти. Разработка фреймворков, библиотек и техник для преодоления этих проблем становится необходимой. Недавние исследования выявили методы, позволяющие достичь сопоставимой точности с снижением затрат на обучение, такие как оптимизированные алгоритмы, распределенные архитектуры и аппаратное ускорение.

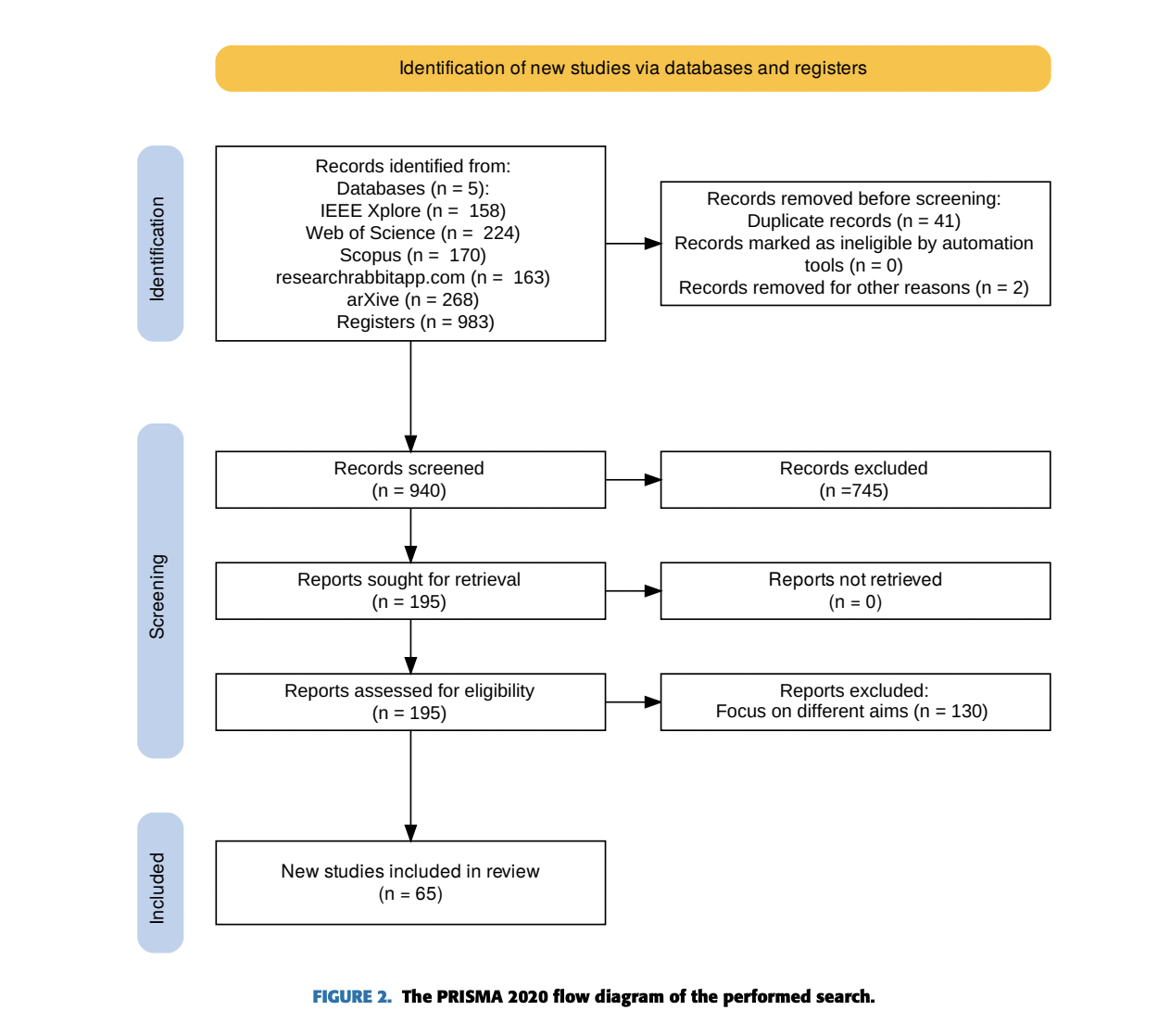

Исследователи из Университета Обуда (Венгрия), Университета им. Й. Селя (Словакия) и Института информатики и управления (SZTAKI) Венгерской научной сети (HUN-REN) представили систематический обзор литературы, анализирующий 65 публикаций с 2017 по декабрь 2023 года. Они выделили три класса для улучшения LLM: обучение, вывод и обслуживание системы. Исследователи также представили два кейс-исследования, демонстрирующих практические подходы к оптимизации обучения моделей и улучшению эффективности вывода.

Для преодоления этих вызовов были разработаны различные техники оптимизации LLM, такие как алгоритмические, разделение модели, тонкая настройка для эффективности и оптимизация планировщика.

Хотите узнать больше о том, как использовать искусственный интеллект для развития вашего бизнеса? Присоединяйтесь к нашему Telegram-каналу t.me/itinainews или нашему Twitter @itinairu45358.

«`