«`html

Прогрессивная система обучения для улучшения рассуждений искусственного интеллекта через слабое крепкое руководство

Поскольку большие языковые модели превосходят возможности человека, обеспечение точного руководства становится все более сложным. Метод слабого-к-сильному обучению, который использует менее способную модель для улучшения более сильной, предлагает потенциальные преимущества, но требует тестирования для сложных задач рассуждения. Этот метод в настоящее время не обладает эффективными техниками для предотвращения имитации более сильной моделью ошибок менее сильной модели. По мере продвижения искусственного интеллекта к искусственному общему интеллекту (ИОИ), создание сверхинтеллектуальных систем вносит значительные вызовы, особенно в области надзора и парадигм обучения. Традиционные методы, опирающиеся на человеческий надзор или продвинутое руководство модели, становятся недостаточными по мере того, как возможности искусственного интеллекта превышают возможности их наблюдателей.

Практические решения и ценность:

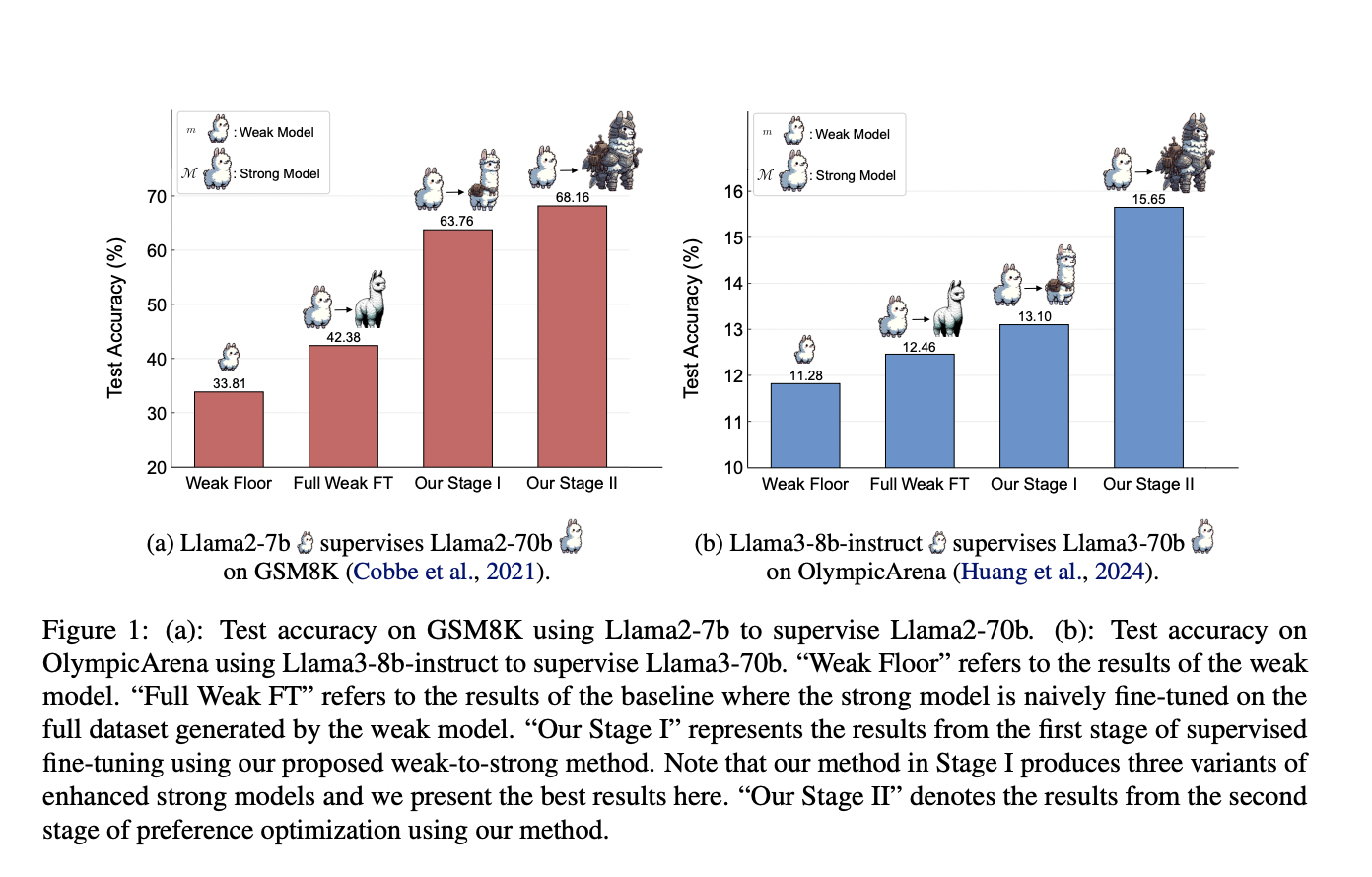

Исследователи из Университета Шанхайского Цзяотун, Университета Фудан, Шанхайской лаборатории искусственного интеллекта и GAIR разработали прогрессивную систему обучения, позволяющую сильным моделям автономно улучшать свои обучающие данные. Этот подход начинается с контролируемой тонкой настройки на небольшом качественном наборе данных, за которой следует оптимизация предпочтений с использованием контрастных образцов, выявленных сильной моделью. Эксперименты на наборах данных GSM8K и MATH показывают значительные улучшения в способностях рассуждения Llama2-70b при использовании трех различных слабых моделей. Эффективность системы демонстрируется далее с помощью Llama3-8b-instruct, наблюдающей за Llama3-70b на сложном наборе данных OlympicArena, открывая путь к улучшенным стратегиям рассуждения искусственного интеллекта.

Автоматизированное улучшение задач и соответствие инструкциям человека:

Большие языковые модели улучшают решение задач и соответствие инструкциям человека через контролируемую тонкую настройку (SFT), которая опирается на качественные обучающие данные для значительного улучшения производительности. Это исследование рассматривает потенциал обучения от слабого наблюдения. Соответствие больших языковых моделей человеческим ценностям также требует RLHF и непосредственной оптимизации предпочтений (DPO). DPO упрощает перепараметризацию функций вознаграждения в RLHF и имеет различные стабильные и производительные варианты, такие как ORPO и SimPO. В математическом рассуждении исследователи сосредотачиваются на методах подсказок и генерации высококачественных вопросно-ответных пар для тонкой настройки, что значительно улучшает способности решения проблем.

Цель слабого-к-сильному методу обучения:

Метод слабого-к-сильному обучению нацелен на максимизацию использования слабых данных и улучшение способностей сильной модели. На этапе I потенциально положительные образцы выявляются без истинных данных и используются для контролируемой тонкой настройки. Этап II включает использование полных слабых данных, сосредотачиваясь на потенциально негативных образцах через методы предпочтительного обучения, такие как DPO. Этот метод улучшает сильную модель, учась на ошибках слабой модели. Ответы сильной модели выбираются случайным образом, и уровни уверенности используются для определения надежных ответов. Создаются контрастные образцы для дальнейшего обучения, помогая сильной модели различать правильные и неправильные решения, что приводит к улучшению модели.

Результаты и применение:

Эксперименты используют наборы данных GSM8K и MATH, с поднаборами Dgold,1 и Dgold,2, используемыми для обучения слабых и сильных моделей. Начальное обучение на GSM8K было улучшено с использованием дополнительных данных, в то время как ограничения столкнулись с данными MATH из-за их сложности. Итерационная тонкая настройка улучшила слабые модели, что в свою очередь повысило производительность сильной модели. С использованием методов предпочтительного обучения, были замечены значительные улучшения, особенно на GSM8K. Дальнейший анализ показал лучшую обобщаемость на более простых задачах. Тесты с моделями Llama3 на наборе данных OlympicArena, более сложном наборе, продемонстрировали, что предложенный метод слабого-к-сильному обучению эффективен и масштабируем в реалистичных сценариях.

Заключение и приглашение к действию:

Данное исследование исследует эффективность прогрессивной системы обучения в сложных задачах рассуждения, представляя метод, который использует слабое руководство для развития сильных способностей без аннотаций человека или продвинутых моделей. Сильная модель улучшает свои обучающие данные автономно, даже без предварительного знания задачи, постепенно улучшая свои рассуждательные навыки через итеративное обучение. Эта самостоятельная куратирование данных необходима для улучшения способностей рассуждения искусственного интеллекта, что способствует независимости и эффективности модели. Исследование подчеркивает роль инновационного руководства моделью в развитии искусственного интеллекта, особенно для ИОИ. Ограничения включают использование текущих моделей в качестве прокси для будущих продвинутых моделей и вызовы, вызванные ошибками и шумом в надзоре на уровне процесса.

Проверьте статью и GitHub. Вся кредит за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему подразделению по машинному обучению с 47 тыс. участников

Найдите предстоящие вебинары по ИИ здесь

Статья опубликована на портале MarkTechPost.

«`