Применение метода MaskLLM для оптимизации работы с ИИ

Простой и эффективный способ сжатия моделей LLM

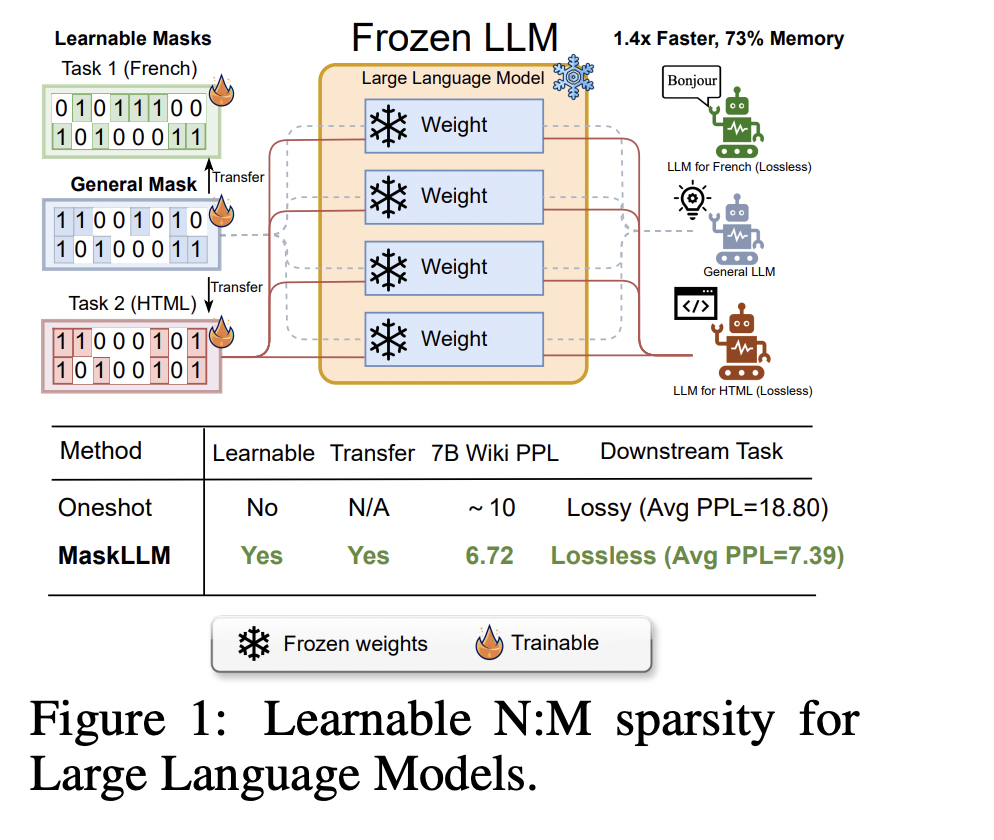

Метод MaskLLM предлагает использовать N: M разреженность для уменьшения вычислительных затрат во время вывода. Этот подход позволяет эффективно сократить размеры моделей, не ухудшая их производительность. Применение 2:4 разреженности обеспечивает оптимальное соотношение между нулевыми и ненулевыми значениями параметров.

Обучение масок для улучшения качества и эффективности

Метод MaskLLM использует обучаемый подход к созданию масок параметров, что позволяет улучшить точность и переносимость масок между различными задачами и областями. Эксперименты показали значительное улучшение производительности моделей LLaMA-2 и GPT-3, превзойдя другие методы сжатия, такие как SparseGPT.

Преимущества MaskLLM для вашей компании

Внедрение метода MaskLLM позволит вашей компании сократить вычислительные затраты при использовании ИИ, что способствует улучшению эффективности и результативности бизнес-процессов. Высокое качество обучения масок и возможность их настройки под конкретные задачи обеспечивают успешное применение в различных областях деятельности.