«`html

Графовые нейронные сети (GNN) в области обучения графов

Графовые нейронные сети (GNN) стали ведущим подходом для обучения графов в различных областях, включая рекомендательные системы, социальные сети и биоинформатику.

Уязвимость и защита от атак

Однако GNN показали уязвимость к атакам, особенно структурным атакам, изменяющим графовые рёбра. Это создаёт значительные вызовы, особенно в ситуациях, когда злоумышленники имеют ограниченный доступ к связям между сущностями.

Текущие подходы и их ограничения

Существующие подходы к защите от таких атак сталкиваются с проблемами масштабируемости из-за высокой вычислительной сложности и сложности гиперпараметров, что затрудняет развертывание моделей в реальных сценариях.

Новое решение: SFR-GNN

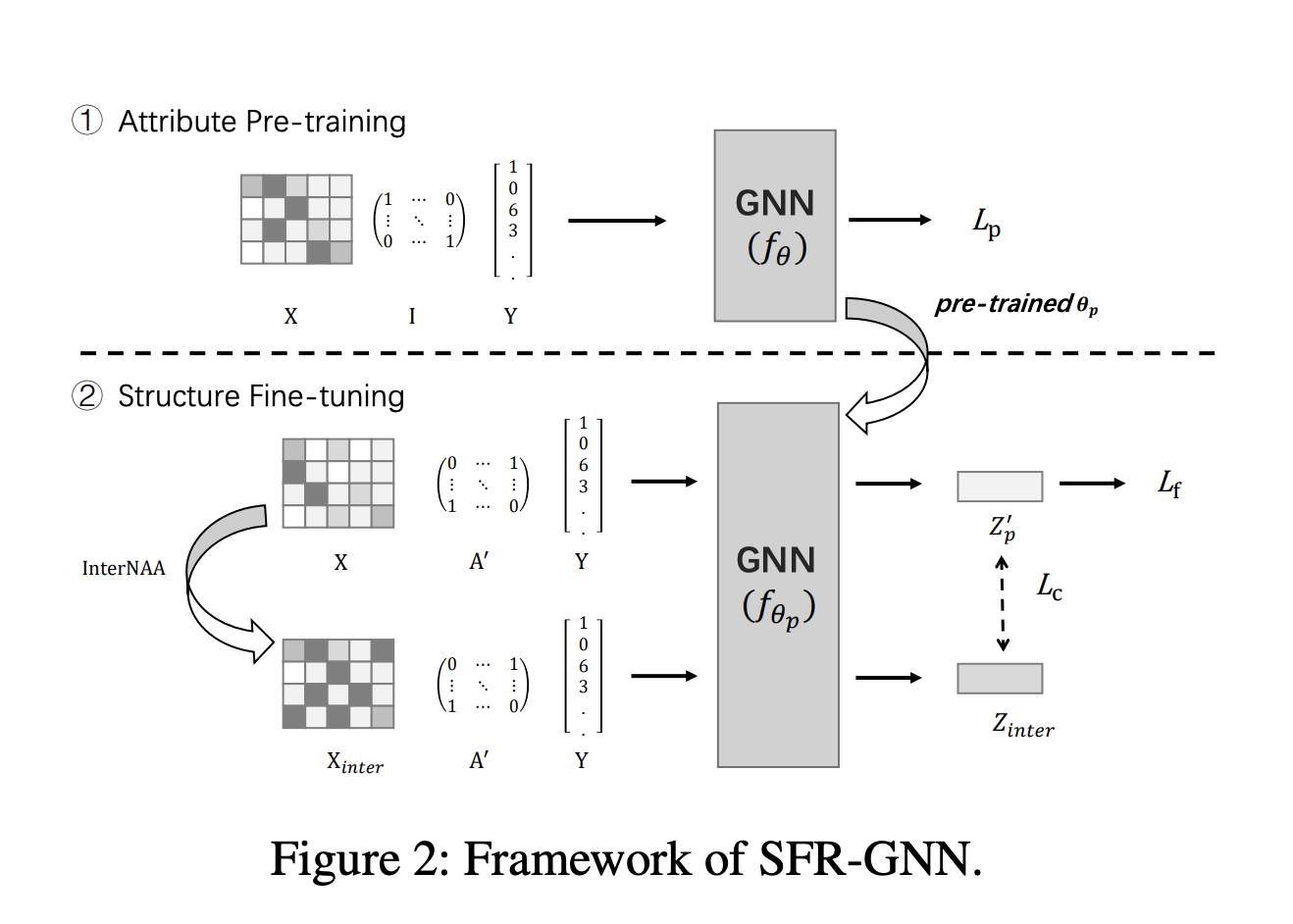

Исследователи из Гонконгского политехнического университета, Китайского университета Гонконга и Шанхайского университета Джиаотунг представляют SFR-GNN (Simple and Fast Robust Graph Neural Network) — уникальный подход для борьбы со структурными атаками в обучении графов. Метод предварительно обучается на атрибутах узлов, затем настраивается на структурной информации, обеспечивая устойчивость без дополнительных гиперпараметров или сложных механизмов.

Преимущества SFR-GNN

SFR-GNN продемонстрировал впечатляющую производительность в защите от структурных атак на графовых нейронных сетях, достигая робастности, сравнимой с передовыми базовыми значениями, и значительного улучшения скорости выполнения.

Данные результаты позиционируют SFR-GNN как перспективное достижение в области устойчивых графовых нейронных сетей, предлагая баланс производительности и практичности для различных графовых задач в условиях потенциальных структурных атак.

Подробнее ознакомьтесь с исследованием и следите за нами в Twitter и LinkedIn.

Присоединяйтесь к нашему Telegram-каналу и подпишитесь на нашу рассылку.

Не забудьте присоединиться к нашему SubReddit.

«`