SOAP: Эффективная оптимизация крупных моделей глубокого обучения

Описание и Практическое Применение

Оптимизация крупных моделей глубокого обучения остается значительной проблемой из-за высоких затрат на их обучение. Увеличение размеров моделей приводит к увеличению вычислительной нагрузки и времени обучения, требуя более эффективных оптимизаторов для сокращения времени и ресурсов. SOAP — новый метод, объединяющий выгоды Adam и Shampoo, чтобы улучшить эффективность обучения без ущерба точности.

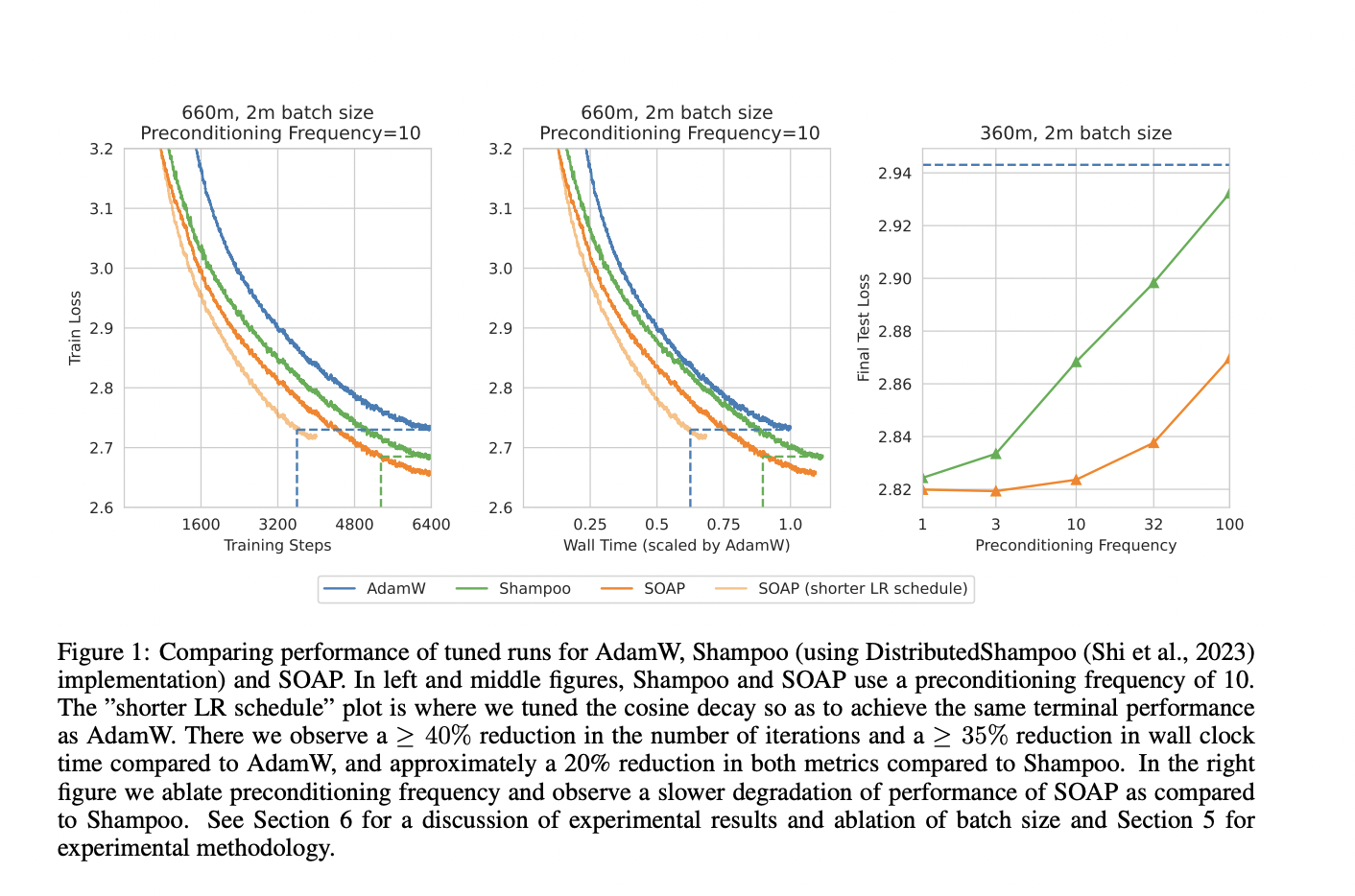

SOAP улучшает производительность и эффективность, уменьшая число итераций обучения на 40% и общее время на 35% по сравнению с AdamW, превосходя Shampoo на 20%. Этот метод обеспечивает баланс между эффективностью обучения и производительностью модели, делая его мощным инструментом для оптимизации крупных моделей.

Практические Советы по Внедрению ИИ

Примените ИИ для улучшения бизнес-процессов, начиная с малых проектов и анализируя результаты. Определите KPI, которые хотите улучшить с помощью ИИ, и подберите подходящее решение, внедряя его постепенно на основе полученного опыта.

Если вам нужны советы по внедрению ИИ, обращайтесь к нам в Telegram-чат itinai (https://t.me/itinai). Следите за новостями о ИИ в нашем Telegram-канале t.me/itinainews или в Twitter @itinairu45358. Используйте AI Sales Bot (https://itinai.ru/aisales) для автоматизации ответов на вопросы клиентов и генерации контента.

ИИ от AI Lab itinai.ru поможет вам оптимизировать процессы и оставаться впереди конкурентов. Будущее уже здесь!