«`html

Мультимодельные языковые модели (MLLM) и их эволюция

Архитектуры мультимодельных языковых моделей (MLLM) развиваются для улучшения взаимодействия текста и изображений с помощью различных техник. Модели, такие как Flamingo, IDEFICS, BLIP-2 и Qwen-VL, используют обучаемые запросы, в то время как LLaVA и MGM используют интерфейсы на основе проекций. LLaMA-Adapter и LaVIN фокусируются на эффективную настройку параметров. Качество набора данных значительно влияет на эффективность MLLM, и недавние исследования улучшают настройку визуальных инструкций для улучшения производительности в задачах вопросов и ответов. Высококачественные наборы данных для тонкой настройки с обширным разнообразием задач используются для превосходства в восприятии изображений, рассуждениях и задачах OCR.

Новый подход с набором данных Img-Diff

Набор данных Img-Diff представляет новый подход, акцентируя анализ различий изображений, что демонстрирует эмпирическую эффективность в улучшении профессионализма MLLM в VQA и возможностях локализации объектов. Этот фокус выделяет Img-Diff среди существующих наборов данных и продолжает работы в этой области. Предыдущие методы, такие как Shikra, ASM и PINK, использовали значительные объемы данных обнаружения объектов для улучшения возможностей локализации MLLM, заложив основы инновационного подхода Img-Diff к точному распознаванию и анализу изображений.

Эффективность набора данных Img-Diff

Набор данных Img-Diff значительно улучшил производительность MLLM на различных показателях. Модели, настроенные с помощью Img-Diff, превзошли современные модели на различных задачах различия изображений и VQA. Исследование подчеркивает важность высококачественных данных и развивающихся архитектур моделей в улучшении производительности MLLM. Оно рассматривает существующие подходы, такие как обучаемые запросы и интерфейсы на основе проекций, подчеркивая необходимость лучших наборов данных для решения сложных визуальных задач, включающих тонкие различия изображений. Исследование подтверждает разнообразие и качество Img-Diff, поощряя дальнейшее изучение синтеза мультимодальных данных.

Результаты исследования

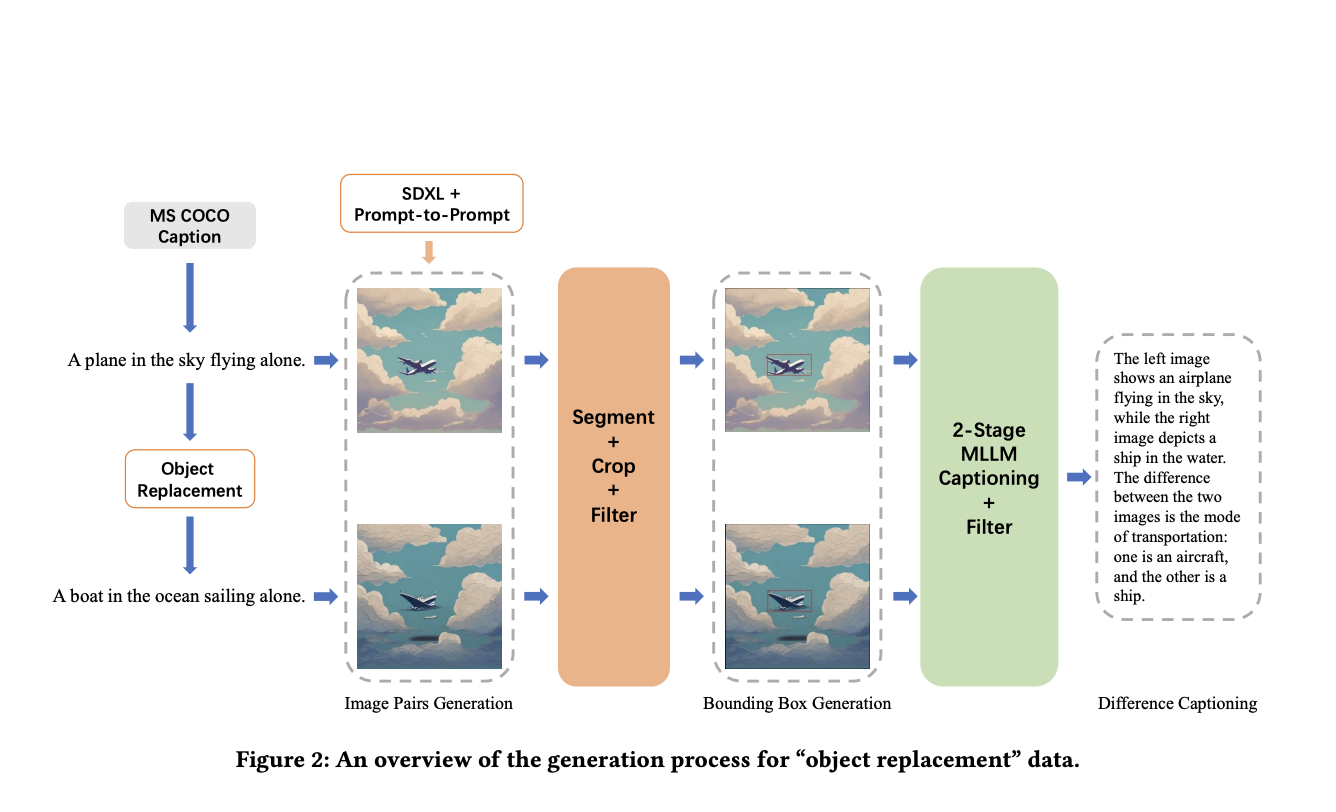

Исследователи разработали набор данных Img-Diff системным подходом. Они создали 118 000 пар изображений, используя подписи MSCOCO, применив фильтр сходства изображений, чтобы получить 38 533 высокосхожих пары. Регионы ограничивающих рамок с наименьшим сходством были выбраны, установив N равным 5. Два процесса фильтрации — сопоставление изображений и текста и сходство подписей — обеспечили допустимость ограничивающих рамок и подписей. Генератор различий областей произвел 117 779 кусков данных ограничивающих рамок, в то время как генератор различий подписей создал 12 688 высококачественных экземпляров «замены объекта» с подробными описаниями. Наконец, современные MLLM, такие как LLaVA-1.5-7B и MGM-7B, были настроены с использованием набора данных для улучшения производительности в задачах различия изображений и вызова VQA, демонстрируя эффективность Img-Diff в улучшении возможностей MLLM в точном распознавании изображений.

Заключение

Статья представляет новый набор данных, разработанный для улучшения производительности MLLM в задачах распознавания различий изображений. Набор данных Img-Diff, созданный с использованием инновационных методов, объединяющих контрастное обучение и подписи различий изображений, фокусируется на различиях объектов в парных изображениях. Тонкая настройка MLLM с использованием этого набора данных дает конкурентоспособные результаты производительности, сравнимые с моделями, обученными на гораздо больших наборах данных. Исследование подчеркивает важность тщательной генерации данных и процессов фильтрации, предоставляя идеи для будущих исследований в синтезе мультимодальных данных. Демонстрируя эффективность целевых высококачественных наборов данных в улучшении возможностей MLLM, статья поощряет дальнейшее изучение точного распознавания изображений и мультимодального обучения.

Проверьте статью и репозиторий на GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Твиттер и присоединиться к нашему каналу в Телеграме и группе в LinkedIn. Если вам понравилась наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Найдите предстоящие вебинары по ИИ здесь.

Arcee AI выпустила DistillKit: открытый инструмент для моделирования дистилляции, превращающий модели языка в эффективные, высокопроизводительные малые языковые модели.

Статья Img-Diff: новый набор данных для улучшения мультимодельных языковых моделей через контрастное обучение и анализ различий изображений впервые появилась на MarkTechPost.