AI Guardrails: Создание Ответственных ИИ Систем

Появление крупных языковых моделей (LLMs) открывает перед бизнесом бесконечные возможности, но и ставит перед ним серьезные вызовы. Растущее количество инцидентов, связанных с использованием ИИ, подчеркивает необходимость внедрения так называемых «защитных барьеров» (AI Guardrails) — средств контроля, которые помогают обеспечить соблюдение человеческих ценностей и стандартов. Как же реализовать эти защитные механизмы на практике и получить от этого максимальную выгоду?

Что такое AI Guardrails?

AI Guardrails — это система безопасности, которая включается на всех этапах разработки и эксплуатации ИИ. Это не просто фильтры на выходе, а целый ряд архитектурных решений, механизмов обратной связи и мониторинга. Основные компоненты включают:

- Предварительные барьеры: аудит данных, оценка моделей, уточнение политик.

- Барьер во время обучения: обучение с человеческой обратной связью (RLHF), защита конфиденциальности, слои снижения предвзятости.

- Пост-развертывочные барьеры: модерация выходов, непрерывная оценка и маршрутизация.

Доверенный ИИ: Принципы и Основы

Создание доверенного ИИ подразумевает соблюдение нескольких ключевых принципов:

- Надежность: модель должна демонстрировать стабильность в условиях изменений.

- Прозрачность: путь рассуждений должен быть понятен пользователям.

- Подотчетность: необходимо отслеживать действия и ошибки моделей.

- Справедливость: выходы моделей не должны усиливать социальные предвзятости.

- Сохранение конфиденциальности: использование методов, таких как федеративное обучение.

Оценка LLM: За Пределами Традиционных Метрик

Оценка LLM не сводится только к точности. Важно учитывать:

- Фактическая достоверность: как часто модель «галлюцинирует»?

- Токсичность и предвзятость: являются ли выходы инклюзивными и безопасными?

- Согласованность: следует ли модель инструкциям безопасно?

- Управляемость: можно ли направлять ее в соответствии с намерениями пользователя?

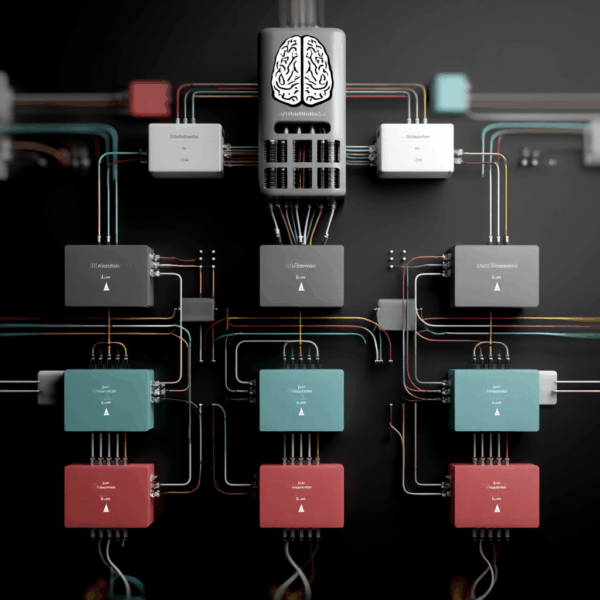

Архитектура Защитных Барьеров в LLM

Интеграция защитных барьеров должна начинаться на этапе проектирования. Примените структурированный подход:

- Слой определения намерений: классификация потенциально опасных запросов.

- Маршрутизация: перенаправление на системы с поддержкой извлечения (RAG) или на рецензию человеком.

- Фильтры постобработки: использование классификаторов для выявления вредоносного контента.

- Обратная связь: включает пользовательскую обратную связь и механизмы постоянной настройки.

Частые Проблемы и Лайфхаки

Несмотря на успехи, есть ряд проблем:

- Амбигация оценки: определение вредности или предвзятости может варьироваться.

- Балансировка: слишком много ограничений снижают полезность.

- Масштабирование обратной связи: обеспечение качества для миллиардов генераций.

- Непрозрачность моделей: многие конструкторы остаются черными ящиками.

Чтобы избежать распространенных ошибок, следуйте нескольким лайфхакам:

- Проводите регулярные тесты на предвзятость и токсичность.

- Включайте многоуровневую обратную связь от пользователей на всех этапах.

- Используйте открытые фреймворки для быстрого прототипирования и тестирования.

Заключение: К Ответственному Развертыванию ИИ

Защитные барьеры — это не конечное решение, а эволюционная сеть безопасности. Доверенный ИИ следует рассматривать как системный вызов, который требует интеграции архитектурной надежности, непрерывной оценки и этических соображений. В условиях растущей автономии языковых моделей, проактивные стратегии оценки LLM будут как этической необходимостью, так и технической необходимостью.

Часто Задаваемые Вопросы (FAQ)

1. Что такое защитные барьеры и почему они важны?

Защитные барьеры — это меры безопасности, которые помогают предотвратить вредные выходы и предвзятости, обеспечивая соответствие ИИ человеческим ценностям и правовым стандартам.

2. Как оцениваются большие языковые модели?

Оценка LLM включает в себя проверку фактической достоверности, токсичности, согласованности с намерениями пользователя и устойчивости к противодействующим атакам.

3. Каковы основные проблемы при внедрении защитных барьеров?

Ключевые проблемы включают неясность в определении вредного поведения, необходимость балансировки барьеров и полезности, и возможность высокой частоты ложных срабатываний.

4. Какие лучшие практики в области AI Guardrails?

Регулярное тестирование на предвзятость, многопрофильная обратная связь и использование открытых фреймворков помогут избежать распространенных ошибок.

5. Как защитные барьеры влияют на производительность ИИ?

Правильно внедренные защитные барьеры повышают доверие к ИИ-системам, минимизируя риски, не снижая при этом их полезность.

6. Почему необходимо учитывать этические аспекты в разработке ИИ?

Этические аспекты важны для создания доверительных отношений между ИИ и пользователями, а также для минимизации негативных последствий использования ИИ в реальных сценариях.