«`html

Превосходство ИИ: Практическое Применение и Преимущества

Применение Методологии Многократного In-Context Learning (ICL)

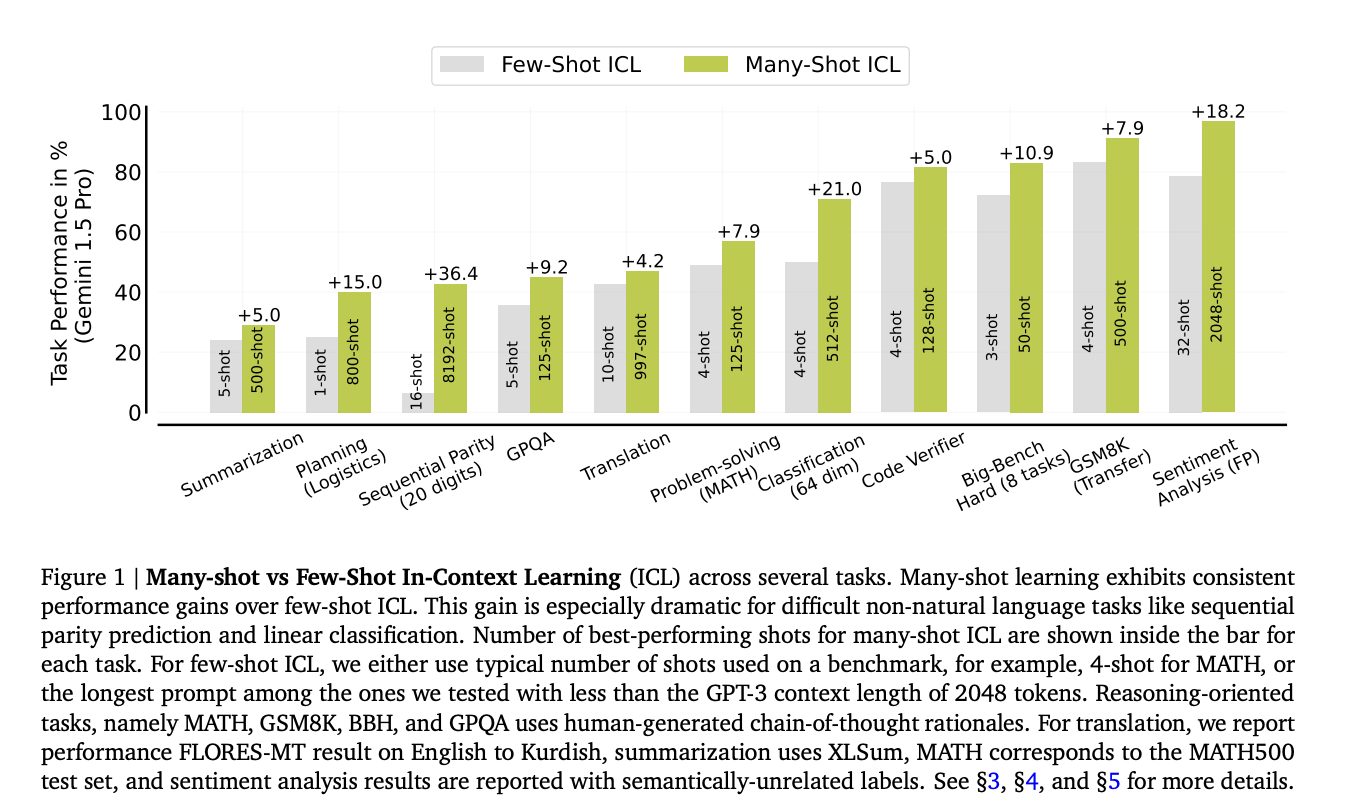

Методология многократного In-Context Learning (ICL) в больших языковых моделях (LLMs) использует примеры ввода-вывода для адаптации к новым задачам без изменения архитектуры модели. Этот подход трансформировал способ работы моделей с различными задачами, позволяя им учиться на прямых примерах, предоставленных во время вывода. Проблема заключается в ограничениях нескольких примеров ICL в обработке сложных задач, требующих глубокого понимания, которое невозможно достичь с помощью нескольких примеров, работающих с минимальным объемом входных данных.

Практические Решения и Значение

Существующие исследования в области ICL в основном сосредоточены на возможностях обучения несколькими примерами моделей, таких как GPT-3, которые адаптируются к новым задачам с ограниченным набором примеров. Недавние исследования показали ограничения в сложности задач и масштабируемости в моделях с небольшим окном контекста. Разработка моделей с более широким окном контекста, таких как Gemini 1.5 Pro, поддерживающих до 1 миллиона токенов, представляет собой значительное развитие. Это расширение позволяет исследовать многократный ICL, существенно улучшая способность моделей обрабатывать и учиться на большом наборе данных.

Исследования ученых из Google Deepmind показали, что переход от обучения несколькими примерами к обучению многократными примерами с использованием моделей, таких как Gemini 1.5 Pro, значительно улучшает производительность модели и ее адаптивность к сложным задачам. Уникальным аспектом этой методологии является интеграция Reinforced ICL и Unsupervised ICL, которые снижают зависимость от контента, созданного людьми, используя только данные, созданные моделью и входные данные, специфичные для области.

Результаты внедрения многократного ICL демонстрируют значительное улучшение производительности модели в различных задачах. В задачах машинного перевода модель Gemini 1.5 Pro показала улучшение точности на 4,5% для курдского и 1,5% для тамильского перевода по сравнению с предыдущими моделями. В решении математических задач датасет MATH показал улучшение точности решения на 35% при использовании многократных настроек. Эти количественные результаты подтверждают эффективность многократного ICL в улучшении адаптивности и точности модели в разнообразных и сложных когнитивных задачах.

В заключение, данное исследование представляет значительный шаг вперед в области ICL с переходом от обучения несколькими примерами к обучению многократными примерами с использованием модели Gemini 1.5 Pro. Расширение окна контекста и интеграция инновационных методологий, таких как Reinforced и Unsupervised ICL, успешно улучшили производительность модели в различных задачах, включая машинный перевод и решение математических задач. Эти достижения не только улучшают адаптивность и эффективность больших языковых моделей, но также открывают путь для более сложных приложений в области искусственного интеллекта.

Подробнее о исследовании.

Все права на исследование принадлежат исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему подпишитесь на наш Reddit.

Исходный текст: MarkTechPost.