«`html

Применение трансформерных нейронных сетей в различных задачах

Преимущества и недостатки увеличения размера моделей

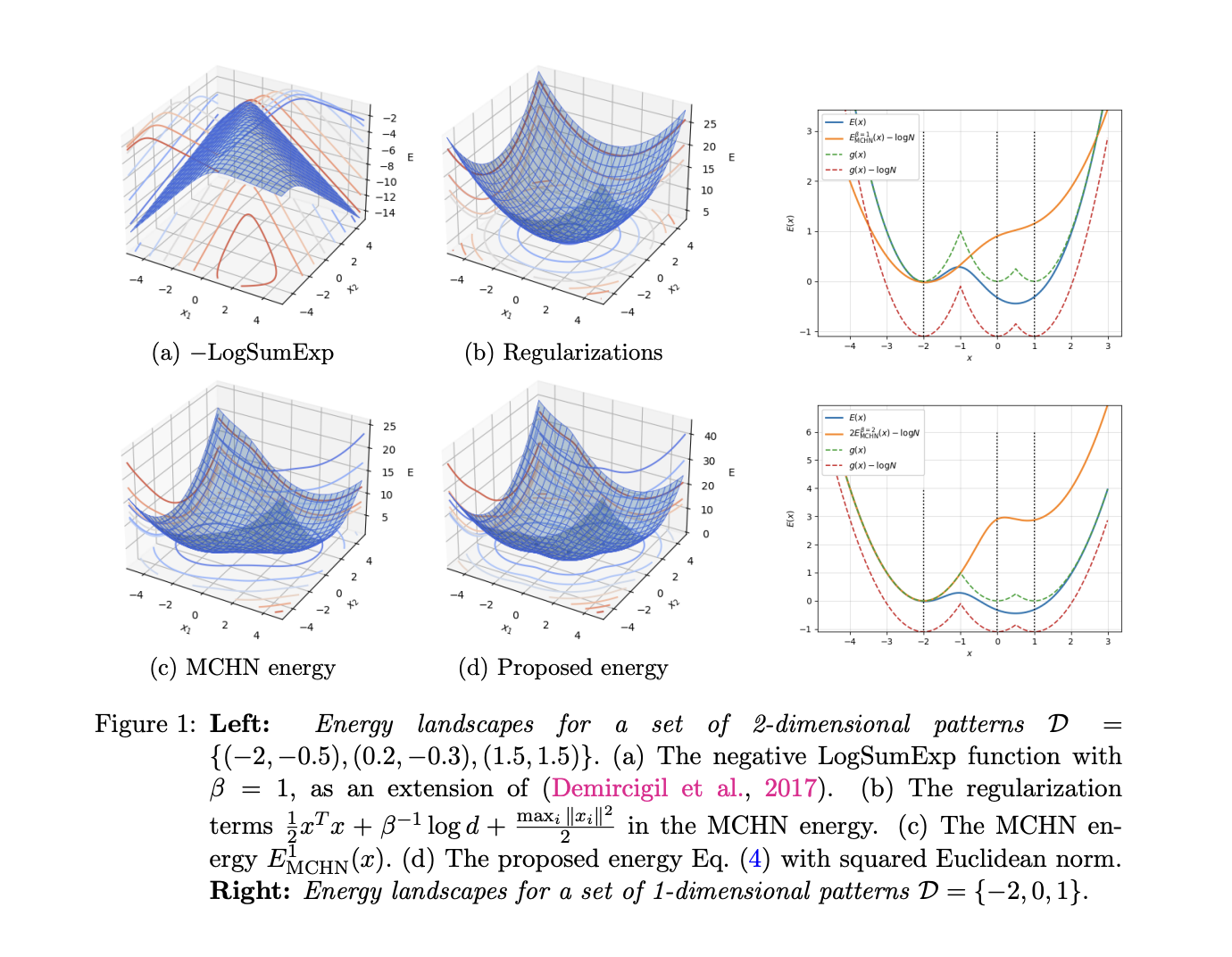

Трансформерные нейронные сети показывают отличные результаты в обработке текста, редактировании и вопросно-ответных задачах. Большие модели с большим количеством параметров обычно демонстрируют лучшую производительность, но иногда могут приводить к плохим результатам. Некоторые методы, такие как Scaling laws, Energy-based models и Hopfield models, используются для преодоления этих недостатков.

Результаты исследований и практическое применение

Исследователи из Центрального научно-исследовательского института и 2012 Laboratories Huawei Technologies Co., Ltd. представили теоретическую модель, которая позволяет понять процесс запоминания и динамику производительности трансформерных языковых моделей. Они провели ряд экспериментов с использованием модели GPT-2 и обучения моделей на наборе данных OpenWebText. Результаты экспериментов подтвердили теоретические выводы и предложили важные инсайты для улучшения обучения моделей.

Внедрение решений и контакты

Если вы хотите использовать искусственный интеллект в своей работе, свяжитесь с нами для получения консультаций и рекомендаций. Мы также предлагаем использовать AI Sales Bot для автоматизации работы с клиентами. Подпишитесь на наш Телеграм-канал и следите за новостями, чтобы быть в курсе всех обновлений и новых решений в области искусственного интеллекта.

«`