«`html

OuteAI представила новые модели Lite-Oute-1: Lite-Oute-1-300M и Lite-Oute-1-65M

OuteAI недавно представила свои последние достижения в моделях серии Lite — Lite-Oute-1-300M и Lite-Oute-1-65M. Эти новые модели разработаны для улучшения производительности при сохранении эффективности, что делает их подходящими для установки на различных устройствах.

Lite-Oute-1-300M: Улучшенная производительность

Модель Lite-Oute-1-300M, основанная на архитектуре Mistral, состоит примерно из 300 миллионов параметров. Цель этой модели — улучшить предыдущую версию с 150 миллионами параметров путем увеличения размера и обучения на более изысканном наборе данных. Основная цель модели Lite-Oute-1-300M — предложить улучшенную производительность, сохраняя при этом эффективность для установки на различные устройства.

Благодаря большему размеру модель Lite-Oute-1-300M обеспечивает улучшенное сохранение контекста и согласованность. Однако пользователи должны помнить, что как компактная модель, у нее все еще есть ограничения по сравнению с более крупными языковыми моделями. Модель была обучена на 30 миллиардах токенов с длиной контекста 4096, что обеспечивает надежные возможности обработки языка.

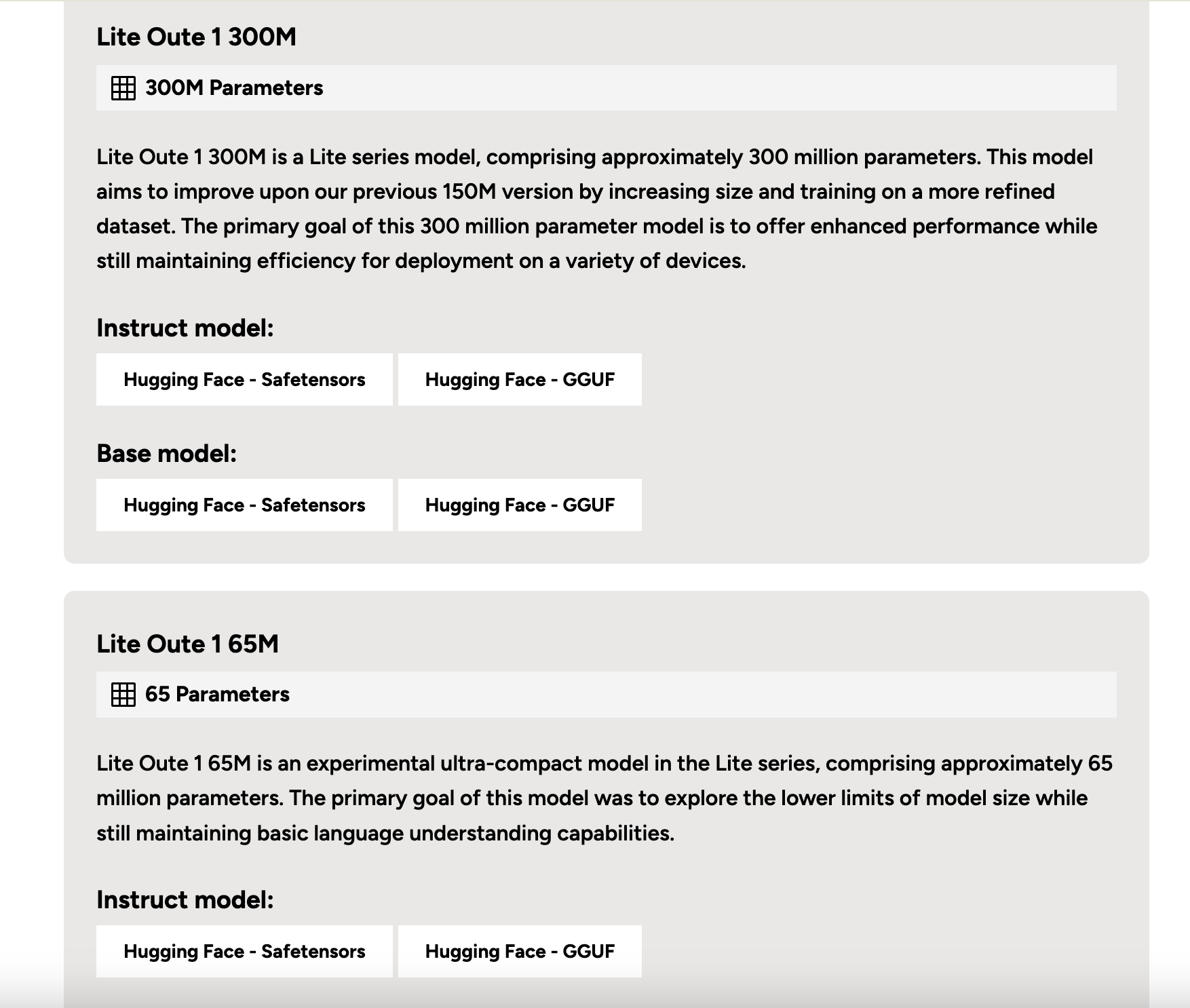

Модель Lite-Oute-1-300M доступна в нескольких версиях:

- Lite-Oute-1-300M-Instruct

- Lite-Oute-1-300M-Instruct-GGUF

- Lite-Oute-1-300M (Base)

- Lite-Oute-1-300M-GGUF

Для модели Lite-Oute-1-300M были проведены тесты производительности, демонстрирующие ее способности:

- ARC Challenge: 26.37 (5-shot), 26.02 (0-shot)

- ARC Easy: 51.43 (5-shot), 49.79 (0-shot)

- CommonsenseQA: 20.72 (5-shot), 20.31 (0-shot)

- и другие

Модель Lite-Oute-1-300M может быть использована с библиотекой трансформеров HuggingFace. Пользователи могут легко реализовать модель в своих проектах, используя код Python. Модель поддерживает генерацию ответов с параметрами, такими как температура и штраф за повтор, для тонкой настройки вывода.

Lite-Oute-1-65M: Исследование ультракомпактных моделей

В дополнение к модели 300M, OuteAI также выпустила модель Lite-Oute-1-65M. Эта экспериментальная ультракомпактная модель основана на архитектуре LLaMA и состоит примерно из 65 миллионов параметров. Основная цель этой модели — исследовать нижние пределы размера модели, сохраняя базовые возможности понимания языка.

Из-за своего крайне маленького размера модель Lite-Oute-1-65M демонстрирует базовые возможности генерации текста, но может иметь трудности с инструкциями или сохранением согласованности темы. Пользователи должны быть в курсе ее существенных ограничений по сравнению с более крупными моделями и ожидать непоследовательных или потенциально неточных ответов.

Модель Lite-Oute-1-65M доступна в нескольких версиях:

- Lite-Oute-1-65M-Instruct

- Lite-Oute-1-65M-Instruct-GGUF

- Lite-Oute-1-65M (Base)

- Lite-Oute-1-65M-GGUF

Модели Lite-Oute-1-300M и Lite-Oute-1-65M были обучены на аппаратном обеспечении NVIDIA RTX 4090. Модель 300M была обучена на 30 миллиардах токенов с длиной контекста 4096, в то время как модель 65M была обучена на 8 миллиардах токенов с длиной контекста 2048.

Заключение

В заключение, выпуск моделей Lite-Oute-1-300M и Lite-Oute-1-65M от OuteAI направлен на улучшение производительности при сохранении необходимой для развертывания на различных устройствах эффективности путем увеличения размера и улучшения набора данных. Эти модели балансируют размер и возможности, что делает их подходящими для множества приложений.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru — будущее уже здесь!

«`