Проект EuroLLM: Разработка мультиязычных языковых моделей для Европейского союза

Сбор и фильтрация данных

Модели EuroLLM обучались на разнообразных данных из различных источников для поддержки всех языков. Данные были разделены на веб-данные, параллельные данные, данные по коду/математике и высококачественные данные. Процесс сбора включал удаление дубликатов, идентификацию языка, фильтрацию по сложности и эвристическую фильтрацию для обеспечения качества.

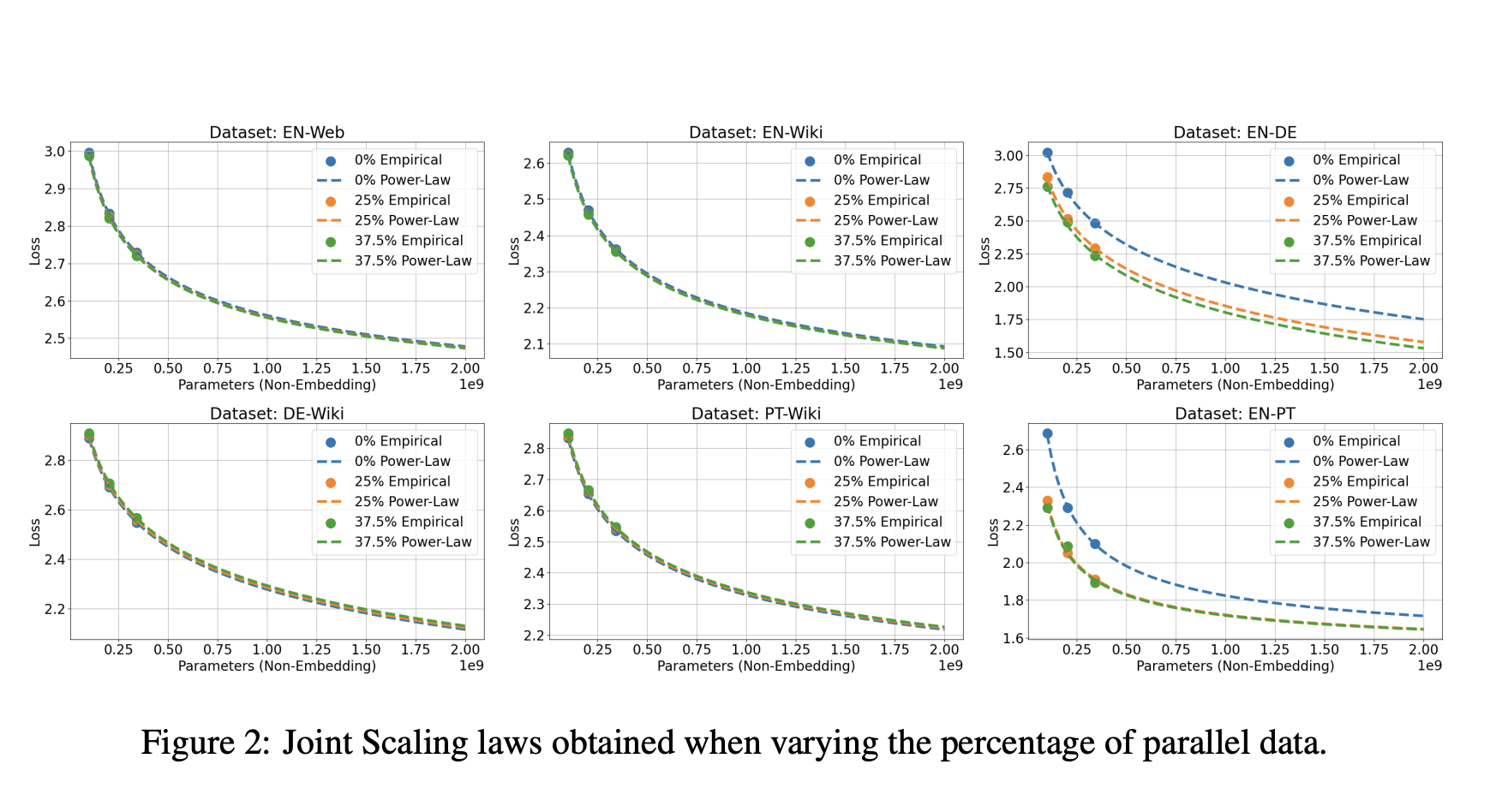

Смешивание данных

Корпус данных был тщательно подобран с учетом различных языков и областей. В начальной фазе обучения на английском языке приходилось 50% общего объема токенов, остальные распределялись между другими языками и данными по коду/математике. Доля английских данных была уменьшена до 32.5% для развития мультиязычных возможностей модели.

Токенизатор

Проект EuroLLM разработал мультиязычный токенизатор с словарем из 128 000 элементов, используя фреймворк SentencePiece. Этот токенизатор был ключевым для эффективной поддержки множества языков.

Конфигурация модели

Модель EuroLLM-1.7B использует стандартную архитектуру Transformer с модификациями для улучшения производительности. Она была предварительно обучена на 4 трлн токенов с использованием 256 Nvidia H100 GPU.

Пост-обучение и донастройка

Чтобы модель EuroLLM-1.7B могла следовать естественным языковым инструкциям, она была донастроена на наборе данных EuroBlocks, включающем человечески написанные и синтетические данные.

Результаты

Модели EuroLLM были оценены на общих показателях и задачах машинного перевода. EuroLLM-1.7B показала улучшенные мультиязычные возможности по сравнению с другими моделями. EuroLLM-1.7B-Instruct превзошла другие модели в задачах машинного перевода.

Заключение и будущая работа

Проект EuroLLM успешно разработал мультиязычные языковые модели для поддержки всех языков Европейского союза. Будущая работа будет сосредоточена на увеличении числа параметров модели и улучшении качества данных для улучшения производительности мультиязычных моделей.