MagpieLM-Chat Модели

MagpieLM-4B-Chat-v0.1 и MagpieLM-8B-Chat-v0.1 — новые модели языка, оптимизированные для выравнивания. Они обучены специально для того, чтобы их выводы соответствовали инструкциям человека, этическим стандартам и ожиданиям поведения.

Открытый и прозрачный подход

Проект MagpieLM-Chat отличается открытостью и воспроизводимостью. Команда предоставила модели и все необходимые данные для обучения, включая наборы данных Supervised Fine-Tuning (SFT) и Direct Preference Optimization (DPO). Это позволяет другим исследователям воспроизводить процессы обучения и выравнивания.

Конкурентоспособная производительность и бенчмаркинг

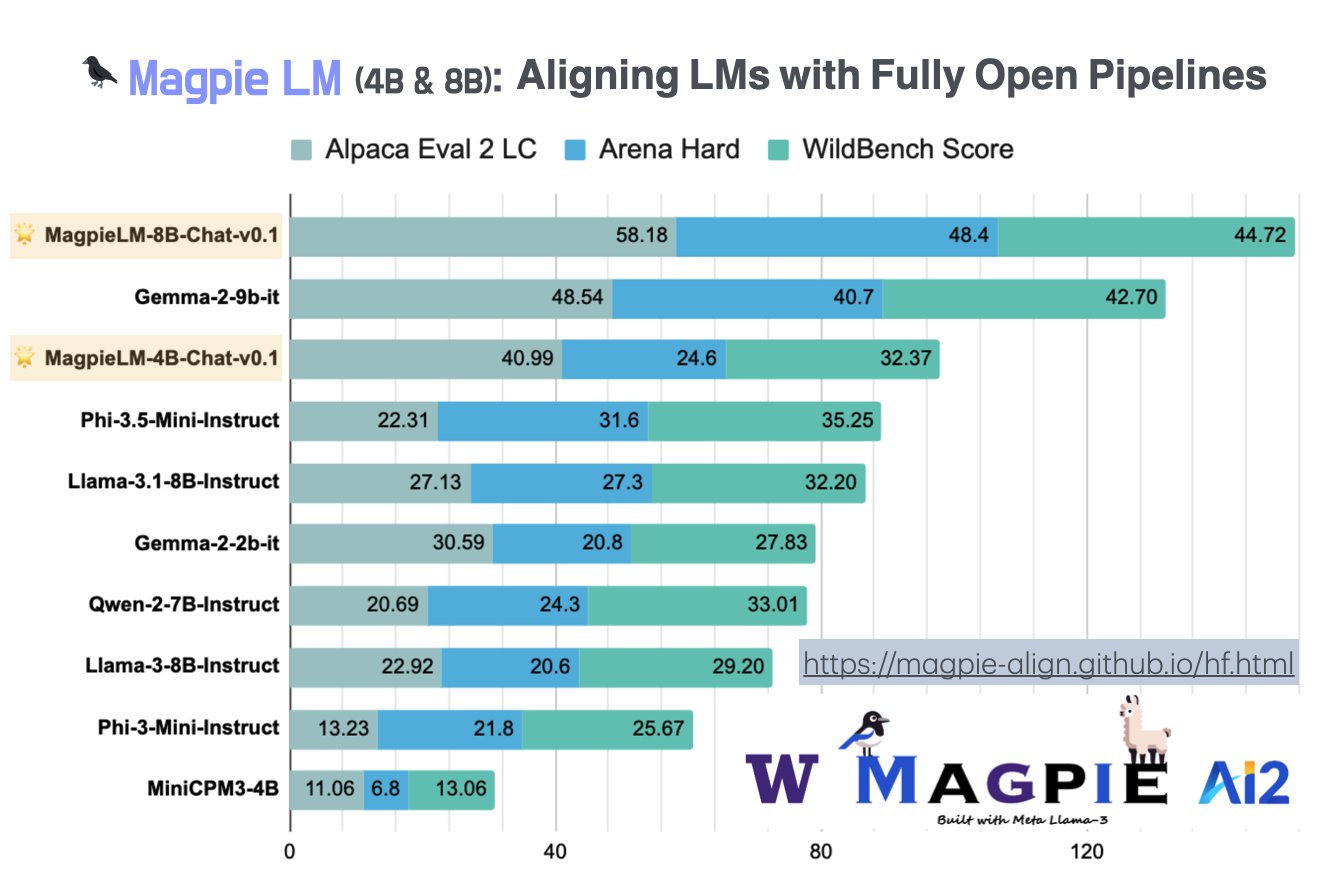

MagpieLM-Chat модели показали отличные результаты на нескольких ключевых бенчмарках оценки. Они справляются с разнообразными задачами и демонстрируют высокое качество генерации текста.

Выпуск других ресурсов: SFT-Data и DPO-Data

Помимо моделей MagpieLM-Chat, команда выпустила два крупных набора данных: MagpieLM-SFT-Dat-v0.1 и MagpieLM-DPO-Data-v0.1. Эти наборы данных представляют собой ценный ресурс для исследователей, интересующихся выравниванием и техниками пост-обучения.

Выравнивание после обучения и синтетические данные

Метод Magpie сосредотачивается на выравнивании после обучения с использованием синтетических данных. Это позволяет улучшить поведение модели, чтобы она соответствовала человеческим целям.

Дорога вперед: Совместимость данных и модели

Команда намекает, что будущие разработки будут сосредоточены на совместимости данных и модели, что является критической областью исследований в области ИИ.

Заключение

Выпуск моделей MagpieLM-Chat, как 4B, так и 8B версий, является значительным шагом в области выравнивания ИИ. Этот проект предоставляет высокопроизводительные модели языка и ценные наборы данных для исследовательского сообщества.

Для получения дополнительной информации и консультаций по внедрению ИИ обращайтесь к нам!