«`html

State-space models (SSMs) в глубоком обучении для моделирования последовательностей

SSMs представляют системы, где выход зависит как от текущих, так и от прошлых входов. Они широко применяются в обработке сигналов, системах управления и обработке естественного языка.

Основные проблемы:

Неэффективность существующих SSMs, особенно в отношении затрат памяти и вычислительных ресурсов.

Традиционные SSMs требуют больше сложности и использования ресурсов при увеличении состояния, что ограничивает их масштабируемость и производительность в масштабных приложениях.

Существующие решения:

Фреймворки S4 и S4D, использующие диагональные представления состояний для управления сложностью.

Методы на основе быстрого преобразования Фурье (FFT) для эффективной параллельности последовательностей.

Трансформеры с механизмами самовнимания и Hyena с включенными сверточными фильтрами для длинных зависимостей.

Liquid-S4 и Mamba, оптимизирующие моделирование последовательностей через выборочные пространства состояний и управление памятью.

Long Range Arena для оценки производительности моделей на длинных последовательностях.

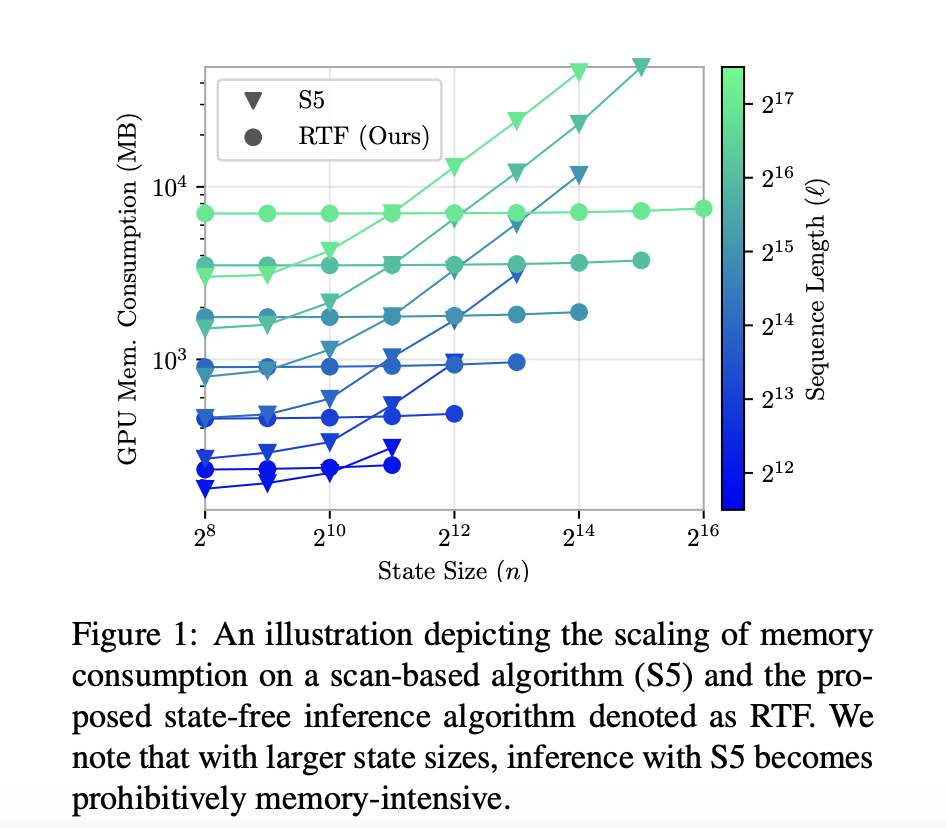

Новое решение: Rational Transfer Function (RTF)

Использование передаточных функций для эффективного моделирования последовательностей без необходимости памяти-интенсивных представлений состояний.

Использование FFT для параллельного вывода, что значительно улучшает вычислительную скорость и масштабируемость.

Результаты:

RTF демонстрирует значительные улучшения в нескольких бенчмарках, включая Long Range Arena и синтетические задачи.

Увеличение скорости обучения на 35% по сравнению с S4 и S4D, улучшение точности классификации на 3% и 2% в различных задачах.

Снижение ошибок в синтетических задачах на 15% и 20% соответственно.

Заключение:

RTF представляет собой значительное улучшение в моделировании последовательностей, обеспечивая эффективность и эффективность на различных наборах данных. Это критически важно для масштабируемого и эффективного моделирования последовательностей.

Ссылка на статью.

Кредит за это исследование принадлежит его авторам.

Следите за нами в Twitter.

Присоединяйтесь к нам в Telegram, Discord и LinkedIn.

Познакомьтесь с нашими новостями.

Присоединяйтесь к нашему Reddit.

Источник: MarkTechPost

«`