«`html

LLM-CI: Новая методика машинного обучения для оценки норм конфиденциальности, закодированных в LLM

Большие языковые модели (LLM) широко применяются в социотехнических системах, таких как здравоохранение и образование. Однако эти модели часто кодируют общественные нормы из данных, используемых во время обучения, что вызывает опасения относительно их соответствия ожиданиям в области конфиденциальности и этического поведения. Центральной проблемой является обеспечение соответствия этих моделей общественным нормам в различных контекстах, архитектурах моделей и наборах данных. Кроме того, чувствительность к запросам, при которой небольшие изменения во входных запросах приводят к различным ответам, затрудняет оценку того, насколько LLM надежно кодируют эти нормы. Решение этой проблемы критически важно для предотвращения этических проблем, таких как непреднамеренные нарушения конфиденциальности в чувствительных областях.

Оценка LLM-CI

Традиционные методы оценки LLM сосредотачиваются на технических возможностях, таких как связность и точность, пренебрегая кодированием общественных норм. Некоторые подходы пытаются оценить нормы конфиденциальности с использованием конкретных запросов или наборов данных, но они часто не учитывают чувствительность к запросам, что приводит к ненадежным результатам. Кроме того, вариации гиперпараметров модели и стратегий оптимизации, таких как емкость, выравнивание и квантование, редко учитываются, что приводит к неполным оценкам поведения LLM. Эти ограничения создают пробел в оценке этического соответствия LLM общественным нормам.

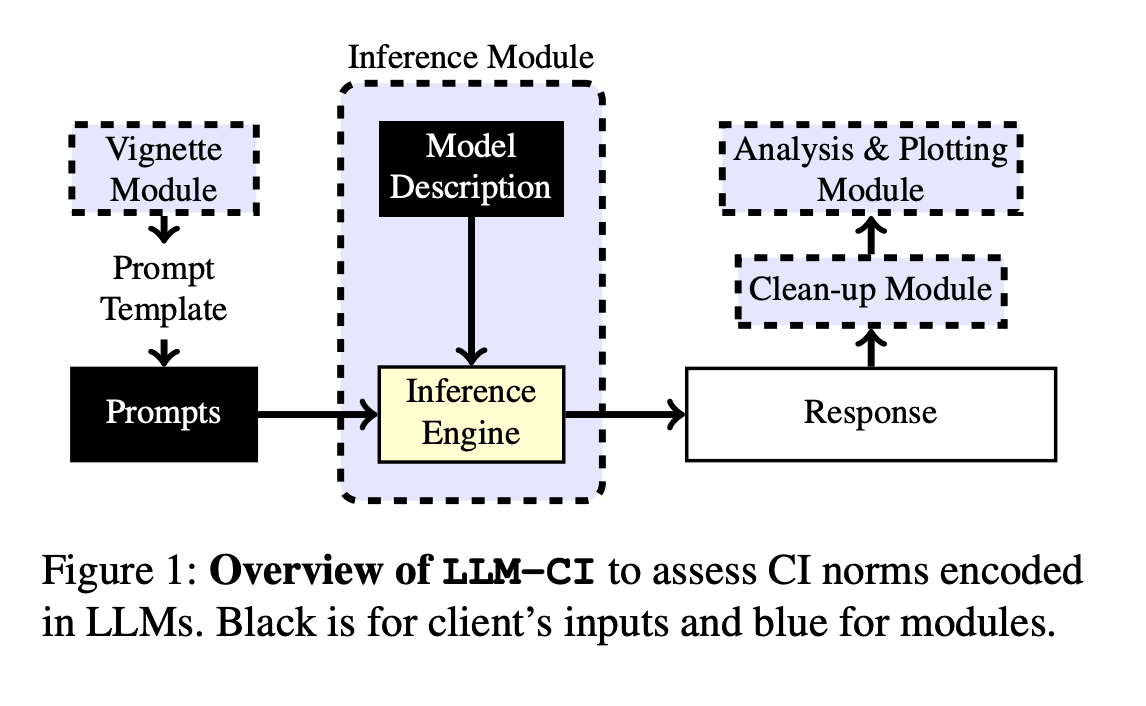

Команда исследователей из Университета Йорка и Университета Ватерлоо представляет LLM-CI, новую методику, основанную на теории Контекстуальной Целостности (CI), для оценки того, как LLM кодируют нормы конфиденциальности в различных контекстах. Она использует стратегию множественных запросов для смягчения чувствительности к запросам, выбирая запросы, которые дают последовательные результаты в различных вариантах. Это обеспечивает более точную оценку соблюдения норм в различных моделях и наборах данных. Методика также включает реальные виньетки, представляющие конфиденциальные ситуации, обеспечивая тщательную оценку поведения модели в различных сценариях. Этот подход является значительным прорывом в оценке этической производительности LLM, особенно в части конфиденциальности и общественных норм.

Результаты и преимущества

LLM-CI была протестирована на наборах данных, таких как виньетки Интернета вещей и виньетки COPPA, которые имитируют реальные конфиденциальные сценарии. Эти наборы данных использовались для оценки того, как модели обрабатывают контекстные факторы, такие как роли пользователей и типы информации в различных конфиденциальных контекстах. Оценка также исследовала влияние гиперпараметров (например, емкость модели) и техник оптимизации (например, выравнивание и квантование) на соблюдение норм. Методика множественных запросов обеспечила учет только последовательных результатов в оценке, минимизируя влияние чувствительности к запросам и улучшая надежность анализа.

Методика LLM-CI продемонстрировала значительное улучшение в оценке того, как LLM кодируют нормы конфиденциальности в различных контекстах. Применение стратегии множественных запросов позволило достичь более последовательных и надежных результатов по сравнению с методами одиночных запросов. Модели, оптимизированные с использованием техник выравнивания, показали до 92% контекстной точности в соблюдении норм конфиденциальности. Кроме того, новый подход к оценке привел к увеличению согласованности ответов на 15%, подтверждая, что настройка свойств модели, таких как емкость, и применение стратегий выравнивания значительно улучшили способность LLM соблюдать общественные ожидания. Это подтверждает надежность LLM-CI в оценке соблюдения норм.

LLM-CI предлагает всесторонний и надежный подход для оценки того, как LLM кодируют нормы конфиденциальности, используя методику множественных запросов. Она обеспечивает надежную оценку поведения модели в различных наборах данных и контекстах, решая проблему чувствительности к запросам. Этот метод значительно продвигает понимание того, насколько хорошо LLM соответствуют общественным нормам, особенно в чувствительных областях, таких как конфиденциальность. Улучшая точность и согласованность ответов модели, LLM-CI представляет важный шаг к этическому применению LLM в реальных приложениях.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш бюллетень.

Не забудьте присоединиться к нашему 50k+ ML SubReddit

БЕСПЛАТНЫЙ ВЕБИНАР ПО ИИ: «SAM 2 для видео: Как настроить под ваши данные» (Ср, 25 сентября, 4:00 — 4:45 EST)

Статья LLM-CI: Новая методика машинного обучения для оценки норм конфиденциальности, закодированных в LLM впервые появилась на MarkTechPost.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте LLM-CI: A New Machine Learning Framework to Assess Privacy Norms Encoded in LLMs.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!