«`html

Продвинутые модели языковых моделей (LLM) и их ограничения

LLM значительно продвинулись в последние годы, проявляя впечатляющие возможности в различных задачах. Однако их производительность часто ухудшается при работе с длинными входными последовательностями. Это ограничение может затруднить их применение в областях, требующих обширной обработки информации, таких как резюмирование документов, вопросно-ответные системы и машинный перевод.

Ограничения текущих моделей и методов оценки

Текущие модели ограничены короткими контекстными окнами, что ограничивает их способность удерживать и использовать большие объемы информации, приводя к использованию менее точных техник запоминания. Проблема усугубляется недостаточными метриками оценки, которые не могут точно измерить способность модели эффективно обрабатывать обширный контекст. Существующие методы оценки длинных контекстов, такие как тест «Игла в стоге сена», не могут обеспечить адекватную оценку, так как они предоставляют семантические подсказки, что упрощает поиск информации моделями. Эти методы часто приводят к завышенным показателям производительности для моделей с фундаментально ограниченными возможностями, такими как Рекуррентные Нейронные Сети (RNN) и Модели Пространства Состояний (SSM).

Практические решения от Magic AI Lab

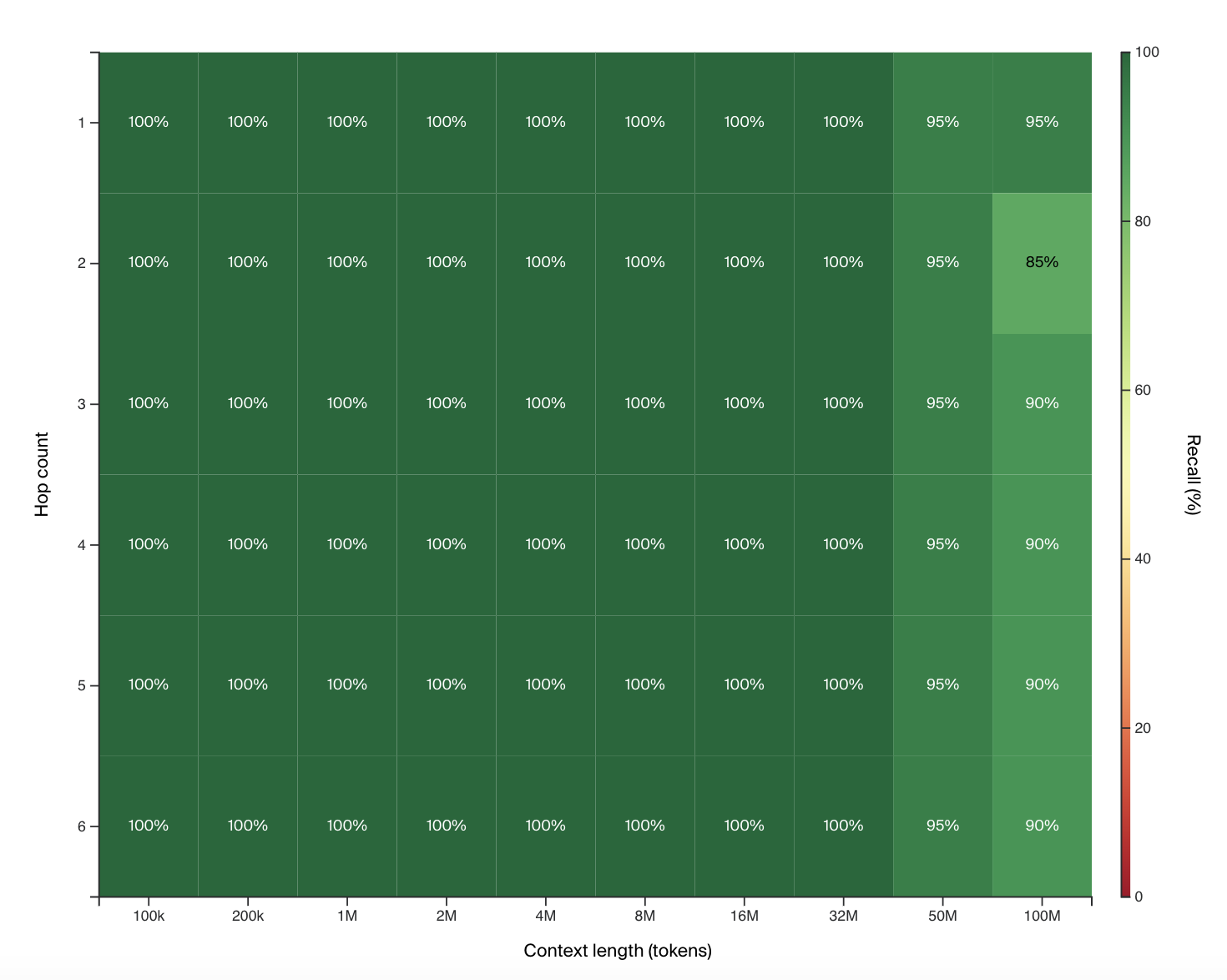

Magic AI Lab решает проблему улучшения способности ИИ-моделей обрабатывать и рассуждать с ультра-длинными контекстами во время вывода, представляя новый инструмент оценки под названием HashHop. HashHop использует случайные непреобразуемые хэш-пары, что делает невозможным для моделей использование явных путей. Кроме того, Magic разработала модель долгосрочной памяти (LTM), способную обрабатывать до 100 миллионов токенов в контексте, что значительно превосходит существующие модели по памяти и вычислительной мощности.

Инструмент оценки HashHop измеряет способность модели вспоминать и рассуждать по нескольким «прыжкам» хэш-пар без использования семантических подсказок. Модель должна завершить последовательность хэш-пар, которые могут быть перемешаны для обеспечения инвариантности порядка и положения. Модель LTM-2-mini, обученная с использованием этого метода, показывает многообещающие результаты в обработке до 100 миллионов токенов, демонстрируя свою способность рассуждать над большими контекстами гораздо более эффективно, чем традиционные модели. В отличие от других моделей, таких как Llama 3.1 405B, требующих огромных вычислительных ресурсов, LTM-2-mini работает за долю стоимости, что делает его более практичным для реальных приложений. Хотя модель показывает снижение производительности с более чем двумя «прыжками» без «цепи мыслей», ее способность эффективно управлять двумя «прыжками» указывает на то, что она может строить более сложные цепи рассуждений, чем традиционные одношаговые модели.

В заключение, предложенная модель представляет собой значительный прогресс в способности ИИ обрабатывать ультра-длинные контексты, особенно в разработке программного обеспечения. Модель LTM-2-mini от Magic, оцененная с использованием нового метода HashHop, предлагает более надежный и эффективный подход к обработке обширных контекстных окон. Это разрешает ограничения текущих моделей и методов оценки, представляя многообещающее решение для улучшения синтеза кода и других приложений, требующих глубокого контекстного понимания.

Связаться с нами

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`