«`html

Together AI представляет TEAL: Революционный метод активации сжатия без обучения для оптимизации больших языковых моделей с улучшенной эффективностью и минимальным ухудшением в ресурсо-ограниченных средах

Together AI представила новаторскую технику, известную как TEAL (Training-Free Activation Sparsity in LLMs), которая имеет потенциал значительно продвинуть область эффективного вывода моделей машинного обучения. Компания, являющаяся лидером в области открытых моделей искусственного интеллекта, исследует инновационные способы оптимизации производительности моделей, особенно в условиях ограниченных ресурсов памяти. TEAL представляет собой значительный шаг в этом направлении, предоставляя новый метод сжатия активации в LLMs, что обещает улучшенную производительность с минимальным ухудшением модели.

Вызовы в области больших языковых моделей

LLMs известны своими впечатляющими возможностями, но печально известны своими огромными требованиями к памяти. Традиционные процессы вывода в этих моделях ограничены скоростью передачи данных между памятью и вычислительными устройствами. Эта память-зависимая природа привела к разработке нескольких техник, таких как квантование и разреженность веса, для уменьшения размеров моделей без ущерба производительности.

Одним из более недавних достижений является активационная разреженность, которая использует определенные избыточные скрытые состояния в LLMs, позволяя обрезать ненужные весовые каналы. Однако модели, такие как LLaMA, перешли от использования MLP на основе ReLU (естественно обладающих высокой разреженностью) к MLP на основе SwiGLU, которые менее подходят для активационной разреженности. Это затруднило успешное применение техник активационной разреженности в новых моделях.

Концепция TEAL

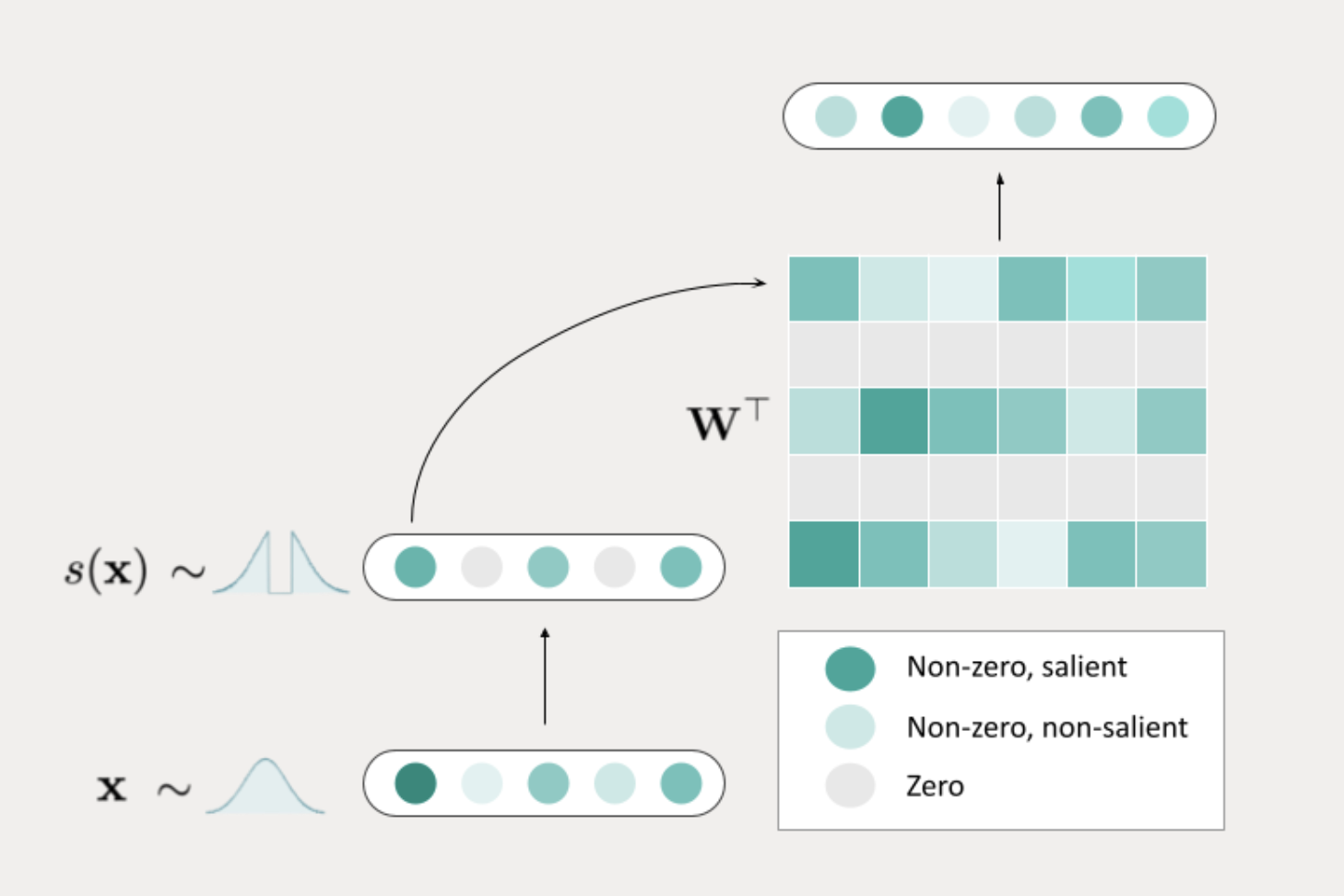

TEAL выступает в качестве решения для вызовов, поставленных активационной разреженностью в современных LLMs. Он представляет собой простой, не требующий обучения подход, который обеспечивает разреженность активации путем применения обрезки по величине к скрытым состояниям по всей модели. Этот подход позволяет достичь впечатляющей модельной разреженности 40-50% с минимальным воздействием на производительность.

Основное преимущество TEAL заключается в его способности оптимизировать разреженность по всем тензорам в модели. В отличие от предыдущих методов, таких как CATS, которые разреживали только определенные области модели, TEAL нацелен на каждый тензор, достигая более высокой общей разреженности без необходимости дополнительной настройки или предварительного обучения. TEAL значительно снижает пропускную способность памяти, необходимую для вывода LLM, избегая передачи в память весовых каналов со значениями ноль, что приводит к более быстрой обработке.

Техническая реализация TEAL

Реализация TEAL фокусируется на оптимизации разреженности на уровне блока трансформатора, обеспечивая, что каждый тензор в модели получает преимущества от разреженности. При разреженности 25% модель почти не теряет в производительности, а при разреженности 40-50% ухудшение остается минимальным. Это в отличие от других методов, таких как CATS, которые показывают более значительное снижение производительности на более высоких уровнях разреженности. Одним из ключевых факторов успеха TEAL является его подход к разреживанию матриц весов. TEAL осуществляет разреживание матриц весов, а не через воротные выходы, как это происходит в других методах. Этот выбор дизайна приводит к более низким показателям ошибок и лучшей общей производительности, даже на более высоких уровнях разреженности. В результате TEAL может достичь ускорений от 1,53x до 1,8x в декодировании одиночной партии, что является значительным улучшением для прикладных задач, где скорость вывода критична.

Совместимость с оборудованием и квантованием

Помимо преимуществ активационной разреженности, TEAL также совместим с квантованием, еще одной ключевой техникой для уменьшения размера и улучшения эффективности LLM. Квантование уменьшает точность параметров модели, уменьшая объем памяти и вычислительные ресурсы, необходимые для вывода. Подход TEAL к разреживанию разреживания дополняет методы квантования, позволяя моделям достигать еще больших ускорений, сохраняя производительность. Интеграция TEAL с GPT-Fast от Together AI, а также поддержка CUDA Graphs и Torch Compile, дополнительно улучшили его аппаратную эффективность. TEAL хорошо работает на графических процессорах, включая A100 GPU, которые в определенных сценариях могут превзойти традиционные плотные ядра. Это делает его привлекательным вариантом для сред с ограниченными аппаратными ресурсами, особенно при выполнении задач вывода с низкими партиями.

Приложения и потенциал в будущем

Наиболее непосредственное применение TEAL ускоряет вывод в ресурсо-ограниченных средах, таких как периферийные устройства с ограниченной памятью и вычислительной мощностью. Способность TEAL оптимизировать использование памяти и снижать задержку при выводе LLM делает его идеальным решением в таких сценариях. Он отлично работает при низких партиях, где можно достичь наибольших ускорений. TEAL также обещает для провайдеров вывода, управляющих большими флотами GPU и моделей. Together AI, которая размещает более 100 ведущих открытых моделей, хорошо подготовлена для использования улучшений производительности TEAL. TEAL позволяет обслуживать эти модели более эффективно, уменьшая объем памяти и улучшая скорость обработки, даже при относительно небольших активных партиях.

Заключение

Выпуск TEAL от Together AI является значительным шагом в оптимизации LLMs. TEAL предлагает простое и эффективное решение для памятных узких мест, которые долгое время мучили вывод LLM, представляя подход без обучения к активационной разреженности. Его способность достигать общей разреженности с минимальным ухудшением и совместимость с квантованием делают его мощным инструментом для улучшения эффективности моделей машинного обучения в ресурсо-ограниченных средах и масштабных сценариях вывода.

Подробности можно посмотреть здесь. Вся кредит за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и LinkedIn. Присоединяйтесь к нашему каналу в Telegram.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 50k+ ML SubReddit

«`