«`html

Языковые модели обучения (LLM), которые хорошо рассуждают и дают хорошие ответы, иногда честно признают свои ошибки и могут начать галлюцинировать, когда им задают вопросы, которые они не видели раньше. Когда ответы состоят из более чем одного токена, становится очень важным определить, как получить доверительные оценки от LLM.

Обучение и подходы на основе запросов используются для получения уверенности от LLM

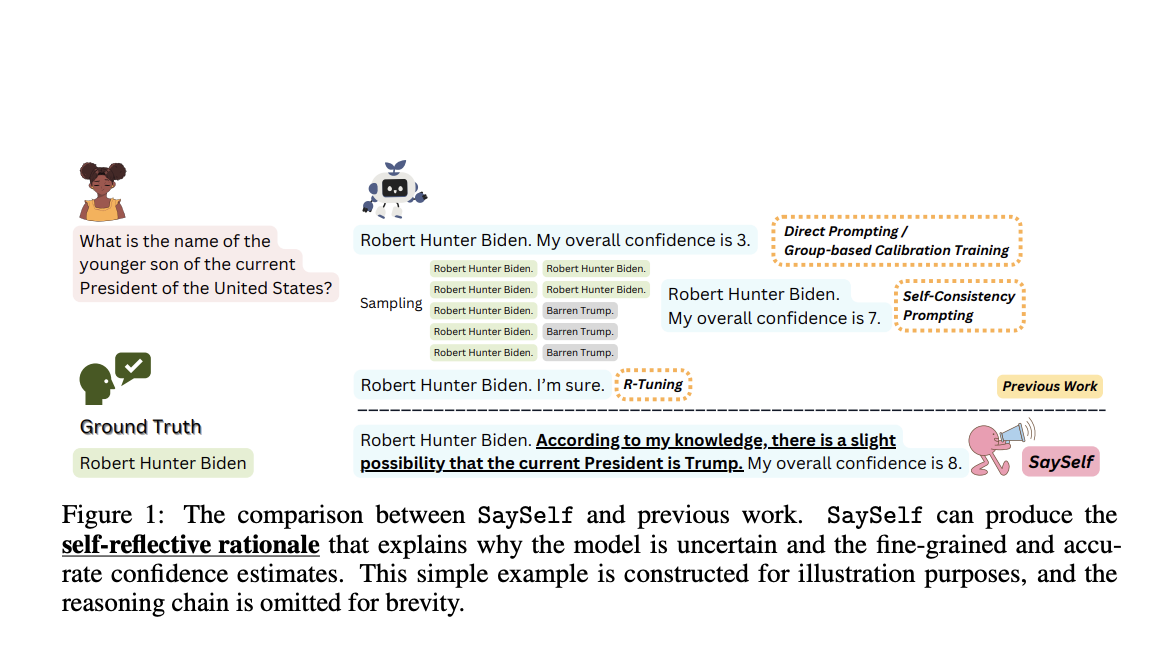

Существуют подходы, основанные на обучении и запросах, для получения уверенности от LLM. Например, подходы на основе запросов используют конкретные запросы для создания оценок уверенности или согласованность ответов в качестве индикации уверенности. Для обучения LLM находить уверенность, методы, основанные на обучении, создают настраиваемые наборы данных для настройки. Однако эти техники часто дают менее чем идеальные или упрощенные оценки уверенности, которые не отражают достоверно степень уверенности моделей.

Интродукция SaySelf: обучающая структура для LLM

Новое исследование Пердьюского университета, Университета Иллинойса в Урбана-Шампейне, Университета Южной Калифорнии и Гонконгского университета науки и технологии представляет SaySelf, обучающую структуру для LLM, которая помогает им производить уверенные оценки с увеличенной точностью. Важно то, что, в отличие от предыдущих работ, SaySelf позволяет LLM давать самоотражающие рационализации, показывающие, где у них отсутствует знание и объясняющие их оценки уверенности. Для этого исследователи используют заранее подготовленную LLM (например, GPT4) для автоматического создания набора данных, настроенного под модель, который затем можно использовать для контролируемой донастройки. Они берут случайную выборку из нескольких цепочек рассуждений, которые представляют собой последовательности токенов, отображающих мыслительный процесс LLM, для каждого запроса. После этого цепочки рассуждений группируются в кластеры по их семантической сходности, и из каждой группы выбирается один пример.

С точки зрения первого лица GPT-4 просят проанализировать выбранные случаи из различных кластеров и суммировать неопределенность относительно конкретного знания простым языком. Исследователи калибруют оценку уверенности LLM в каждом ответе с помощью обучения с подкреплением, чтобы обеспечить точные оценки уверенности. Они разрабатывают систему оплаты, которая отговаривает LLM от слишком уверенных предсказаний и наказывает их за ошибки. В этом исследовании SaySelf оценивается на различных задачах ответов на вопросы, таких как сложные медицинские диагнозы или анализ юридических случаев. Исследование показывает, что SaySelf сохраняет производительность в задачах, существенно уменьшая ошибки калибровки уверенности. Развитие самоотражающих рационализаций позволяет дальнейшее улучшение калибровки уверенности, успешно захватывая внутреннюю неопределенность.

Практическое применение результатов исследования

Результаты исследования могут повлиять на академические и практические приложения следующим образом:

- AI может получить прозрачное заявление уверенности, включающее объяснения, что положительно скажется на выравнивании LLM.

- LLM могут улучшить взаимодействие и производительность, следуя самоотражающим рационализациям для выполнения дополнительных действий, таких как запрос внешних инструментов или уточняющие вопросы.

Приглашаем к сотрудничеству

По завершении процесса обучения SaySelf, команда надеется увидеть стимулирующие улучшения в процедурах обучения, таких как алгоритмы активного обучения, улучшающие результаты обучения LLM через их взаимодействие с людьми.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашим каналам в Telegram, Discord и LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему сообществу более чем 43 тыс. участников на Reddit — 43k+ ML SubReddit. Также ознакомьтесь с нашей платформой мероприятий по ИИ.