«`html

Решение для надежных и точных ответов от больших языковых моделей

Исследование решает проблему обеспечения точности, достоверности и проверяемости ответов от больших языковых моделей (LLM) путем правильного цитирования надежных источников. Существующие методы часто нуждаются в помощи при ошибках и галлюцинациях, что приводит к неправильной или вводящей в заблуждение информации в сгенерированных ответах. Данное исследование направлено на улучшение точности и надежности выводов LLM путем внедрения новой системы проверки. Поскольку LLM становятся все более мощными и распространенными, важно исследовать, как их производительность масштабируется с увеличением размера модели и объема обучающих данных. Авторы стремятся предоставить понимание свойств масштабирования LLM и их отличий от более маленьких моделей.

Практические решения и ценность

В настоящее время LLM используются для задач информационного поиска и генерации, акцентируя внимание на обосновании ответов в проверяемых источниках. Стандартные подходы включают генерацию с использованием информационного поиска, где LLM инструктируются генерировать ответы вместе с соответствующими источниками в одном процессе вывода. Более сложные методы включают предварительные этапы, такие как резюмирование соответствующих документов или извлечение ключевой информации для обогащения входного запроса. Однако эти подходы сталкиваются с трудностями в поддержании точности и качества цитирования из-за сложности обработки больших объемов данных за один проход и риска распространения ошибок с предварительных этапов.

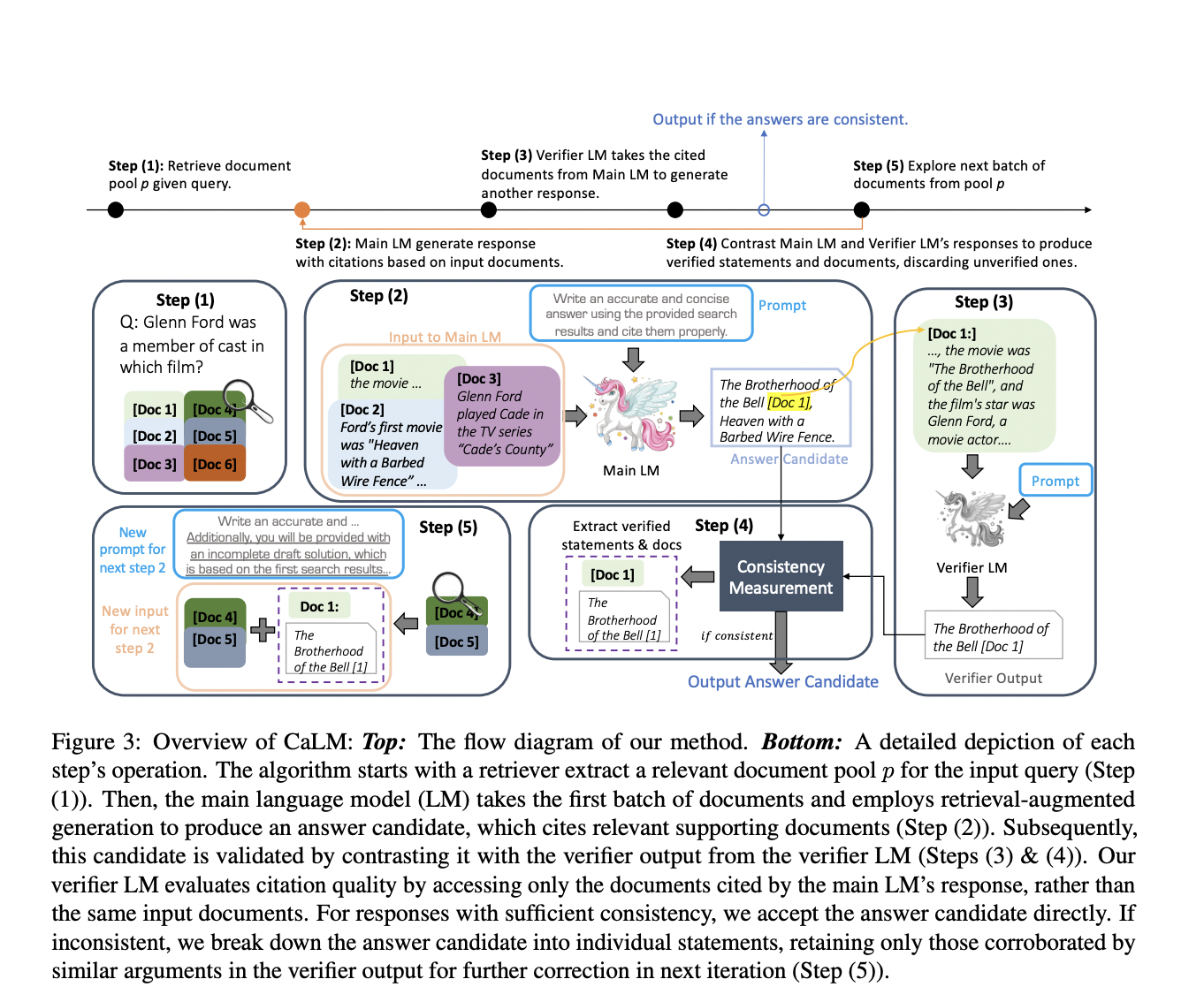

Предложенное решение, CaLM (Contrasting Large and Small Language Models), использует дополняющие силы больших и маленьких LLM. CaLM применяет пост-проверочный подход, где меньший LLM проверяет выводы большего LLM. Меньший LLM анализирует цитируемые документы для подтверждения точности цитирования большего LLM. Если ответы совпадают, ответ большего LLM подтверждается; CaLM итеративно улучшает ответ с помощью обратной связи, если обнаружены расхождения. Этот метод улучшает возможности обоснованной генерации больших LLM без необходимости тонкой настройки модели.

Процесс проверки CaLM включает использование меньшего LLM для кросс-ссылки вывода большего LLM с цитируемыми документами. Меньший LLM, который меньше полагается на параметрическую память и отлично обрабатывает соответствующую информацию, оценивает, соответствует ли ответ большего LLM информации из цитируемых источников. Этот метод использует чувствительность меньшего LLM к входной релевантности, обеспечивая выявление и исправление любых несоответствий. Итеративная обратная связь позволяет непрерывно улучшать ответ, значительно повышая точность цитирования и общее качество ответа.

Эксперименты, проведенные на трех наборах данных по открытому вопросно-ответному поиску (QAMPARI, ASQA и ELI5), продемонстрировали значительное улучшение производительности с использованием CaLM. Метод улучшил точность ответов и качество цитирования, превзойдя современные методы на 1,5% до 7% в среднем. Фреймворк оказался устойчивым даже в сложных сценариях с менее мощными системами информационного поиска, подчеркивая его эффективность в улучшении возможностей обоснованной генерации LLM.

Фреймворк CaLM эффективно решает проблему обеспечения точных и проверяемых ответов от LLM, используя сильные стороны как больших, так и маленьких языковых моделей. Путем применения пост-проверочного подхода и итеративного улучшения CaLM значительно повышает качество и надежность выводов LLM, что делает его ценным достижением в области исследования языковых моделей. Полученные результаты указывают на то, что хотя LLM предлагают значительное улучшение производительности, их поведение масштабирования является сложным и зависит от задачи. Данное исследование способствует лучшему пониманию возможностей и ограничений больших языковых моделей, что критически важно для их эффективного применения в реальных приложениях.

Подробнее о статье можно узнать здесь. Вся заслуга за это исследование принадлежит его авторам. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наш новостной бюллетень.

Не забудьте присоединиться к нашему 45k+ ML SubReddit.

Источник: MarkTechPost.

Применение ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте CaLM: Bridging Large and Small Language Models for Credible Information Generation.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`