Оптимизатор Muon значительно ускоряет процесс grokking в трансформерах

Возвращение к проблеме grokking

В последние годы явление grokking, при котором модели показывают задержанный, но внезапный переход от запоминания к обобщению, привлекло renewed внимание к динамике обучения. Исходно наблюдаемое в малых алгоритмических задачах, таких как модульная арифметика, grokking показывает, что модели могут достигать почти идеальной точности на обучающих данных, в то время как производительность на валидационных данных остается низкой в течение длительного времени. В конечном итоге, и часто внезапно, модель начинает обобщать. Понимание факторов, влияющих на этот переход, важно не только для интерпретации, но и для оптимизации эффективности обучения глубоких сетей. Ранее исследователи подчеркивали роль регуляризации и убыли весов. Однако конкретное влияние оптимизаторов на этот процесс было недостаточно изучено.

Исследование влияния оптимизаторов на grokking

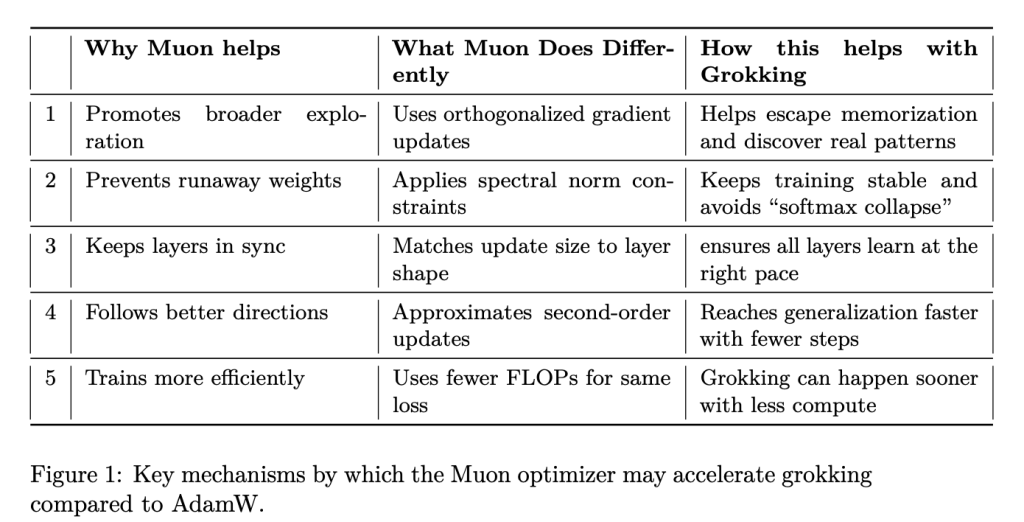

В данной статье от Microsoft рассматривается влияние выбора оптимизатора на поведение grokking. В частности, сопоставляется производительность широко используемого оптимизатора AdamW с Muon, новым алгоритмом оптимизации, который включает ограничения спектральной нормы и информацию второго порядка. Исследование выясняет, позволяют ли эти функции Muon ускорить фазу обобщения.

Архитектура и дизайн оптимизации

Основная архитектура модели использует стандартные компоненты трансформера, реализованные в PyTorch. Она включает многоголовое самовнимание, ротарные позиционные эмбеддинги (RoPE), нормализацию RMS, активации SiLU и регуляризацию на основе dropout. Входные токены, состоящие из числовых значений или операторов, кодируются простыми идентификационными эмбеддингами.

Ключевое отличие заключается в поведении оптимизаторов:

- AdamW, базовый оптимизатор в современных потоках глубокого обучения, использует адаптивные темпы обучения с раздельным уменьшением весов.

- Muon, в отличие от AdamW, применяет ортогонализованные градиенты, накладывает ограничения спектральной нормы для стабилизации обучения и приближает кривизну второго порядка для более информативных обновлений.

Эмпирическая оценка и результаты

Эмпирический протокол исследования тщательно продуман. Каждая комбинация оптимизатора, softmax и задачи оценивается по нескольким семенам для обеспечения статистической надежности. Grokking определяется как первый эпоха, когда валидационная точность превышает 95% после стабилизации точности обучения.

Результаты показывают последовательное и статистически значимое преимущество Muon. В среднем Muon достигает порога grokking за 102.89 эпох, в то время как для AdamW этот показатель составляет 153.09 эпох. Это различие не только численно значимо, но и статистически обосновано (t = 5.0175, p ≈ 6.33e−8).

Заключение

Результаты предоставляют убедительные доказательства того, что геометрия оптимизатора значительно влияет на появление обобщения в переобученных моделях. Направляя путь оптимизации через обновления с учетом второго порядка и ограничения спектральной нормы, Muon способствует более прямому пути к обнаружению структуры данных, обходя длительные фазы переобучения.

Практические рекомендации для бизнеса

Ищите процессы, которые можно автоматизировать, и определяйте моменты взаимодействия с клиентами, где искусственный интеллект может добавить наибольшую ценность. Выберите инструменты, которые соответствуют вашим требованиям и позволяют настраивать их под ваши цели.

Начните с небольшого проекта, собирайте данные о его эффективности и постепенно расширяйте использование ИИ в вашей работе. Если вам требуется помощь в управлении ИИ в бизнесе, свяжитесь с нами по адресу hello@itinai.ru.

Подпишитесь на наш Telegram, чтобы быть в курсе последних новостей ИИ.

Посмотрите практический пример решения на основе ИИ: продажный бот, предназначенный для автоматизации диалогов с клиентами круглосуточно и управления взаимодействием на всех этапах клиентского пути.