Введение в FFN Fusion

Исследователи NVIDIA представили FFN Fusion — новую технику оптимизации, которая демонстрирует, как последовательные вычисления в больших языковых моделях (LLMs) могут быть эффективно параллелизированы.

Проблема эффективности в LLMs

Большие языковые модели стали важными инструментами в различных областях, обеспечивая высокопроизводительные приложения, такие как генерация естественного языка и разговорные агенты. Однако с увеличением размера и сложности моделей возрастает вычислительная нагрузка, что создает узкие места в эффективности. Устранение этих узких мест стало критически важной задачей.

Технические трудности

Последовательная структура трансформеров требует строгого порядка и синхронизации, что усложняет масштабирование. Увеличение размера моделей приводит к росту затрат на вычисления и коммуникацию, что снижает общую эффективность.

Решения для повышения эффективности

Существуют различные техники, такие как квантование и обрезка, которые помогают улучшить эффективность, но каждая из них имеет свои недостатки. Поэтому необходимо искать методы, которые обеспечивают широкие улучшения без значительных компромиссов.

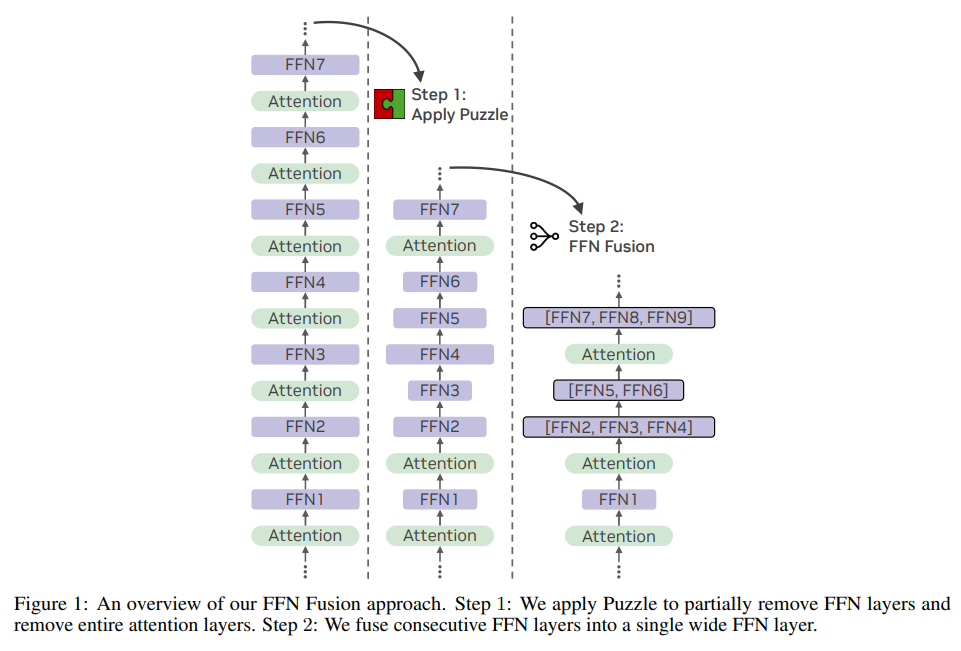

Техника FFN Fusion

FFN Fusion решает проблему последовательных вычислений, идентифицируя последовательности FFN, которые могут быть выполнены параллельно. Это достигается путем объединения нескольких последовательных слоев FFN в один более широкий слой, что позволяет значительно повысить эффективность модели.

Результаты применения FFN Fusion

Применение FFN Fusion к модели Llama-405B привело к созданию Ultra-253B-Base, которая показала улучшение скорости и ресурсной эффективности. Модель достигла 1.71x улучшения латентности вывода и снизила затраты на вычисления на 35x при размере пакета 32.

Ключевые выводы

- FFN Fusion снижает последовательные вычисления в трансформерах за счет параллелизации слоев FFN с низкой зависимостью.

- Объединение достигается путем замены последовательностей FFN на один более широкий FFN.

- Ultra-253B-Base демонстрирует значительные улучшения в производительности и снижении затрат.

- Оптимизация использования памяти в два раза за счет улучшения kv-cache.

- FFN Fusion более эффективен на больших масштабах моделей.

Заключение

Техника FFN Fusion открывает новые возможности для проектирования более эффективных и масштабируемых LLM. Это исследование подчеркивает важность архитектурного переосмысления для достижения значительных улучшений в производительности.

Контактная информация

Если вам нужна помощь в управлении ИИ в бизнесе, свяжитесь с нами по адресу hello@itinai.ru. Подписывайтесь на наш Telegram для получения последних новостей об ИИ.

Практическое применение

Посмотрите пример решения на основе ИИ: бот для продаж от itinai.ru, который автоматизирует взаимодействие с клиентами и управляет процессами на всех этапах клиентского пути.