«`html

Инновационные подходы к развитию больших языковых моделей

Большие языковые модели (LLM) революционизировали обработку естественного языка, проявляя замечательные способности в различных приложениях. Однако эти модели сталкиваются с существенными вызовами, такими как ограничения времени их базы знаний, сложности с математическими вычислениями и склонность к производству неточной информации или «галлюцинаций». Эти ограничения побудили исследователей искать инновационные решения, способные улучшить производительность LLM без необходимости обширной переобучения. Интеграция LLM с внешними источниками данных и приложениями выделяется как многообещающий подход для решения этих вызовов, направленный на улучшение точности, актуальности и вычислительных возможностей, сохраняя при этом основные сильные стороны моделей в понимании и генерации языка.

Трансформаторная архитектура

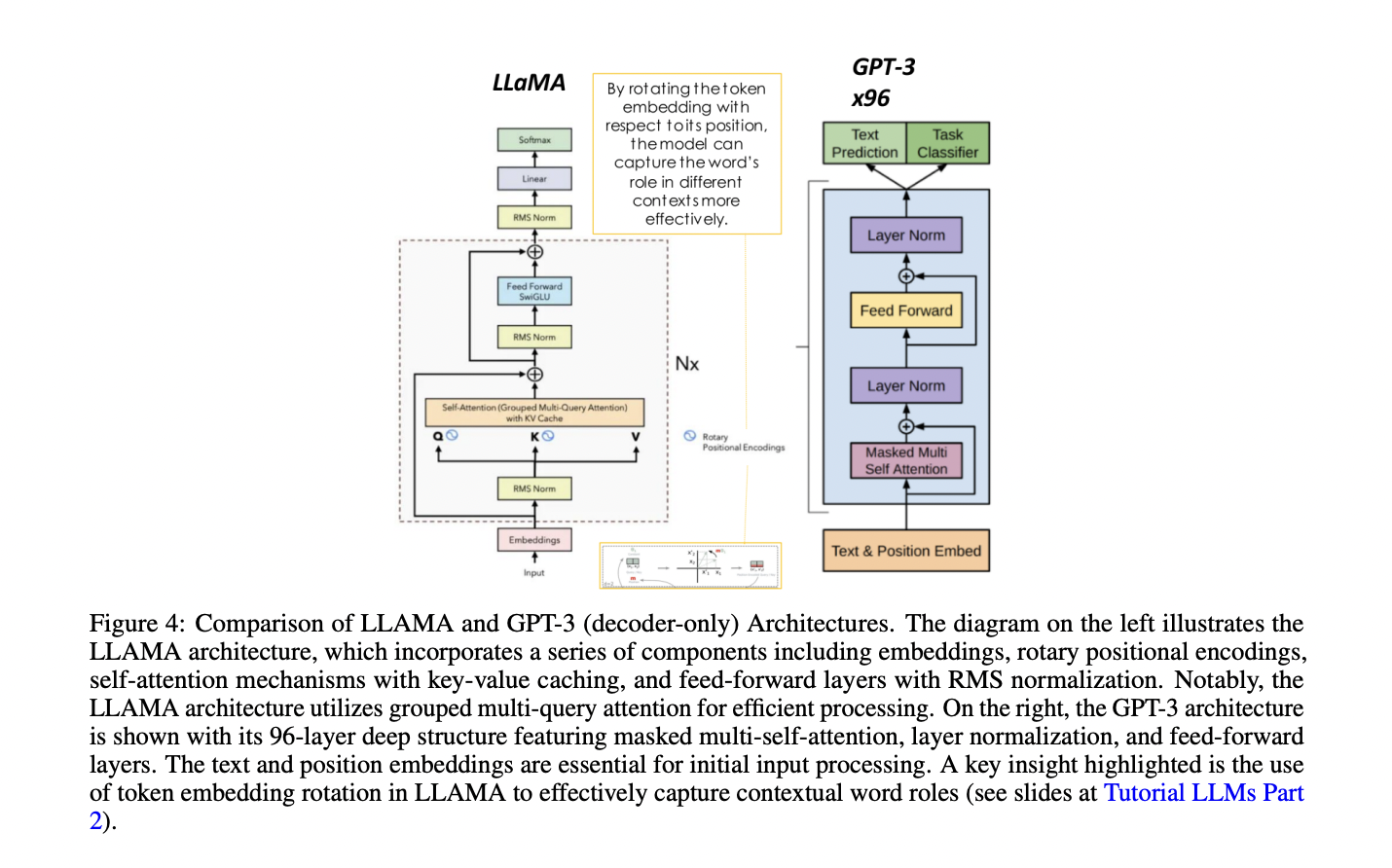

Архитектура трансформера стала значительным прорывом в обработке естественного языка, значительно превосходя более ранние рекуррентные нейронные сети. Ключ к этому успеху заключается в механизме самовнимания трансформера, который позволяет модели учитывать значимость каждого слова для каждого другого слова в предложении, захватывая сложные зависимости и контекстуальную информацию. Трансформеры состоят из компонентов кодировщика и декодировщика, каждый из которых включает в себя несколько слоев с механизмами самовнимания и нейронными сетями прямого распространения. Архитектура обрабатывает токенизированный ввод через встраивающие слои, применяет многоголовое самовнимание и включает позиционное кодирование для сохранения информации о порядке последовательности. Для конкретных задач были разработаны различные модели на основе трансформера, включая только кодировщиковые модели, такие как BERT для понимания текста, модели кодировщик-декодировщик, такие как BART и T5 для задач последовательности-последовательности, и только декодировщиковые модели, такие как семейство GPT для генерации текста. Недавние достижения сосредотачиваются на масштабировании этих моделей и разработке методов для эффективной донастройки, расширяя их применимость в различных областях.

Исследование и инновационные решения

Старший исследователь Георгио Роффо представляет всестороннее исследование вызовов, с которыми сталкиваются LLM, и инновационные решения для их решения. Исследователи представляют Retrieval Augmented Generation (RAG) как метод доступа к информации из внешних источников в реальном времени, улучшающий производительность LLM в различных приложениях. Они обсуждают интеграцию LLM с внешними приложениями для выполнения сложных задач и исследуют методы цепочечного стимулирования мышления для улучшения способностей рассуждения. В статье рассматриваются такие структуры, как Program-Aided Language Model (PAL), которые сочетают LLM с внешними интерпретаторами кода для точных вычислений, и исследуются достижения, такие как ReAct и LangChain для решения сложных проблем. Исследователи также обсуждают архитектурные компоненты для разработки приложений на основе LLM, охватывая инфраструктуру, развертывание и интеграцию внешних источников информации. Статья предоставляет представления о различных моделях на основе трансформера, методиках масштабирования обучения моделей и стратегиях донастройки для улучшения производительности LLM для конкретных случаев использования.

Современные подходы к обучению LLM

Текущие достижения в обучении LLM сосредотачиваются на эффективном масштабировании на нескольких графических процессорах. Техники, такие как Distributed Data Parallel (DDP) и Fully Sharded Data Parallel (FSDP), распределяют вычисления и компоненты модели по графическим процессорам, оптимизируя использование памяти и скорость обучения. FSDP, вдохновленный фреймворком ZeRO (Zero Redundancy Optimizer), вводит три этапа оптимизации для расщепления состояний модели, градиентов и параметров. Эти методы позволяют обучать более крупные модели и ускоряют процесс для более маленьких. Кроме того, разработка 1-битных LLM, таких как BitNet b1.58, предлагает значительные улучшения в эффективности памяти, скорости вывода и энергопотреблении, сохраняя производительность, сравнимую с традиционными 16-битными моделями.

Методы донастройки улучшают производительность больших языковых моделей для конкретных задач. Инструкционная донастройка использует пары завершения запроса для обновления весов модели, улучшая задачно-специфические ответы. Многозадачная донастройка смягчает катастрофическое забывание путем одновременного обучения на нескольких задачах. Методы PEFT, такие как Low-Rank Adaptation (LoRA) и prompt tuning, снижают вычислительные затраты, сохраняя производительность. LoRA вводит матрицы низкорангового разложения, а prompt tuning добавляет обучаемые мягкие подсказки. Эти методы значительно сокращают количество обучаемых параметров, делая донастройку более доступной и эффективной. Будущие исследования направлены на оптимизацию баланса между эффективностью параметров и производительностью модели, исследуя гибридные подходы и адаптивные методы PEFT.

Обучение с подкреплением от обратной связи человека (RLHF) и усиленное самообучение (ReST) — это передовые техники для согласования больших языковых моделей с предпочтениями человека. RLHF использует обратную связь человека для обучения модели вознаграждения, которая направляет оптимизацию политики языковой модели через алгоритмы обучения с подкреплением, такие как Proximal Policy Optimization (PPO). ReST вводит двухуровневую структуру: шаг Grow, генерирующий выходные прогнозы, и шаг Improve, фильтрующий и донастраивающий этот набор данных с использованием оффлайн RL. RLHF предлагает прямое согласование, но сталкивается с высокими вычислительными затратами и потенциальным взломом вознаграждения. ReST обеспечивает эффективность и стабильность, разъединяя генерацию данных и улучшение политики. Обе методики значительно улучшают производительность модели, причем ReST показывает особую перспективу в масштабных приложениях. Будущие исследования могут исследовать гибридные подходы, объединяющие их преимущества.

Этот учебный материал предоставляет всесторонний обзор последних достижений в области LLM и рассматривает их врожденные ограничения. Он представляет инновационные техники, такие как RAG для доступа к текущей внешней информации, PAL для точных вычислений и LangChain для эффективной интеграции с внешними источниками данных. В статье рассматриваются стратегии донастройки, включая инструкционную донастройку и параметрически эффективные методы, такие как LoRA и prompt tuning. Также обсуждаются методы согласования, такие как RLHF и ReST. Кроме того, статья охватывает архитектуры трансформера, техники масштабирования обучения моделей и практические применения. Эти достижения в целом направлены на улучшение производительности, надежности и применимости LLM в различных областях, устраивая путь для более сложных и контекстуально значимых взаимодействий с ИИ.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашей группе в LinkedIn. Если вам нравится наша работа, вам понравится наш бюллетень.

Не забудьте присоединиться к нашему 46k+ ML SubReddit

Найдите предстоящие вебинары по ИИ здесь

Опубликовано на MarkTechPost.

Применение ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте From RAG to ReST: A Survey of Advanced Techniques in Large Language Model Development.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`