«`html

Оценка эффективности сжатия больших языковых моделей (LLM) с помощью метрик расстояния

Оценка эффективности методов сжатия LLM является ключевым вызовом в области искусственного интеллекта (ИИ). Методы сжатия, такие как квантование, направлены на оптимизацию эффективности LLM путем снижения вычислительных затрат и задержек. Однако традиционные методы оценки сосредоточены в основном на метриках точности, которые не улавливают изменения в поведении модели, такие как явление «переворотов», когда правильные ответы становятся неправильными и наоборот. Этот вызов имеет значительное значение, поскольку он влияет на надежность и последовательность сжатых моделей в различных критических приложениях, включая медицинскую диагностику и автономное вождение.

Текущие методы оценки техник сжатия LLM

Текущие методы оценки техник сжатия LLM сильно полагаются на метрики точности с бенчмарк-задач, таких как MMLU, Hellaswag и ARC. Однако этот подход не учитывает возникновение переворотов, когда сжатые модели могут давать разные ответы, несмотря на сходные уровни точности. Это может привести к искаженному восприятию надежности модели. Кроме того, метрики точности в одиночку не учитывают качественные различия в поведении модели, особенно в задачах, связанных с генеративными ответами, где нюансы генерации языка имеют важное значение.

Новый подход к оценке техник сжатия LLM

Исследователи из Microsoft Research, Индия, предлагают новый подход к оценке техник сжатия LLM путем введения метрик расстояния, таких как KL-дивергенция и процент переворотов, в дополнение к традиционным метрикам точности. Этот подход обеспечивает более всестороннюю оценку того, насколько близко сжатые модели имитируют свои базовые аналоги. Основное новшество заключается в выявлении и количественной оценке переворотов, которые служат интуитивной и легко интерпретируемой метрикой расхождения модели. Сосредоточившись на качественных и количественных аспектах производительности модели, этот подход обеспечивает сохранение высоких стандартов надежности и применимости сжатых моделей в различных задачах.

Эксперименты и результаты

Исследование включает эксперименты с использованием нескольких LLM (например, моделей Llama2 и Yi chat) и различных техник квантования (например, LLM.int8, GPTQ, AWQ). Исследователи оценивают эти техники на нескольких задачах, включая MMLU, ARC, PIQA, Winogrande, Hellaswag и Lambada. Метрики оценки включают точность, перплексию, перевороты и KL-дивергенцию. Особенно следует отметить, что метрика переворотов измеряет процент ответов, которые меняются с правильных на неправильные и наоборот между базовыми и сжатыми моделями. Характеристики набора данных и стратегии настройки гиперпараметров для каждой модели тщательно описаны, обеспечивая надежную экспериментальную установку.

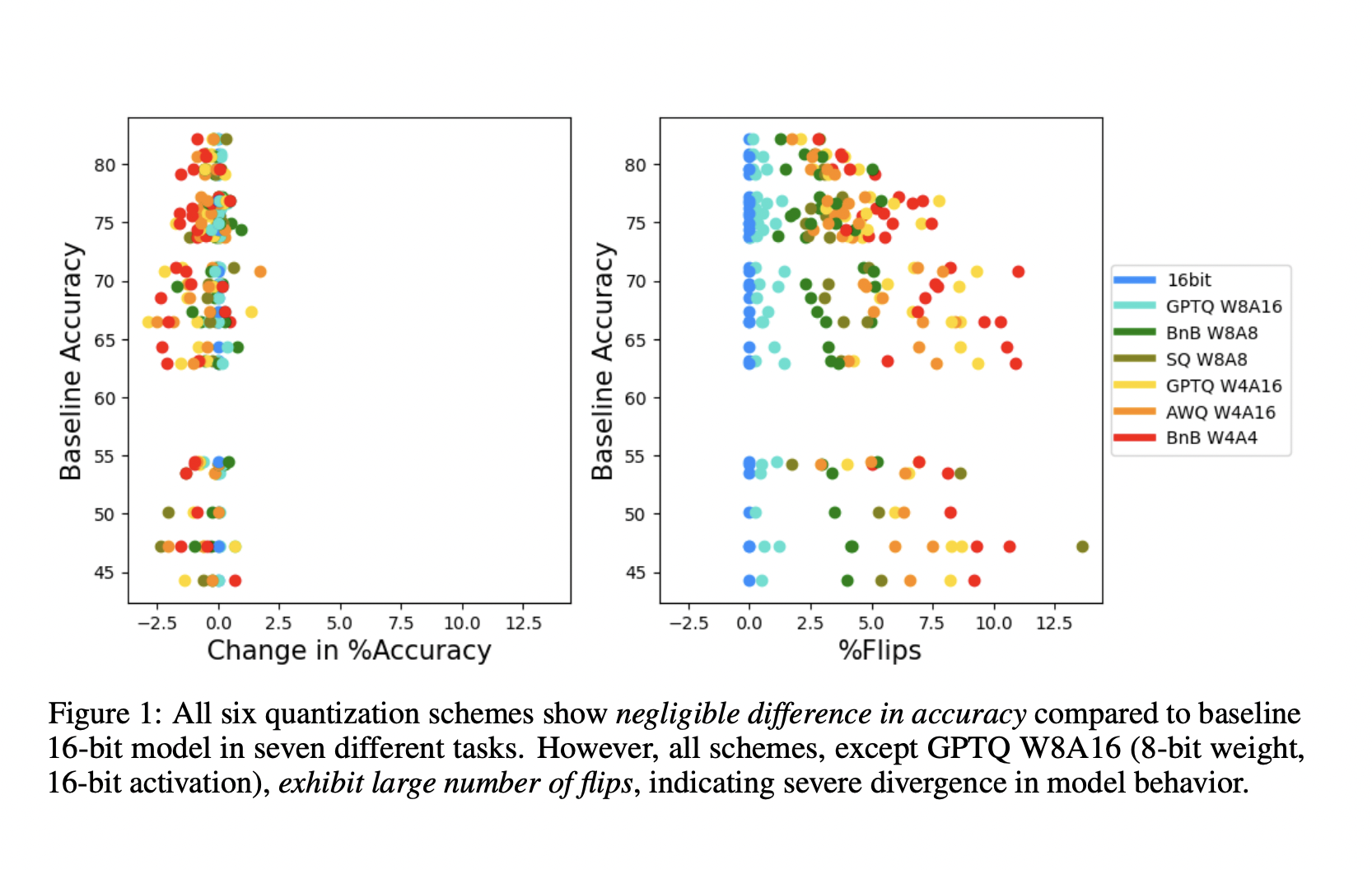

Выводы показывают, что хотя различия в точности между базовыми и сжатыми моделями часто незначительны (≤2%), процент переворотов может быть значительным (≥5%), указывая на значительное расхождение в поведении модели. Например, в задаче MMLU схема квантования GPTQ W8A16 достигает точности 63,17% при всего 0,26% уровне переворотов, демонстрируя высокую достоверность по сравнению с базовой моделью. В отличие от этого, другие схемы квантования показывают значительные отклонения, с уровнями переворотов до 13,6%. Исследование также показывает, что более крупные модели обычно имеют меньше переворотов, чем более маленькие, указывая на большую устойчивость к сжатию. Кроме того, качественная оценка с использованием MT-Bench показывает, что модели с более высокими уровнями переворотов показывают более плохие результаты в генеративных задачах, что дополнительно подтверждает эффективность предложенных метрик в улавливании тонких изменений производительности.

Выводы

Предложенный метод вносит значительный вклад в исследования в области ИИ, предлагая более всестороннюю систему оценки техник сжатия LLM. Он выявляет ограничения, связанные с полаганием только на метрики точности, и вводит метрики переворотов и KL-дивергенции для более точного улавливания расхождения модели. Этот подход обеспечивает сохранение высокой надежности и применимости сжатых моделей, продвигая область ИИ путем решения критического вызова в оценке моделей.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter.

Присоединяйтесь к нашему Телеграм-каналу и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сабреддиту с более чем 46 тысячами подписчиков.

Статья опубликована на портале MarkTechPost.

Применение ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте методику «Beyond Accuracy: Evaluating LLM Compression with Distance Metrics».

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь, какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram. Следите за новостями о ИИ в нашем Телеграм-канале или в Twitter.

Попробуйте AI Sales Bot AI Sales Bot. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab AI Lab. Будущее уже здесь!

«`