«`html

Введение в Vision Transformers (ViTs)

Vision Transformers (ViTs) изменили подход к компьютерному зрению, предлагая новую архитектуру, которая использует механизмы самовнимания для обработки изображений. В отличие от свёрточных нейронных сетей (CNN), которые используют свёрточные слои, ViTs делят изображения на небольшие участки и рассматривают их как отдельные токены. Это позволяет эффективно обрабатывать большие наборы данных, что делает ViTs особенно эффективными для задач классификации изображений и обнаружения объектов.

Преимущества ViTs

- Гибкость в обработке информации.

- Эффективность в высокоразмерных задачах.

Проблема предобучения ViTs

Существует вопрос о необходимости предобучения для ViTs. Ранее считалось, что предобучение улучшает производительность, обучая полезные представления признаков. Однако исследователи начали сомневаться, действительно ли это единственный фактор, влияющий на улучшение производительности.

Методы использования предобученных ViTs

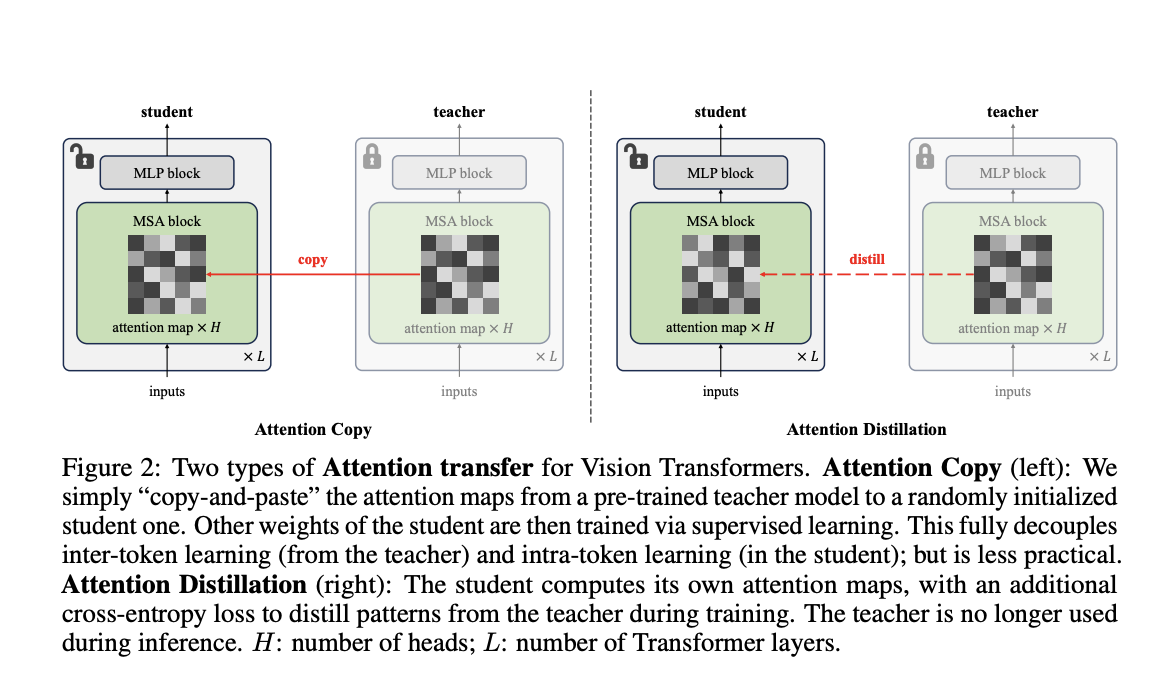

Традиционные подходы к использованию предобученных ViTs включают дообучение всей модели на конкретных задачах. Это затрудняет выделение вклада каждого элемента. Исследователи из Carnegie Mellon University и FAIR предложили новый метод под названием “Attention Transfer”, который изолирует и передает только паттерны внимания от предобученных ViTs.

Методы Attention Transfer

- Attention Copy: передает карты внимания от учителя к модели-ученику.

- Attention Distillation: использует функцию потерь для обучения модели-ученика, чтобы ее карты внимания соответствовали картам учителя.

Преимущества методов

Оба метода позволяют сосредоточиться на механизмах внимания, что открывает новые возможности для оптимизации использования ViTs в компьютерном зрении.

Результаты и выводы

Методы продемонстрировали эффективность паттернов внимания. Attention Distillation достигла точности 85.7% на наборе данных ImageNet-1K, что сопоставимо с полностью дообученными моделями. Attention Copy показала 85.1% точности, что также является хорошим результатом.

Будущее и возможности

Исследование показывает, что предобученные паттерны внимания могут быть достаточными для достижения высокой производительности. Это открывает новые пути для оптимизации использования ViTs в различных областях.

Как использовать ИИ в вашей компании

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Анализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее решение из множества доступных вариантов ИИ.

- Внедряйте ИИ постепенно, начиная с небольших проектов.

Получите помощь

Если вам нужны советы по внедрению ИИ, пишите нам в Telegram. Следите за новостями о ИИ в нашем Telegram-канале или в Twitter.

Попробуйте AI Sales Bot

Этот AI ассистент в продажах помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте больше

Изучите, как ИИ может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

«`