Проблемы традиционных архитектур MoE

Большие языковые модели сделали значительные шаги в понимании искусственного интеллекта, однако эффективное масштабирование этих моделей остается проблемой. Традиционные архитектуры Mixture-of-Experts (MoE) активируют лишь подмножество экспертов для каждой токена, чтобы сократить вычислительные затраты. Однако это приводит к двум заметным проблемам. Во-первых, эксперты обрабатывают токены изолированно, что ограничивает их способность использовать различные перспективы при обработке. Во-вторых, хотя архитектуры MoE используют разреженный активационный паттерн, они все равно требуют значительных объемов памяти из-за высокого общего числа параметров. Эти проблемы указывают на то, что хотя модели MoE и являются шагом вперед в масштабируемости, их внутренний дизайн может ограничивать производительность и эффективность использования ресурсов.

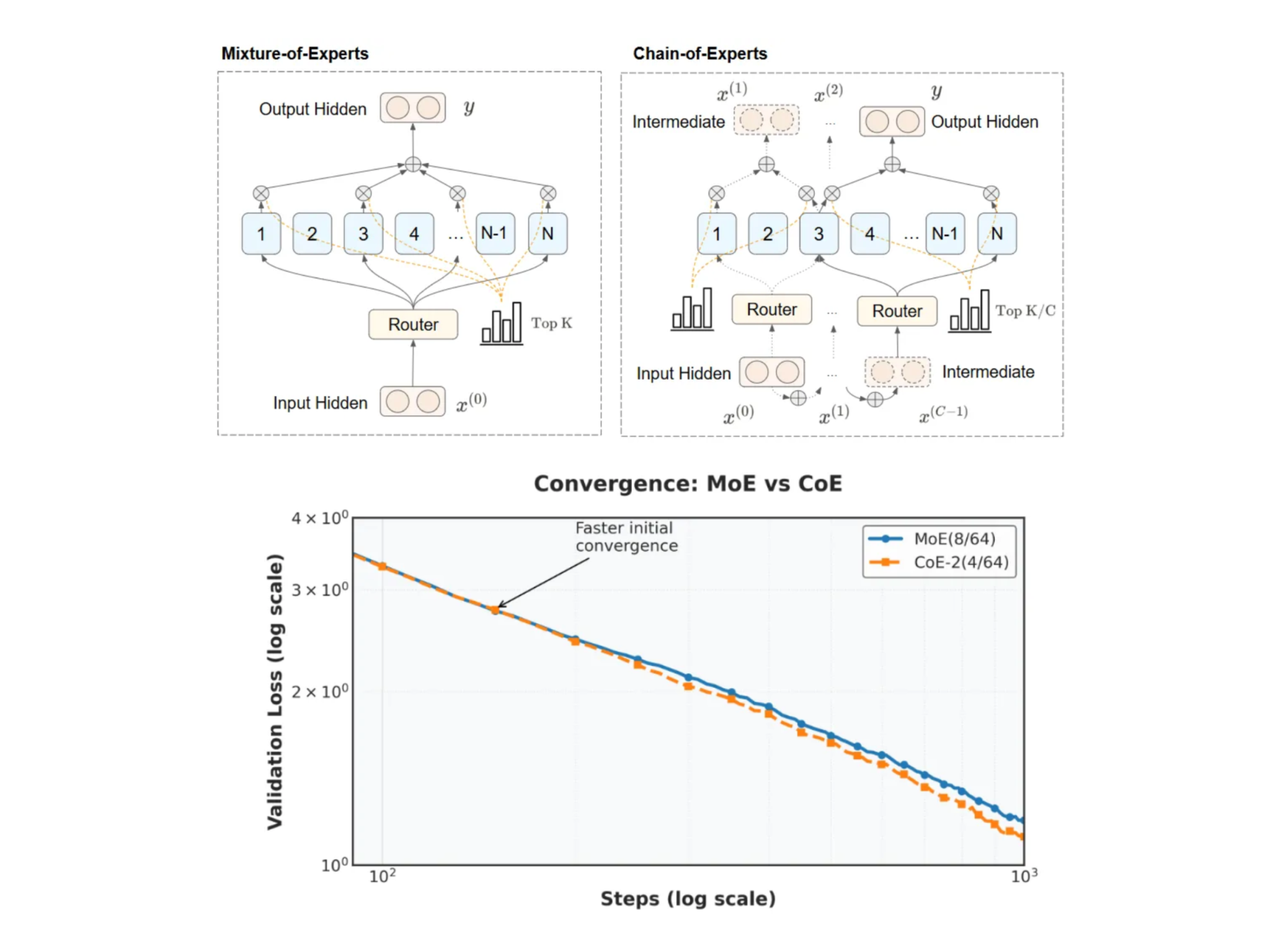

Подход Chain-of-Experts (CoE)

Chain-of-Experts (CoE) предлагает переосмысление архитектур MoE, вводя механизм последовательной коммуникации между экспертами. В отличие от независимой обработки в традиционных моделях MoE, CoE позволяет токенам обрабатываться через серию итераций в каждом слое. Выход одного эксперта становится входом для следующего, создавая цепочку общения, которая позволяет экспертам опираться на работу друг друга. Это взаимодействие не просто накладывает слои; оно способствует более интегрированному подходу к обработке токенов, где каждый эксперт уточняет интерпретацию токена на основе предыдущих выходов. В результате модель использует совместный потенциал своих экспертов, стремясь более эффективно использовать память.

Технические детали и преимущества

В центре метода CoE лежит итеративный процесс, который переопределяет, как взаимодействуют эксперты. Например, конфигурация CoE-2(4/64) работает с двумя итерациями на токен, с выбором четырех экспертов из пула из 64 доступных экспертов на каждом цикле. Это отличается от традиционных настроек MoE, которые полагаются на одну проходку через заранее выбранную группу экспертов.

Ключевым техническим элементом CoE является независимый механизм управления. В традиционных моделях MoE функция управления выбирает, какие эксперты должны обработать токен, но эти решения принимаются один раз на токен для каждого слоя. CoE расширяет эту идею, позволяя каждому эксперту принимать решения о управлении независимо в каждой итерации. Эта гибкость способствует специализации, где эксперт может настраивать свою обработку на основе информации, полученной из предыдущих итераций.

Кроме того, использование внутренних остаточных соединений в CoE улучшает модель. Вместо того чтобы просто добавлять оригинальный токен обратно после всей последовательности обработки, CoE интегрирует остаточные соединения в каждую итерацию. Этот дизайн помогает сохранить целостность информации токена, позволяя при этом постепенно улучшать данные на каждом этапе.

Экспериментальные результаты и выводы

Эмпирические исследования подтверждают потенциал метода Chain-of-Experts. В контролируемых экспериментах, таких как предварительное обучение на математических задачах, конфигурации CoE-2(4/64) продемонстрировали снижение потерь при валидации (с 1.20 до 1.12) по сравнению с традиционными моделями MoE при тех же вычислительных условиях. Это улучшение достигается без увеличения общего объема памяти или вычислительных затрат, так как последовательная коммуникация позволяет более эффективно использовать емкость каждого эксперта.

Дополнительные оценки показали, что увеличение числа итераций в CoE может принести выгоды, сопоставимые или даже превышающие те, которые достигаются при увеличении числа выбранных экспертов за один проход. Например, даже при постоянстве бюджета памяти и вычислений, конфигурации CoE показывают до 18% сокращения использования памяти при достижении аналогичных или лучших результатов.

Более того, последовательный дизайн CoE открывает существенно большее количество комбинаций экспертов — до 823 раз больше, чем традиционные методы. Это резкое увеличение возможных путей экспертов означает, что модель имеет более широкий набор опций при обработке каждого токена, что потенциально приводит к более надежным и специализированным выходным данным.

Заключение

Рамки Chain-of-Experts представляют собой взвешенную эволюцию в дизайне разреженных нейронных сетей. Вводя последовательную коммуникацию между экспертами, CoE решает ограничения независимой обработки токенов и высокой нагрузки на память, присущие традиционным моделям MoE. Технические новшества — особенно независимый механизм управления и внутренние остаточные соединения — позволяют более эффективный и гибкий подход к масштабированию больших языковых моделей.

Экспериментальные результаты, хотя и предварительные, предполагают, что CoE может достичь скромных, но значительных улучшений в производительности и использовании ресурсов. Этот подход приглашает к дальнейшему исследованию, особенно в том, как итеративная коммуникация может быть расширена или уточнена в будущих архитектурах моделей. По мере продолжения исследований в этой области, CoE становится вдумчивым шагом к достижению баланса между вычислительной эффективностью и производительностью модели, что в конечном итоге может способствовать более доступным и устойчивым системам ИИ.

Посмотрите на практический пример решения на базе ИИ: торговый бот, разработанный для автоматизации общения с клиентами круглосуточно и управления взаимодействиями на всех этапах пути клиента.

«`