«`html

Улучшение надежности LLM: обнаружение конфабуляций семантической энтропией

LLM, такие как ChatGPT и Gemini, обладают впечатляющими способностями к рассуждению и ответам, но часто производят «галлюцинации», то есть генерируют ложную или не подтвержденную информацию. Это затрудняет их надежность в критических областях, от права до медицины, где неточности могут иметь серьезные последствия. Усилия по уменьшению этих ошибок через наблюдение или укрепление имели ограниченный успех. Подмножество галлюцинаций, называемых «конфабуляциями», включает в себя LLM, давая произвольные или неправильные ответы на одинаковые запросы, такие как различные ответы на медицинский вопрос о Sotorasib. Понимание и решение этих тонких типов ошибок критично для улучшения надежности LLM.

Практическое применение:

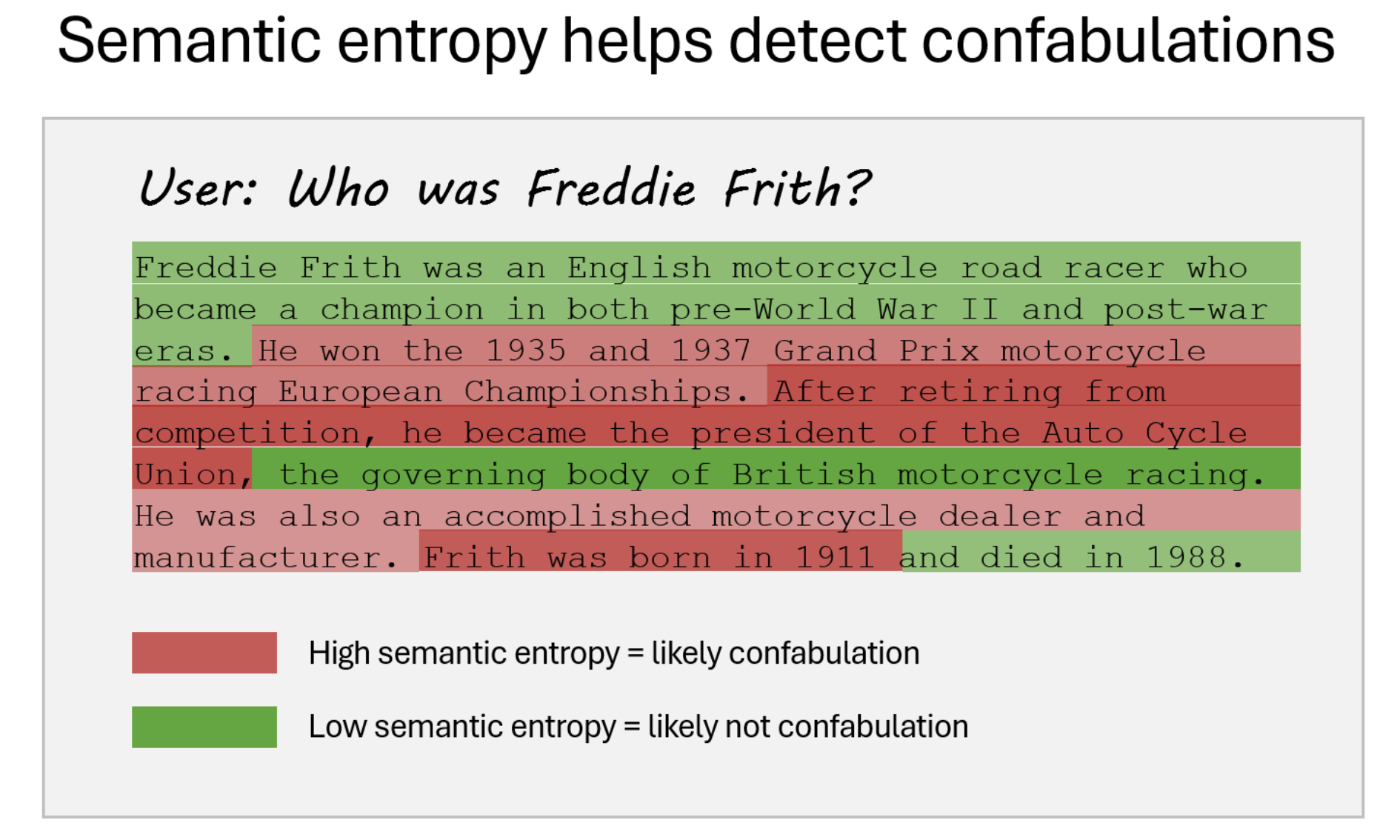

Исследователи из группы OATML Университета Оксфорда разработали статистический подход для обнаружения конфабуляций в LLM, известных как «конфабуляции». Эти ошибки возникают, когда LLM генерируют произвольные и неправильные ответы, часто из-за тонких вариаций во входных данных или случайного семени. Новый метод использует оценщики неопределенности на основе энтропии, фокусируясь на значении, а не на точной формулировке ответов. Оценивая «семантическую энтропию» — неопределенность в смысле сгенерированных ответов — эта техника может идентифицировать, когда LLM склонны производить ненадежные результаты. Этот метод не требует знания конкретной задачи или размеченных данных и эффективен в различных наборах данных и приложениях. Он улучшает надежность LLM, сигнализируя о необходимости дополнительной осторожности, позволяя пользователям избегать или критически оценивать потенциально конфабулированные ответы.

Значение:

Метод исследователей работает путем кластеризации похожих ответов на основе их значения и измерения энтропии в этих кластерах. Если энтропия высока, LLM скорее всего генерирует конфабулированные ответы. Этот процесс улучшает обнаружение семантических несоответствий, которые наивные меры энтропии, учитывающие только лексические различия, могут упустить. Техника была протестирована на различных LLM в различных областях, таких как викторины, общие знания и медицинские запросы, что продемонстрировало значительное улучшение в обнаружении и фильтрации ненадежных ответов. Более того, отказываясь отвечать на вопросы, склонные к высокой энтропии (конфабулированные), метод может улучшить общую точность выводов LLM. Это новшество представляет собой критический прогресс в обеспечении надежности LLM, особенно в генерации свободного текста, где традиционные методы обучения с учителем оказываются неэффективными.

Практическое применение:

Семантическая энтропия — это метод обнаружения конфабуляций в LLM путем измерения их неопределенности по поводу значения сгенерированных выводов. Эта техника использует предсказательную энтропию и кластеризует сгенерированные последовательности по семантическому эквиваленту с использованием двунаправленного следования. Она вычисляет семантическую энтропию на основе вероятностей этих кластеров, указывая на уверенность модели в своих ответах. Путем выборки выводов и их кластеризации семантическая энтропия идентифицирует моменты, когда ответы модели скорее всего произвольны. Этот подход помогает предсказывать точность модели, улучшает надежность, сигнализируя о неопределенных ответах, и предоставляет пользователям лучшую оценку уверенности в выводах модели.

Значение:

Исследование фокусируется на выявлении и уменьшении конфабуляций — ошибочных или вводящих в заблуждение выводов — генерируемых LLM с использованием метрики «семантическая энтропия». Эта метрика оценивает изменчивость значения в различных генерациях выводов модели, отличаясь от традиционных мер энтропии, учитывающих только лексические различия. Исследование показывает, что семантическая энтропия, учитывающая согласованное значение несмотря на разнообразные формулировки, эффективно обнаруживает, когда LLM производят неправильные или вводящие в заблуждение ответы. Семантическая энтропия превзошла базовые методы, такие как наивная энтропия и обученная регрессия встраивания, на различных наборах данных и размерах моделей, включая модели LLaMA, Falcon и Mistral, превзойдя базовые методы, такие как наивная энтропия и обученная регрессия встраивания, достигнув заметного AUROC 0,790. Это говорит о том, что семантическая энтропия предоставляет надежный механизм для выявления конфабуляций, даже при сдвигах распределения между обучением и развертыванием.

Значение:

Кроме того, исследование расширяет применение семантической энтропии к более длинным текстовым отрывкам, таким как биографические абзацы, разбивая их на фактические утверждения и оценивая согласованность этих утверждений через переформулировку. Этот подход показал, что семантическая энтропия может эффективно обнаруживать конфабуляции в расширенном тексте, превзойдя простые механизмы самопроверки и адаптируя вероятностные методы. Полученные результаты подразумевают, что LLM в своей сущности обладают способностью распознавать свои пробелы в знаниях, но традиционные методы оценки могут лишь частично использовать эту способность. Таким образом, семантическая энтропия предлагает многообещающее направление для улучшения надежности выводов LLM в сложных и открытых задачах, предоставляя способ оценки и управления неопределенностями в их ответах.

Проверьте статью, проект и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter.

Присоединяйтесь к нашему Телеграм-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему субреддиту с более чем 45 тысячами подписчиков.

Пост опубликован на сайте MarkTechPost.

«`