Раскрытие оптимизации трансформаторов: Объяснение на основе гессиана превосходства Adam над SGD

Практические решения и ценность:

Модели на основе больших языковых моделей (LLM) на архитектуре Transformer революционизировали разработку ИИ. Однако сложность процесса их обучения остается плохо понятной. Одной из значительных проблем в этой области является несогласованность производительности оптимизатора. В то время как оптимизатор Adam стал стандартом для обучения трансформаторов, стохастический градиентный спуск с импульсом (SGD), который эффективен для сверточных нейронных сетей (CNN), показывает худшие результаты на моделях Transformer. Решение этой загадки может улучшить теоретическое понимание обучения трансформаторов и нейронных сетей, что потенциально приведет к более эффективным методам обучения.

Существующие исследования включают несколько гипотез, объясняющих плохую производительность SGD на трансформаторах по сравнению с Adam. Одна из теорий предполагает, что SGD борется с тяжелым стохастическим шумом в языковых задачах. Усилия по пониманию эффективности Adam привели к анализу сходимости различных адаптивных методов градиента. Недавние исследования исследовали анализ спектра гессиана для MLP и CNN, выявляя характерные «основные» и «выбросные» паттерны. Трудности обучения трансформаторов были объяснены различными явлениями, включая расхождение логитов, дегенерацию ранга в слоях внимания, рост нормы параметров, чрезмерную зависимость от ветвей остатков и негативное влияние слойной нормализации.

Исследователи из Китайского университета Гонконга, Шэньчжэнь, Китай и Исследовательского института крупных данных Шэньчжэня объяснили разрыв в производительности между SGD и Adam при обучении трансформаторов. Их подход сосредоточен на анализе спектра гессиана этих моделей и концепции «блочной гетерогенности», которая относится к значительным отличиям в спектрах гессиана по различным блокам параметров в трансформаторах. Более того, предполагается, что эта гетерогенность является ключевым фактором в неэффективности SGD. Экспериментальные результаты на различных архитектурах нейронных сетей и квадратичных задачах показывают, что производительность SGD сравнима с производительностью Adam в задачах без блочной гетерогенности, но ухудшается при наличии гетерогенности.

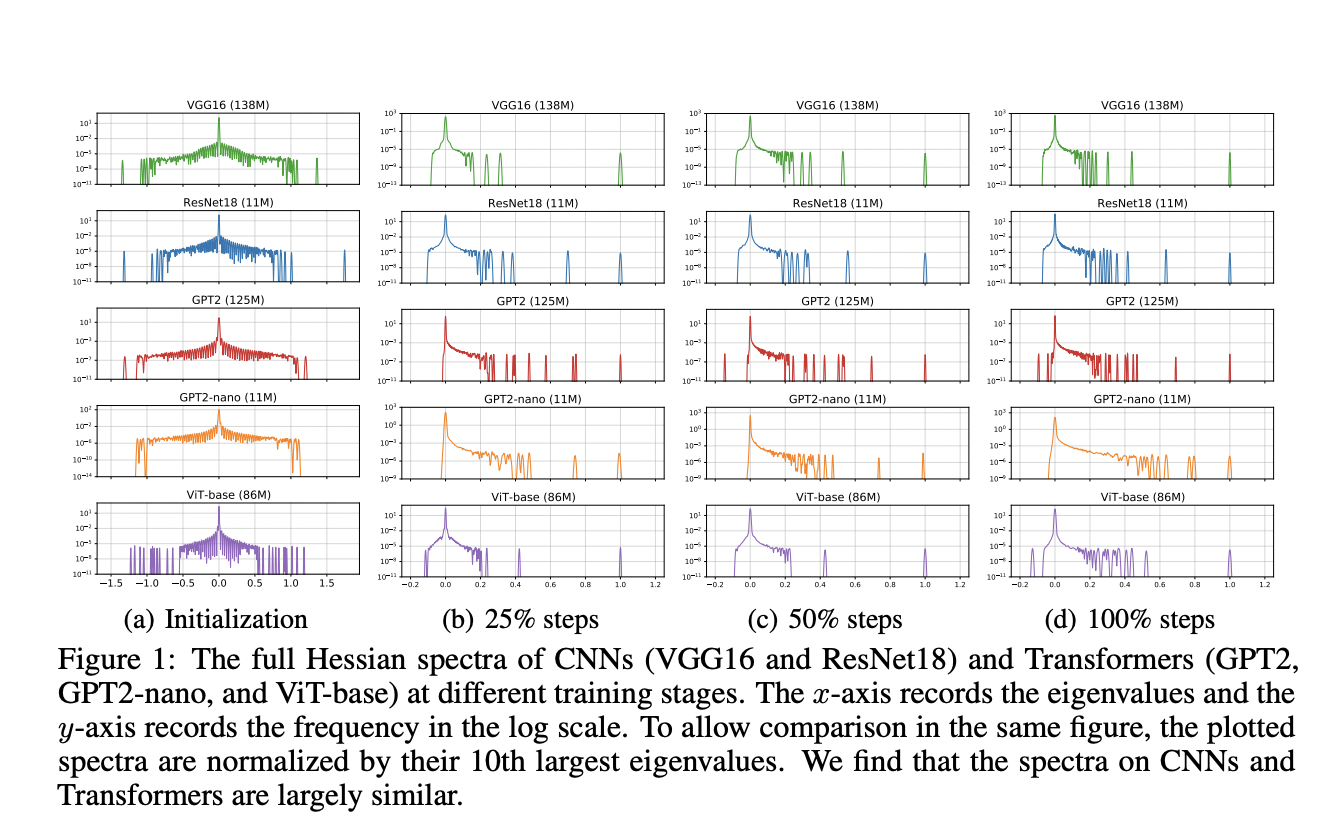

Предложенный метод использует метод стохастической квадратуры Ланцоша (SLQ) для приближенного определения спектра гессиана крупномасштабных нейронных сетей, которые иначе слишком сложно вычислить и хранить. SLQ приближает гистограммы собственных значений, используя гладкие кривые, и этот метод применяется для анализа различных моделей, включая CNN (ResNet18 и VGG16) и трансформаторы (GPT2, ViT-base, BERT и GPT2-nano) в различных задачах и модальностях. Для каждой модели оцениваются полный спектр гессиана и блочный спектр гессиана. Параметры блоков разделяются в соответствии с разделением по умолчанию в реализации PyTorch, таким как слой Embedding, Query, Key и Value в слоях внимания.

Результаты показывают контраст в спектрах гессиана между моделями трансформаторов и CNN. В трансформаторах, таких как BERT, спектры гессиана демонстрируют значительные отличия по разным блокам параметров, таким как встраивание, внимание и слои MLP. Это явление, названное «блочной гетерогенностью», последовательно наблюдается во всех исследуемых моделях трансформаторов. С другой стороны, CNN, такие как VGG16, показывают «блочную однородность», с похожими спектрами гессиана по сверточным слоям. Эти различия количественно оцениваются с помощью расстояния Йенсена-Шеннона между плотностями собственных значений пар блоков. Эта блочная гетерогенность в трансформаторах сильно коррелирует с разрывом в производительности между оптимизаторами SGD и Adam.

В данной статье исследователи исследовали основные причины неэффективности SGD по сравнению с Adam при обучении моделей трансформаторов. Введено понятие «блочной гетерогенности» в спектре гессиана, и установлена сильная корреляция между этим явлением и разрывом в производительности между Adam и SGD. Исследование предоставляет убедительные доказательства того, что «блочная гетерогенность», присутствующая в трансформаторах, но не в CNN, значительно влияет на производительность оптимизатора. Более того, производительность SGD не хороша в присутствии «блочной гетерогенности», в то время как Adam остается эффективным. Эта работа предлагает ключевые идеи о динамике оптимизации архитектур нейронных сетей и открывает путь к более эффективным алгоритмам обучения для трансформаторов и гетерогенных моделей.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему ML SubReddit.

Мы приглашаем стартапы, компании и исследовательские учреждения, работающие над малыми языковыми моделями, принять участие в предстоящем журнале/отчете «Малые языковые модели» от Marketchpost.com. Этот журнал/отчет будет выпущен в конце октября/начале ноября 2024 года. Нажмите здесь, чтобы назначить звонок!

Применение ИИ в вашем бизнесе:

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Unraveling Transformer Optimization: A Hessian-Based Explanation for Adam’s Superiority over SGD.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!