«`html

Реализация малых языковых моделей (SLM) с RAG на встроенных устройствах

В современном быстро развивающемся мире генеративного искусственного интеллекта deepsense.ai стремится установить новые решения, объединяя Advanced Retrieval-Augmented Generation (RAG) с Small Language Models (SLMs). SLM — это компактные версии языковых моделей с меньшим количеством параметров, предлагающие преимущества, такие как снижение затрат, улучшенная конфиденциальность данных и беспрепятственная автономная функциональность.

Что такое малые языковые модели?

Малые языковые модели (SLMs) — это более компактные версии больших языковых моделей. Они имеют меньше параметров, что делает их более легкими и быстрыми в процессе вывода.

Преимущества SLM на встроенных устройствах

Вот три убедительные причины, почему компании могут предпочесть применение малых языковых моделей (SLM) перед их облачными аналогами с большими языковыми моделями (LLM):

- Снижение затрат: перенос решений на основе LLM непосредственно на встроенные устройства устраняет необходимость облачного вывода, что приводит к значительной экономии затрат на масштабе.

- Автономная функциональность: развертывание SLM непосредственно на встроенных устройствах устраняет необходимость в доступе к интернету, что делает решения на основе SLM подходящими для сценариев с ограниченной интернет-связью.

- Конфиденциальность данных: вся обработка происходит локально на устройстве, что предоставляет возможность использовать решения на основе языковых моделей, соблюдая строгие протоколы защиты данных.

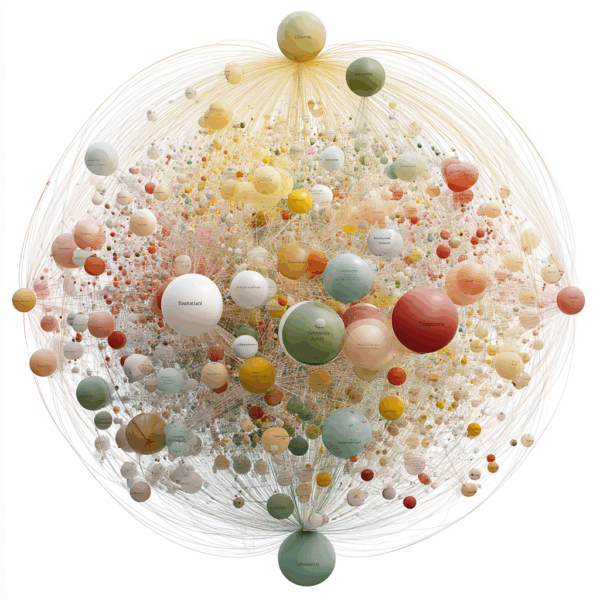

Разработка полной конвейерной системы RAG с SLM на мобильном телефоне

Основная цель этого внутреннего проекта заключалась в разработке полной конвейерной системы Retrieval-Augmented Generation (RAG), включающей модель встраивания, извлечение соответствующих фрагментов документов и модель вопросно-ответной системы, готовой к развертыванию на ресурсоемких устройствах Android. Мы провели эксперименты с SLM и оценили их производительность на различных устройствах, что позволило выявить потенциал практического применения SLM на встроенных устройствах.

Проблемы и текущие исследования

Мы выявили ключевые проблемы, такие как ограничения по памяти и независимость от платформы, которые влияют на реализацию SLM с RAG на встроенных устройствах. Текущие исследования направлены на преодоление текущих ограничений SLM и дальнейшее улучшение их производительности и эффективности.

Заключение

Хотя возможно запускать SLM на встроенных устройствах и получать удовлетворительные результаты для приложений, таких как RAG, как в терминах скорости, так и качества, необходимо учитывать некоторые важные ограничения. Мы ожидаем быстрого развития в этой области, что приведет к более мощным и эффективным решениям на основе SLM.

Пример практического решения в области искусственного интеллекта

Узнайте, как искусственный интеллект может переосмыслить ваши процессы продаж и взаимодействие с клиентами. Рассмотрите AI Sales Bot от itinai.com/aisalesbot, разработанный для автоматизации взаимодействия с клиентами 24/7 и управления взаимодействием на всех этапах путешествия клиента.

Список полезных ссылок:

- AI Lab в Telegram @aiscrumbot – бесплатная консультация

- Реализация малых языковых моделей (SLMs) с RAG на встроенных устройствах, приводящая к снижению затрат, конфиденциальности данных и автономному использованию

- deepsense.ai

- Twitter – @itinaicom

«`