«`html

InternLM2.5-7B-Chat: Раскрытие крупных языковых моделей с непревзойденной логикой, обработкой длинных контекстов и улучшенным использованием инструментов

InternLM представил свое последнее достижение в области открытых больших языковых моделей — InternLM2.5-7B-Chat, доступную в формате GGUF. Эта модель совместима с llama.cpp, открытой средой для вывода LLM, и может использоваться локально и в облаке на различных аппаратных платформах. Формат GGUF предлагает версии с половинной точностью и квантованные низкобитовые версии, включая q5_0, q5_k_m, q6_k и q8_0.

InternLM2.5 развивается на основе своего предшественника и предлагает модель базовой части с 7 миллиардами параметров и модель чата, созданную для практических сценариев. Эта модель обладает современными возможностями рассуждения, особенно в математическом рассуждении, превосходя конкурентов, таких как Llama3 и Gemma2-9B. Он также имеет впечатляющее окно контекста длиной 1 млн., проявляя почти идеальное выполнение задач с длинным контекстом, таких как те, которые оцениваются LongBench.

Способность модели работать с длинными контекстами делает ее особенно эффективной в извлечении информации из обширных документов. Эта возможность усиливается в паре с LMDeploy, набором инструментов, разработанных командами MMRazor и MMDeploy для сжатия, развертывания и обслуживания LLM. Вариант InternLM2.5-7B-Chat-1M, предназначенный для вывода контекста длиной 1 млн., является примером этой силы. Эта версия требует значительных вычислительных ресурсов, таких как 4xA100-80G GPUs, для эффективной работы.

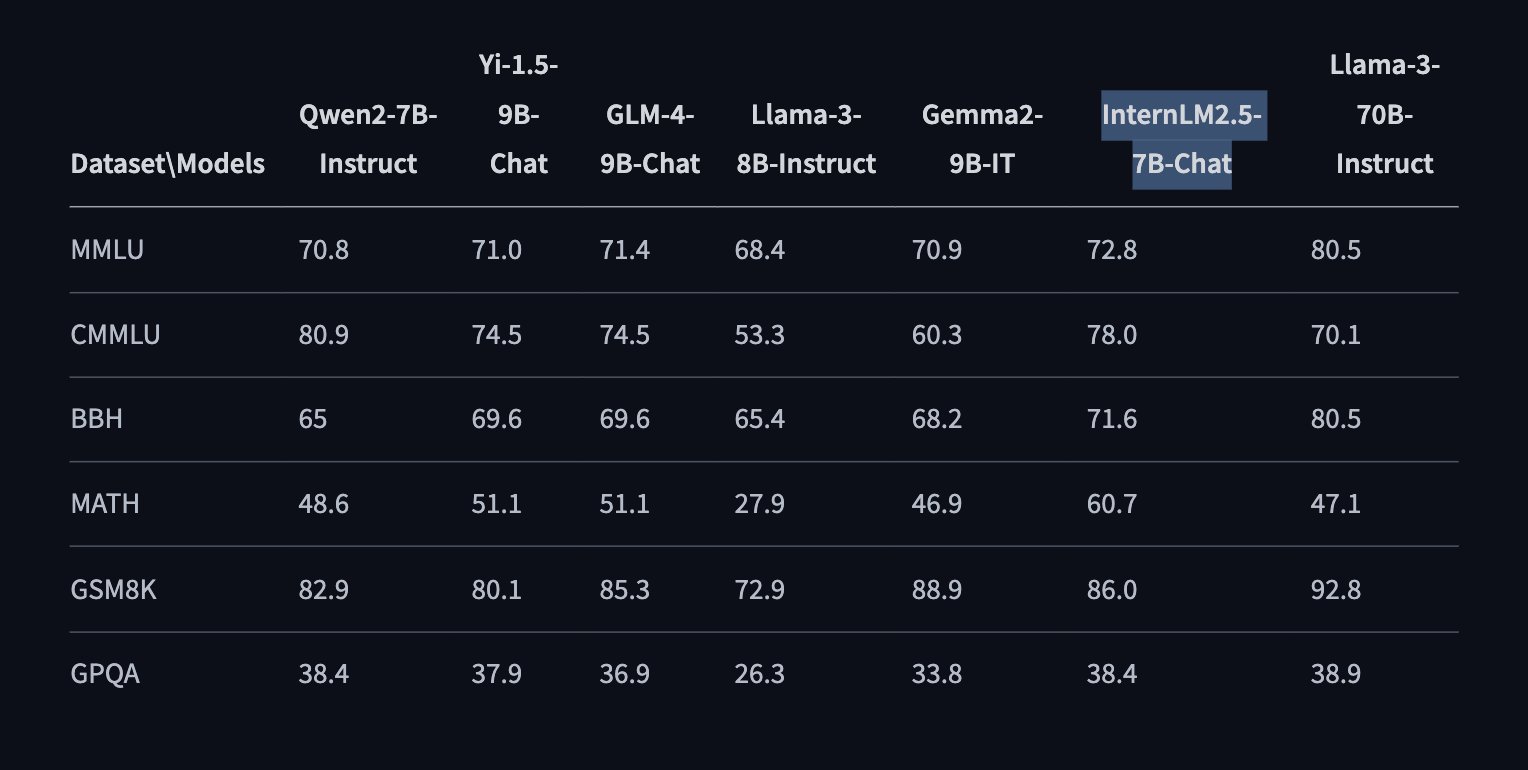

Оценки производительности, проведенные с использованием инструмента OpenCompass, выделяют компетентности модели по различным измерениям: дисциплинарная компетентность, языковая компетентность, компетентность знаний, компетентность вывода и компетентность понимания. В бенчмарках, таких как MMLU, CMMLU, BBH, MATH, GSM8K и GPQA, InternLM2.5-7B-Chat постоянно демонстрирует выдающуюся производительность по сравнению с конкурентами. Например, бенчмарк MMLU достигает показателя 72,8, превосходя модели, такие как Llama-3-8B-Instruct и Gemma2-9B-IT.

InternLM2.5-7B-Chat также отлично справляется с использованием инструментария, поддерживая получение информации из более чем 100 веб-страниц. Предстоящий релиз Lagent еще более улучшит эту функциональность, повышая возможности модели в следовании инструкциям, выборе инструментов и рефлексии.

Релиз модели включает подробное руководство по установке, инструкции по скачиванию модели, примеры вывода и развертывания модели. Пользователи могут выполнять пакетный оффлайн-вывод с квантованной моделью, используя lmdeploy, среду, поддерживающую только квантование INT4 весов и развертывание (W4A16). Эта настройка обеспечивает до 2,4-кратного ускорения вывода по сравнению с FP16 на совместимых GPU NVIDIA, включая серии 20, 30 и 40, а также A10, A16, A30 и A100.

Архитектура InternLM2.5 сохраняет прочные функции своего предшественника, внедряя новые технические инновации. Эти улучшения, основанные на большом корпусе синтетических данных и итеративном процессе обучения, приводят к модели с улучшенной производительностью рассуждения — с увеличением в 20% по сравнению с InternLM2. Эта итерация также сохраняет способность обрабатывать окна контекста в 1 млн. с почти полной точностью, что делает ее ведущей моделью для задач с длинным контекстом.

В заключение, с выпуском InternLM2.5 и его вариантов с передовыми возможностями рассуждения, обработкой длинных контекстов и эффективным использованием инструментов, InternLM2.5-7B-Chat обещает стать ценным ресурсом для различных применений как в исследовательских, так и в практических сценариях.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте InternLM2.5-7B-Chat.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь, какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru — будущее уже здесь!

«`