«`html

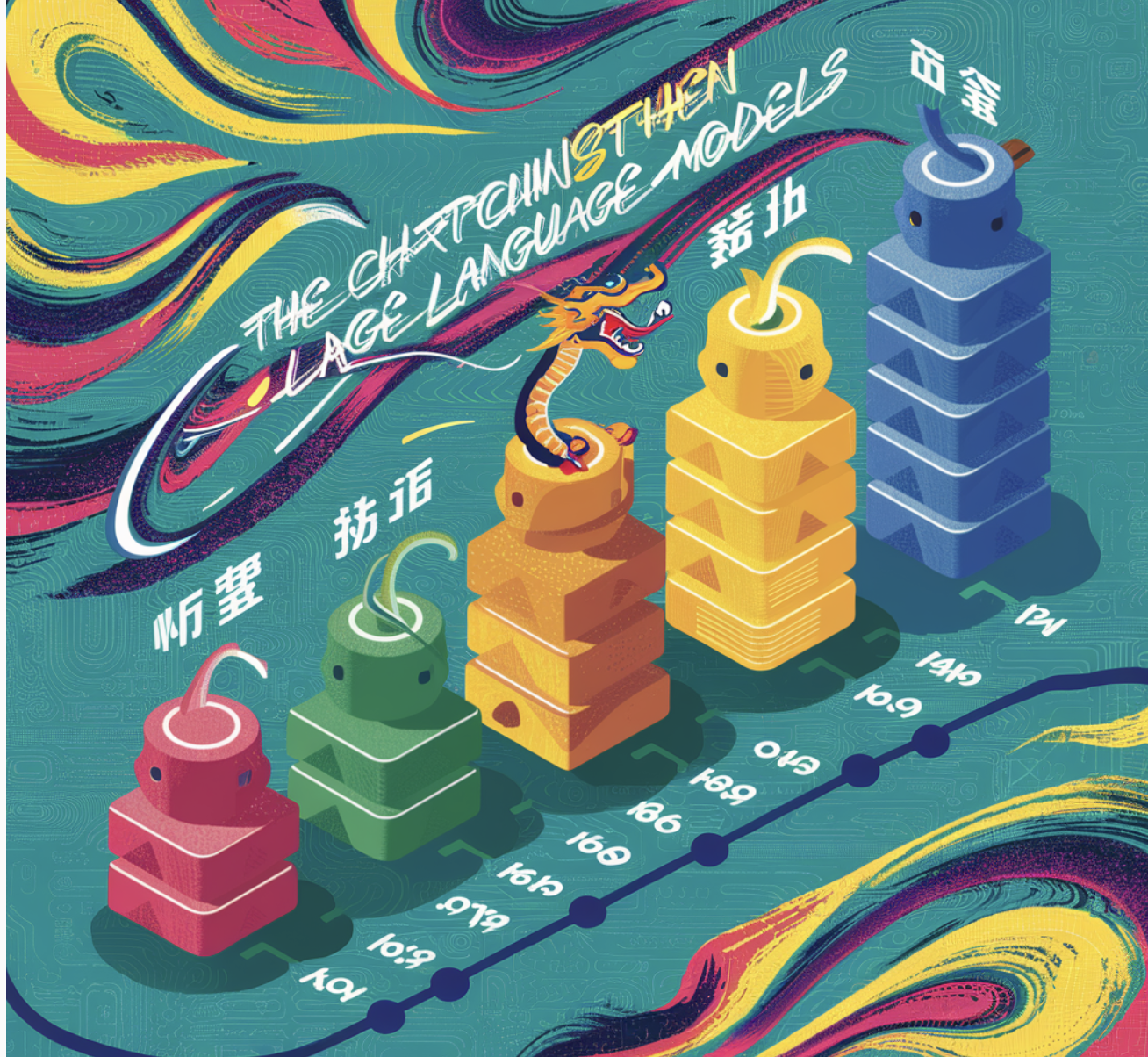

The Evolution of Chinese Large Language Models (LLMs)

В развитии предобученных языковых моделей произошел значительный прогресс за последние годы, особенно с появлением масштабных моделей. Для языков, таких как английский, не страдает от недостатка открытых чат-моделей с открытым исходным кодом. Однако китайский язык не видел эквивалентного прогресса. Для устранения этого разрыва было представлено несколько китайских моделей, демонстрирующих инновационные подходы и достигающих замечательных результатов. В этой статье обсуждаются некоторые из наиболее известных китайских крупных языковых моделей (LLM).

Yi

Семейство моделей Yi хорошо известно своими многомерными возможностями, от базовых языковых моделей до мультимодальных приложений. Модели Yi с 34B и 6B параметрами показывают хорошие результаты на таких бенчмарках, как MMLU. Визуально-языковые модели в этом семействе объединяют семантические языковые пространства с визуальными представлениями с использованием творческой инженерии данных и масштабной инфраструктуры суперкомпьютеров. Предварительное обучение моделей на массивном корпусе из 3,1 трлн токенов гарантирует надежные результаты и высокую производительность в ряде задач.

QWEN

Вместе с базовыми предварительно обученными моделями и улучшенными моделями разговоров QWEN представляет собой полную коллекцию языковых моделей. Серия QWEN проявляет исключительную производительность в различных задачах. Использование обучения с подкреплением от обратной связи человека (RLHF) в чат-моделях делает их особенно выдающимися. Эти модели конкурентоспособны даже по сравнению с более крупными моделями, так как они проявляют сложные навыки использования инструментов и планирования.

DeepSeek-V2

DeepSeek-V2 — это модель «смесь экспертов» (MoE), которая обеспечивает сбалансированную мощную производительность и экономичную работу. С длиной контекста 128 тыс. токенов DeepSeek-V2 позволяет 236 млрд параметров, из которых только 21 млрд активируются на токен. Благодаря использованию архитектур DeepSeekMoE и Multi-head Latent Attention (MLA) модель достигает значительного увеличения эффективности, снижая затраты на обучение на 42,5% и увеличивая производительность.

WizardLM

WizardLM использует LLM вместо ручного ввода человека, чтобы преодолеть сложность создания данных с высокой сложностью инструкций. Модель итеративно переписывает инструкции, увеличивая сложность с использованием уникальной техники под названием Evol-Instruct. Когда LLaMA донастраивается с использованием этих данных, создается WizardLM, который проявляет себя лучше, чем инструкции, созданные людьми, в оценках, проведенных людьми. Кроме того, модель благоприятно сравнивается с ChatGPT от OpenAI.

GLM-130B

Мультиязычная (английский и китайский) модель GLM-130B с 130 млрд параметров конкурирует с моделью GPT-3 (Davinci) по производительности. GLM-130B превосходит ERNIE TITAN 3.0 на китайских бенчмарках и превосходит несколько ключевых моделей на английских бенчмарках, преодолевая различные технологические препятствия во время обучения. Благодаря свойству специального масштабирования, которое позволяет квантизацию INT4 без потерь производительности после обучения, это очень эффективный вариант для развертывания крупномасштабных моделей.

CogVLM

CogVLM — это сложная визуальная языковая модель, архитектура которой полностью интегрирует элементы визуального и языкового восприятия. CogVLM использует обучаемый визуальный экспертный модуль, в отличие от поверхностных методов выравнивания, и достигает современной производительности на нескольких кросс-модальных бенчмарках. Великолепная производительность и универсальность модели демонстрируются разнообразием поддерживаемых приложений, включая визуальное выравнивание и описание изображений.

Baichuan-7B

С 4-битными весами и 16-битными активациями модели Baichuan-7B оптимизированы для развертывания на устройствах и достигают современной производительности на китайских и английских бенчмарках. Квантизация Baichuan-7B делает ее подходящей для множества применений, обеспечивая эффективную и эффективную работу в практических ситуациях.

InternLM

Китайский, английский и задачи программирования — это области, в которых блестяще проявляется InternLM, мультиязычная модель на 100 млрд параметров, обученная на более чем триллионе токенов. Усовершенствованная с помощью высококачественных данных аннотированного человеком диалога и технологии RLHF, InternLM производит ответы, соответствующие морали и человеческим ценностям, что делает его отличным вариантом для сложных обменов.

Skywork-13B

С 3,2 трлн токенов в своем арсенале Skywork-13B является одной из самых широко обученных двуязычных моделей. Он успешно справляется с задачами общего назначения и специфической области с помощью двухэтапной методики обучения. Кроме того, этот подход решает проблемы загрязнения данных и представляет уникальную технику обнаружения утечек с целью демократизации доступа к высококачественным LLM.

ChatTTS

Генеративная модель текста в речь с поддержкой китайских и английских диалоговых сценариев — ChatTTS. ChatTTS обеспечивает чрезвычайно точный и естественно звучащий речевой вывод, обученный на более чем 100 000 часов речевых данных.

Hunyuan-DiT

Hunyuan-DiT — это трансформатор диффузии текста в изображение, который проявляет исключительную производительность в тонкой компрессии китайского и английского. Архитектура модели тщательно разработана для максимизации производительности, включая ее позиционное кодирование, текстовый кодировщик и структуру трансформатора. Hunyuan-DiT получает преимущество от обширного конвейера данных, который облегчает итеративную оптимизацию модели путем непрерывной оценки и модификаций.

ERNIE 3.0

ERNIE 3.0 устраняет ограничения обычных предварительно обученных моделей, которые используют только обычный текст без внедрения дополнительных знаний. Модель проявляет себя хорошо в задачах, связанных как с созданием, так и с обработкой естественного языка благодаря комбинированной архитектуре авторегрессии и автоэнкодерных сетей. После обучения на 4 ТБ плоского корпуса и масштабного графа знаний 10-миллиардная модель превосходит самые передовые модели на 54 задачах обработки естественного языка на китайском языке. На бенчмарке SuperGLUE ее английский перевод достигает оптимальной производительности, превосходя даже человеческую производительность.

И МНОГОЕ ДРУГОЕ……

«`

**Обратите внимание на следующие предложения:**

1. **Подберите подходящее решение, сейчас очень много вариантов ИИ.** Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI. На полученных данных и опыте расширяйте автоматизацию.

2. **Если вам нужны советы по внедрению ИИ, пишите нам на [ссылка на телеграм](https://t.me/itinai)**. Следите за новостями о ИИ в нашем Телеграм-канале [ссылка на телеграм-канал](https://t.me/itinainews) или в Twitter @itinairu45358.

3. **Попробуйте [AI Sales Bot](https://itinai.ru/aisales)**. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

4. **Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab [itinai.ru](https://itinai.ru)**. будущее уже здесь!