«`html

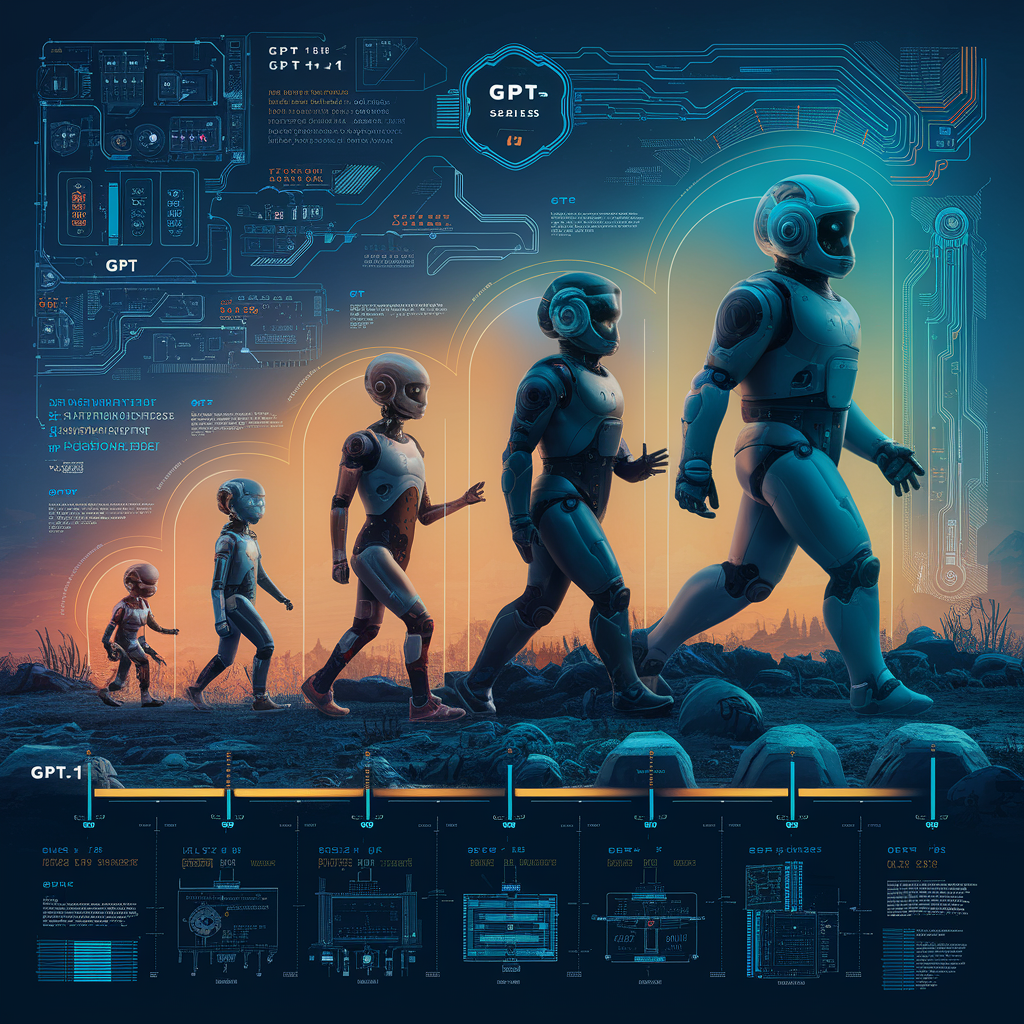

Эволюция серии GPT: технический обзор и показатели производительности от GPT-1 до GPT-4o

GPT-1: Начало

Модель GPT-1, запущенная в июне 2018 года, использовала архитектуру Transformer и обучалась на 40 ГБ текста из BooksCorpus. Она продемонстрировала потенциал трансферного обучения в NLP и достигла передовых результатов на нескольких бенчмарках.

GPT-2: Масштабирование

Модель GPT-2, выпущенная в феврале 2019 года, увеличила размер модели и объем обучающих данных, значительно улучшив генерацию текста и результаты на различных задачах NLP.

GPT-3: Игровой переворот

Модель GPT-3, представленная в июне 2020 года, поразила своим масштабом и возможностями, продемонстрировав человекоподобную генерацию и понимание текста.

GPT-3.5: Устранение разрыва

Модель GPT-3.5, представленная в ноябре 2022 года, улучшила контекстное понимание и эффективность, преодолев некоторые ограничения GPT-3.

GPT-4: Новые горизонты

Модель GPT-4, выпущенная в марте 2023 года, продолжила тенденцию масштабирования и улучшения, превзойдя GPT-3 в качестве генерации и понимания текста.

GPT-4o: Оптимизированная и эффективная

Модель GPT-4o, выпущенная в мае 2024 года, представляет собой оптимизированную версию GPT-4, обеспечивающую высокую производительность при более эффективном использовании ресурсов.

Технические исследования

Архитектура Transformer, масштабирование моделей и эффективность обучения — ключевые аспекты, определяющие успех серии GPT.

Влияние и применение

Серия GPT оказала глубокое влияние на различные области, включая создание контента, поддержку клиентов, образование и исследования.

Заключение

Серия GPT представляет собой замечательное достижение в области искусственного интеллекта, обещающее еще больший потенциал в будущем.

Источники: OpenAI, arXiv, OpenAI

«`