«`html

Исследователи из Университета Колумбии и Databricks провели сравнительное исследование LoRA и полного донастройки в больших языковых моделях

Модели машинного обучения, содержащие миллиарды параметров, требуют сложных методов для эффективной настройки их производительности. Исследователи стремятся улучшить точность этих моделей, минимизируя необходимые вычислительные ресурсы. Это улучшение критически важно для практических применений в различных областях, таких как обработка естественного языка и искусственный интеллект, где эффективное использование ресурсов может значительно повлиять на общую производительность и осуществимость.

Проблема

Одной из значительных проблем в настройке LLM является значительная требуемая память GPU, делающая процесс дорогостоящим и ресурсоемким. Основное вызов заключается в разработке эффективных методов донастройки без ущерба для производительности модели. Эта эффективность особенно важна, поскольку модели должны адаптироваться к новым задачам, сохраняя свои ранее изученные возможности. Эффективные методы донастройки обеспечивают возможность использования больших моделей в различных приложениях без запредельных затрат.

Решение

Исследователи из Университета Колумбии и Databricks Mosaic AI исследовали различные методы решения этой проблемы, включая полную донастройку и параметрически эффективные методы донастройки, такие как Low-Rank Adaptation (LoRA). Полная донастройка включает в себя корректировку всех параметров модели, что является вычислительно затратным. В отличие от этого, LoRA нацелена на экономию памяти путем изменения только небольшого подмножества параметров, тем самым уменьшая вычислительную нагрузку. Несмотря на ее популярность, эффективность LoRA по сравнению с полной донастройкой была предметом дебатов, особенно в сложных областях, таких как программирование и математика, где точные улучшения производительности критичны.

Результаты

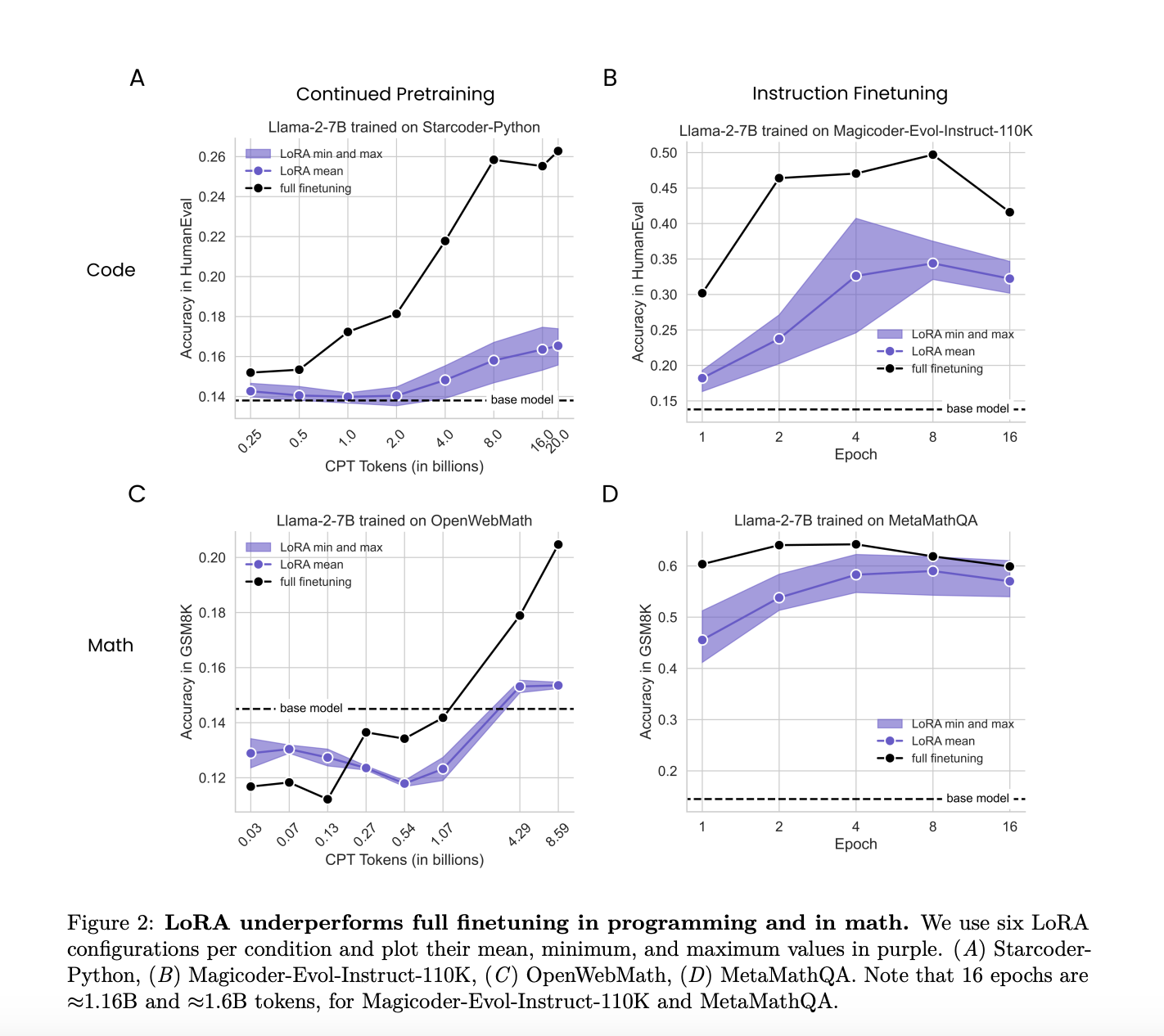

Исследование сравнило производительность LoRA и полной донастройки в двух целевых областях: программировании и математике. Оно учитывало донастройку инструкций, включающую приблизительно 100 000 пар запрос-ответ, и продолжение предварительного обучения с примерно 10 миллиардами неструктурированных токенов. Сравнение направлено на оценку того, насколько хорошо LoRA и полная донастройка адаптируются к этим конкретным областям, учитывая различные режимы данных и сложность задач. Это подробное сравнение предоставило детальное понимание преимуществ и недостатков каждого метода в различных условиях.

Исследователи обнаружили, что LoRA в целом проигрывает по сравнению с полной донастройкой в задачах программирования и математики. Несмотря на это, LoRA обеспечивает полезную форму регуляризации, которая помогает поддерживать производительность базовой модели в задачах за пределами целевой области. Этот эффект регуляризации сильнее, чем у обычных техник, таких как уменьшение веса и отсев, что делает LoRA выгодным при сохранении производительности базовой модели, что критически важно.

Подробный анализ показал, что полная донастройка приводила к весовым возмущениям, в 10-100 раз больше, чем обычно используемые в LoRA конфигурациях. Это значительное различие в ранге, вероятно, объясняет некоторые наблюдаемые различия в производительности. Исследование показало, что более низкие весовые возмущения LoRA способствовали поддержанию более разнообразных генераций выходных данных, чем полная донастройка, часто приводя к ограниченным решениям. Это разнообразие в выходных данных полезно в приложениях, требующих разнообразных и креативных решений.

В заключение, хотя LoRA менее эффективна, чем полная донастройка по точности и эффективности выборки, она предлагает значительные преимущества в регуляризации и эффективности памяти. Исследование предлагает оптимизацию гиперпараметров, таких как скорости обучения и целевых модулей, и понимание компромиссов между обучением и забыванием, чтобы улучшить применение LoRA к конкретным задачам.

Исследование подчеркивает, что хотя полная донастройка в целом работает лучше, способность LoRA поддерживать возможности базовой модели и генерировать разнообразные выходные данные делает ее ценной в определенных контекстах. Это исследование предоставляет важные идеи по балансировке производительности и вычислительной эффективности в донастройке LLM, предлагая путь к более устойчивому и универсальному развитию ИИ.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему ML SubReddit.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте исследование Researchers from Columbia University and Databricks Conducted a Comparative Study of LoRA and Full Finetuning in Large Language Models.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`